本文主要是介绍cachetools,一个超酷的 Python 库!,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

更多Python学习内容:ipengtao.com

大家好,今天为大家分享一个超酷的 Python 库 - cachetools。

Github地址:https://github.com/tkem/cachetools

在数据密集型应用中,缓存是优化性能和响应速度的关键技术之一。Python的cachetools库提供了一套灵活且强大的工具,用于在Python项目中实现缓存机制。本文将全面介绍cachetools的安装、特性、基本与高级功能,并结合实际应用场景,展示其在项目中的应用。

安装

安装cachetools库相对简单,可以通过pip命令直接安装:

pip install cachetools这条命令将从Python包索引(PyPI)下载并安装cachetools及其依赖。

特性

多种缓存策略:支持LRU(最近最少使用)、LFU(最少使用频率)和TTL(时间戳限制)等多种缓存策略。

易于集成:提供简洁的API,易于在现有Python应用中集成和使用。

高效性能:通过有效的数据结构支持高效的数据插入和查询操作。

基本功能

创建缓存

cachetools支持多种缓存策略,如最近最少使用(LRU)、最少使用频率(LFU)、时间到期(TTL)等。

from cachetools import LRUCache, LFUCache, TTLCache# 创建LRU缓存

lru_cache = LRUCache(maxsize=100)# 创建LFU缓存

lfu_cache = LFUCache(maxsize=100)# 创建TTL缓存,指定生存时间为5秒

ttl_cache = TTLCache(maxsize=100, ttl=5)使用装饰器添加缓存

使用cachetools提供的装饰器简化缓存的使用,自动管理缓存的存储和检索。

from cachetools import cached, LRUCache# 定义缓存

cache = LRUCache(maxsize=100)# 使用装饰器自动缓存函数的结果

@cached(cache)

def get_resource(key):print("Fetching from source...")return f"Data for {key}"# 首次调用将计算结果并存入缓存

result = get_resource('python')

print(result) # 输出从源获取的数据# 再次调用将直接从缓存获取数据

cached_result = get_resource('python')

print(cached_result) # 输出缓存中的数据缓存过期和清理

管理缓存的生命周期,例如在TTLCache中处理过期的缓存。

from cachetools import TTLCache

import time# 创建带有时间限制的缓存

ttl_cache = TTLCache(maxsize=2, ttl=2)# 添加数据到缓存

ttl_cache['key1'] = 'value1'

time.sleep(1) # 等待1秒# 访问未过期的数据

print(ttl_cache.get('key1')) # 输出 'value1'time.sleep(2) # 再等待2秒,超过TTL# 尝试访问已过期的数据

print(ttl_cache.get('key1')) # 输出 None,因为数据已过期高级功能

缓存的自定义逻辑

cachetools允许用户创建自定义的缓存类,通过继承和修改现有的缓存策略类来满足特定需求。

from cachetools import Cacheclass CustomCache(Cache):def __init__(self, maxsize, getsizeof=None):super().__init__(maxsize, getsizeof)self.cache = {}def __getitem__(self, key):return self.cache[key]def __setitem__(self, key, value):if len(self.cache) >= self.maxsize:# 自定义替换逻辑:删除最早添加的项oldest_key = next(iter(self.cache))del self.cache[oldest_key]self.cache[key] = valuedef __delitem__(self, key):del self.cache[key]def __contains__(self, key):return key in self.cachedef __len__(self):return len(self.cache)# 使用自定义缓存

custom_cache = CustomCache(maxsize=2)

custom_cache['a'] = 1

custom_cache['b'] = 2

custom_cache['c'] = 3 # 会触发自定义逻辑,删除'a'print(custom_cache.cache) # 输出: {'b': 2, 'c': 3}缓存统计

cachetools支持缓存统计功能,可以追踪缓存命中、未命中等事件,帮助分析和优化缓存策略。

from cachetools import LRUCachecache = LRUCache(maxsize=2)

cache.cache_info() # 获取缓存的统计信息@cached(cache)

def fetch_data(key):return f"data for {key}"# 模拟缓存使用

fetch_data(1)

fetch_data(2)

fetch_data(1) # 命中缓存

fetch_data(3)

fetch_data(2) # 命中缓存

fetch_data(1)print(cache.cache_info()) # 输出缓存的命中次数和未命中次数缓存参数化装饰器

使用cachetools的装饰器功能,可以根据函数参数动态管理缓存。

from cachetools import cachedmethod

from cachetools.keys import hashkeyclass DataLoader:def __init__(self):self.cache = LRUCache(maxsize=10)@cachedmethod(lambda self: self.cache, key=lambda _, key: hashkey(key))def load(self, key):print(f"Loading data for {key}")return f"data for {key}"loader = DataLoader()

loader.load(1)

loader.load(1) # 命中缓存

loader.load(2)实际应用场景

Web服务缓存

在Web开发中,使用cachetools来缓存常用数据是提升页面加载速度和减少数据库访问压力的常见做法。

例如,缓存用户的配置信息,减少每次请求时的数据库查询。

from cachetools import TTLCache

from flask import Flask, requestapp = Flask(__name__)

config_cache = TTLCache(maxsize=100, ttl=300) # 5分钟过期@app.route("/get_user_config")

def get_user_config():user_id = request.args.get("user_id")if user_id in config_cache:config = config_cache[user_id] # 从缓存中获取配置else:config = fetch_config_from_db(user_id) # 从数据库获取配置config_cache[user_id] = config # 存入缓存return configdef fetch_config_from_db(user_id):# 模拟数据库查询return f"Config for user {user_id}"if __name__ == "__main__":app.run()数据科学和分析

在数据科学中,缓存可以用于存储重复计算的结果,尤其是在处理大数据集时。

例如,缓存机器学习模型的预测结果。

from cachetools import LRUCache

import pandas as pd

import numpy as np# 模拟一个数据处理函数,可能包括复杂的数据转换和模型预测

def process_data(data):# 假设这里有复杂的数据处理逻辑return np.mean(data)data_cache = LRUCache(maxsize=100)def get_processed_data():data = pd.Series(np.random.rand(100))data_hash = hash(tuple(data))if data_hash in data_cache:result = data_cache[data_hash] # 命中缓存else:result = process_data(data)data_cache[data_hash] = result # 更新缓存return result高性能计算

在高性能计算场景中,cachetools用于缓存计算结果,特别是在并行计算环境下。

例如,缓存计算密集型任务的结果,避免重复计算。

from cachetools import LRUCache

from functools import lru_cache@lru_cache(maxsize=100)

def compute_expensive_operation(x):# 模拟一个计算密集型操作result = 0for i in range(1000000):result += (x + i) ** 2return result# 调用计算函数,结果会被缓存

result = compute_expensive_operation(5)总结

Python cachetools库是一个非常实用的缓存工具,它提供了多种缓存策略,包括最近最少使用(LRU)、最少使用频率(LFU)、时间到期(TTL)等,满足不同应用场景的需求。这个库使得Python开发者能够轻松实现数据缓存,从而优化程序性能,减少对外部数据源如数据库的请求次数,显著提高应用的响应速度和效率。cachetools的API简洁明了,易于集成和使用,非常适合用于Web服务、数据科学、高性能计算等领域,尤其是在处理需要频繁访问的数据时。此外,cachetools还支持高级功能如自定义缓存策略和缓存统计,为开发者提供了更大的灵活性和控制能力。

如果你觉得文章还不错,请大家 点赞、分享、留言 下,因为这将是我持续输出更多优质文章的最强动力!

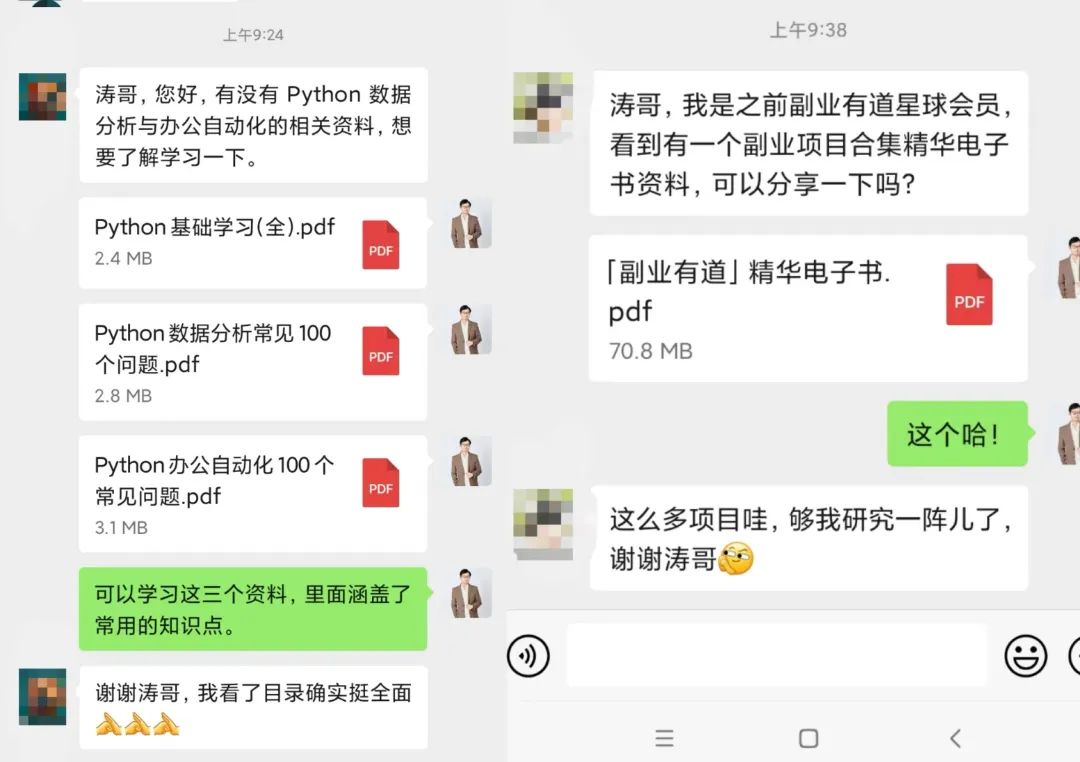

如果想要系统学习Python、Python问题咨询,或者考虑做一些工作以外的副业,都可以扫描二维码添加微信,围观朋友圈一起交流学习。

我们还为大家准备了Python资料和副业项目合集,感兴趣的小伙伴快来找我领取一起交流学习哦!

往期推荐

历时一个月整理的 Python 爬虫学习手册全集PDF(免费开放下载)

Python基础学习常见的100个问题.pdf(附答案)

学习 数据结构与算法,这是我见过最友好的教程!(PDF免费下载)

Python办公自动化完全指南(免费PDF)

Python Web 开发常见的100个问题.PDF

肝了一周,整理了Python 从0到1学习路线(附思维导图和PDF下载)

这篇关于cachetools,一个超酷的 Python 库!的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!