本文主要是介绍今天遇到一个GPT解决不了的问题,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

问题描述

你好,postman的一个post请求,编辑器里面放了一个很长的json数据,报Tokenization is skipped for long lines for performance reasons. This can be configured via editor.maxTokenizationLineLength.,但是同样的数据,在另一台电脑的就不会有这个错误

GPT 回答

你好,这个报错信息是Postman在处理POST请求时给出的提示。当你的JSON数据在请求体中包含过长的单行时,为了保证性能,Postman默认会跳过对过长行的语法高亮(Tokenization)处理。"Tokenization"在这里指的是将输入的文本分割成有意义的符号或词汇(tokens),以便进行语法高亮和代码智能提示等。

你可以通过调整Postman的设置来改变这一行为。具体做法如下:

- 打开Postman应用程序。

- 点击顶部菜单栏的

Settings(齿轮图标)。- 在设置面板中选择

Editor选项。- 在

Editor设置区域,你会看到Max Tokenization Line Length这个选项,可以在此处增大其默认值,以便Postman能够处理更长的单行JSON数据。版本不一样,可能设置的地方不一样,如果从上面没有找到设置项,可以找Settings看看

但是并没有editor.maxTokenizationLineLength的设置选项

那就试图模拟错误场景

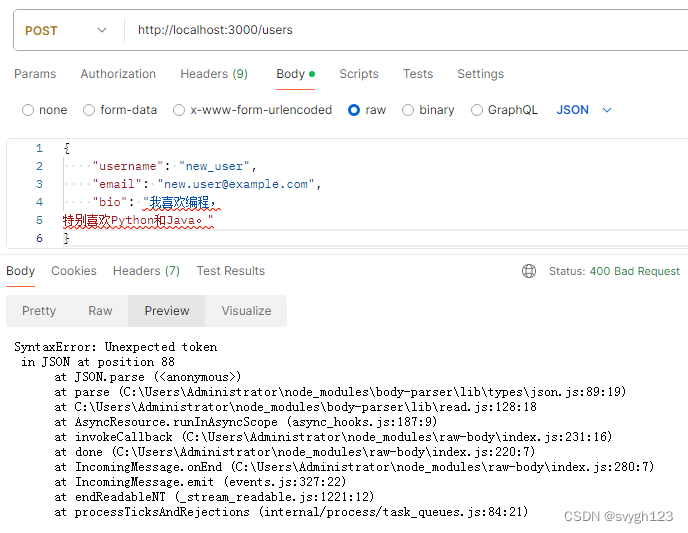

用Postman向一个RESTful API接口发送POST请求,创建一个新的用户记录。API要求JSON格式的数据,而你的请求体Raw Data中包含了未经转义的特殊字符:

POST http://localhost:3000/users{"username": "new_user","email": "new.user@example.com","bio": "我喜欢编程, 特别喜欢Python和Java。" }在这个例子中,"bio"字段的内容包含了一个未经转义的换行符,这在JSON中是不允许的。

然后,在服务器端用Node.js和Express模拟这样一个接口:

const express = require('express'); const app = express(); const bodyParser = require('body-parser');app.use(bodyParser.json({ type: 'application/json' }));app.post('/users', (req, res) => {try {const user = req.body;// 检查接收到的JSON数据是否有效,这里假设有一个数据库操作console.log("Received user data:", user);// 如果bio字段包含未经转义的换行符,这段代码会抛出错误JSON.stringify(user.bio);// 在实际应用中,这里可能是保存到数据库的操作res.status(201).json({ message: 'User created successfully' });} catch (error) {res.status(400).json({ error: 'Invalid characters in bio field. Control characters must be escaped.' });} });app.listen(3000, () => console.log('Server listening on port 3000'));运行后得到如下结果

并没有得到和题主一样的错误。

有些问题还是需要有真实场景才能复现。

问题来源:

postman 长行将跳过标记化_测试-CSDN问答

这篇关于今天遇到一个GPT解决不了的问题的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!