本文主要是介绍推荐七个Python效率工具!,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

为了提高效率,我们在平时工作中常会用到一些Python的效率工具,Python作为比较老的编程语言,它可以实现日常工作的各种自动化。为了更便利的开发项目,这里给大家推荐几个Python的效率工具。

1、Pandas-用于数据分析

Pandas是一个强大的分析结构化数据的工具集;它的使用基础是Numpy(提供高性能的矩阵运算);用于数据挖掘和数据分析,同时也提供数据清洗功能。

# 1、安装包

$ pip install pandas

# 2、进入python的交互式界面

$ python -i

# 3、使用Pandas>>> import pandas as pd>>> df = pd.DataFrame() >>> print(df)

# 4、输出结果

Empty DataFrame

Columns: []

Index: []

2、Selenium-自动化测试

Selenium是一个用于Web应用程序测试的工具,可以从终端用户的角度来测试应用程序。通过在不同浏览器中运行测试,更容易发现浏览器的不兼容性。并且它适用许多浏览器。

可以通过打开浏览器并访问Google的主页做一个简单的测试:

from selenium import webdriver import time browser = webdriver.Chrome(executable_path ="C:\Program Files (x86)\Google\Chrome\chromedriver.exe") website_URL ="https://www.google.co.in/" brower.get(website_URL) refreshrate = int(3) #每3秒刷新一次Google主页。 # 它会一直运行,直到你停掉编译器。 while True: time.sleep(refreshrate) browser.refresh()

3、 Flask——微型Web框架

Flask是一个轻量级的可定制框架,使用Python语言编写,较其他同类型框架更为灵活、轻便、安全且容易上手。Flask是目前十分流行的web框架。开发者可以使用Python语言快速实现一个网站或Web服务。

from flask import Flask

app = Flask(__name__) @app.route('/')

def hello_world(): return 'Hello, World!'

4、 Scrapy——页面爬取

Scrapy能够为你提供强大支持,使你能够精确地从网站中爬取信息。是非常实用。

现在基本上大部分开发者都会利用爬虫工具来实现爬取工作的自动化。所以编写爬虫编码时就可以用到这个Scrapy。

启动Scrapy Shell也是十分的简单:

scrapy shell

我们可以试着提取百度主页上搜索按钮的值,首先要找到按钮使用的类,一个inspect element显示该类为“ bt1”。

具体执行以下操作:

response = fetch("https://baidu.com") response.css(".bt1::text").extract_first() ==> "Search"

5、 Requests——做API调用

Requests是一个功能强大的HTTP库。有了它可以轻松地发送请求。无需手动向网址添加查询字符串。除此之外还有许多功能,比如authorization处理、JSON / XML解析、session处理等。

官方例子:

>>> r = requests.get('https://api.github.com/user', auth=('user', 'pass'))

>>> r.status_code

200

>>> r.headers['content-type']

'application/json; charset=utf8'

>>> r.encoding

'utf-8'

>>> r.text

'{"type":"User"...'

>>> r.json()

{'private_gists': 419, 'total_private_repos': 77, ...}

6、Faker-用于创建假数据

Faker是一个Python包,为您生成假数据。无论是需要引导数据库、创建好看的 XML 文档、填写您的持久性来强调测试它,还是从生产服务中获取的同名数据,Faker 都适合您

有了它,你可以非常快速地生成假的names、addresses、descriptions等!以下脚本为例,我创建一个联系人条目,包含了姓名、地址和一些描述文本:

安装:

pip install Faker from faker import Faker

fake = Faker()

fake.name()

fake.address()

fake.text()

7、 Pillow-进行图像处理

Python图像处理工具——Pillow有相当强大的图像处理功能。当平时需要做图像处理时就可以用到,毕竟作为开发人员,应该选择功能更强大的图片处理工具。

简单示例:

from PIL import Image, ImageFilter try: original = Image.open("Lenna.png") blurred = original.filter(ImageFilter.BLUR) original.show() blurred.show() blurred.save("blurred.png") except: print "Unable to load image"

有效的工具可以帮助我们更快捷地完成工作任务,所以就给大家分享几个认为好用的工具,也希望这7个Python的效率工具能够帮助到你。

学习资源推荐

除了上述分享,学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

包括:Python激活码+安装包、Python web开发,Python爬虫,Python数据分析,人工智能、自动化办公等学习教程。带你从零基础系统性的学好Python!

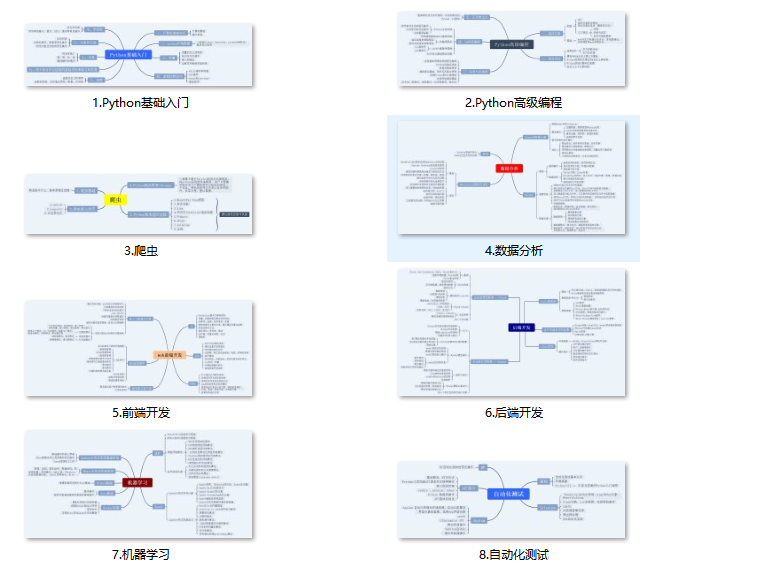

👉Python所有方向的学习路线👈

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(全套教程文末领取)

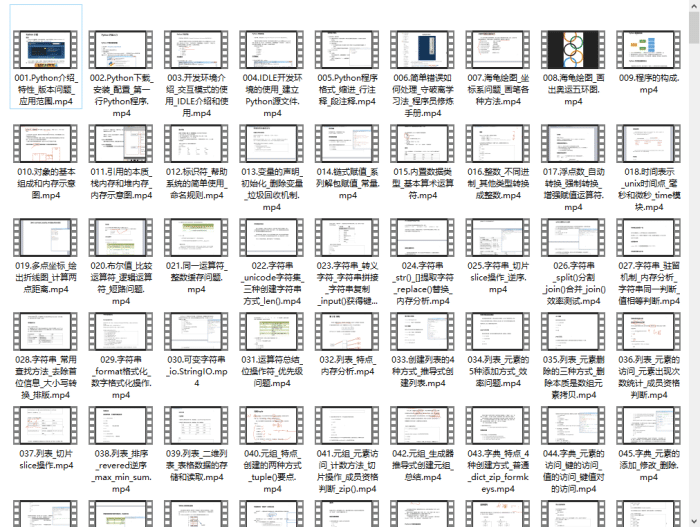

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉Python70个实战练手案例&源码👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉Python大厂面试资料👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

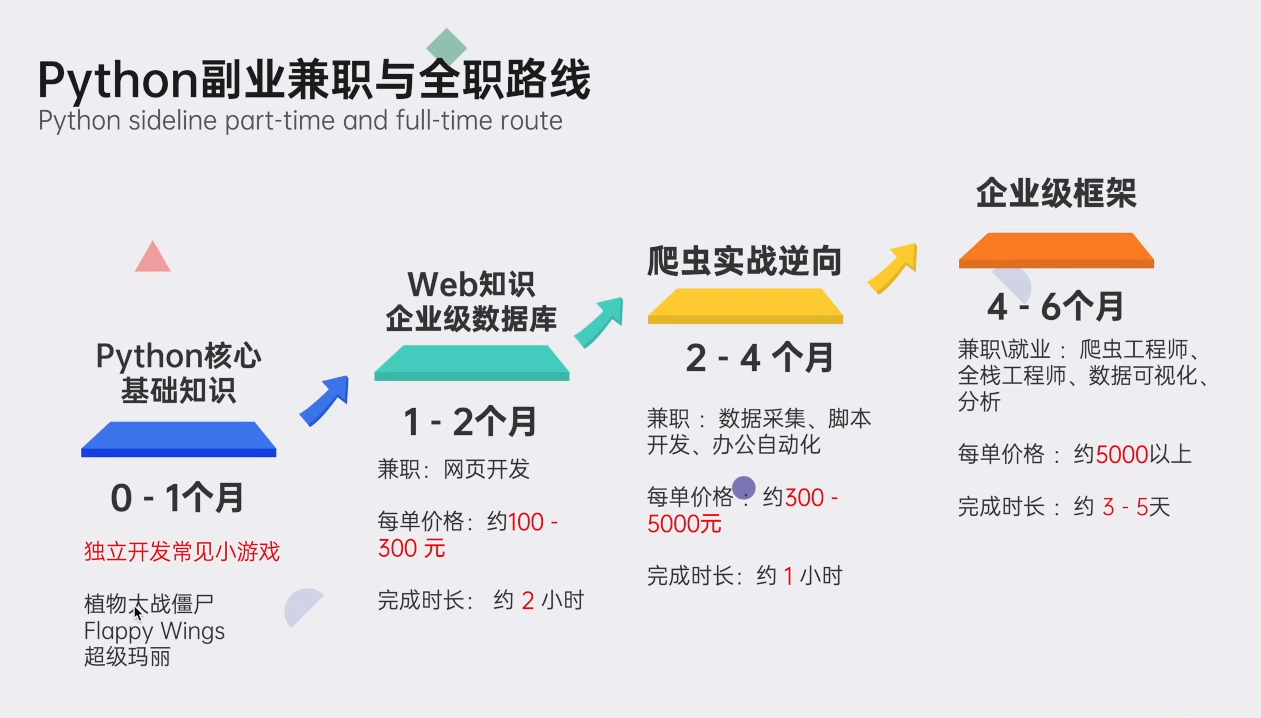

👉Python副业兼职路线&方法👈

学好 Python 不论是就业还是做副业赚钱都不错,但要学会兼职接单还是要有一个学习规划。

👉 这份完整版的Python全套学习资料已经上传,朋友们如果需要可以V扫描下方二维码联系领取

【保证100%免费】

这篇关于推荐七个Python效率工具!的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!