本文主要是介绍马斯克开源Grok-1:3140亿参数是GPT3.5的2倍【附保存通道】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

普通人:财富机会来了。马斯克将3410亿参数AI语言模型开源,这是目前世界上最大的开源模型,权重架构全开放,截至目前可用于商用。

6个月内成功研发出了拥有3410亿参数的大型自研模型,马斯克实现了他的承诺!据智东西3月18日的报道,马斯克旗下的AI创企xAI正式发布了备受期待的大型模型Grok-1,其参数量高达3140亿,远超过OpenAI GPT-3.5的1750亿。

这是目前参数规模最大的开源自然语言模型,遵循Apache 2.0协议,开放模型权重和架构供人使用。这一举措将对自然语言处理领域产生深远影响。

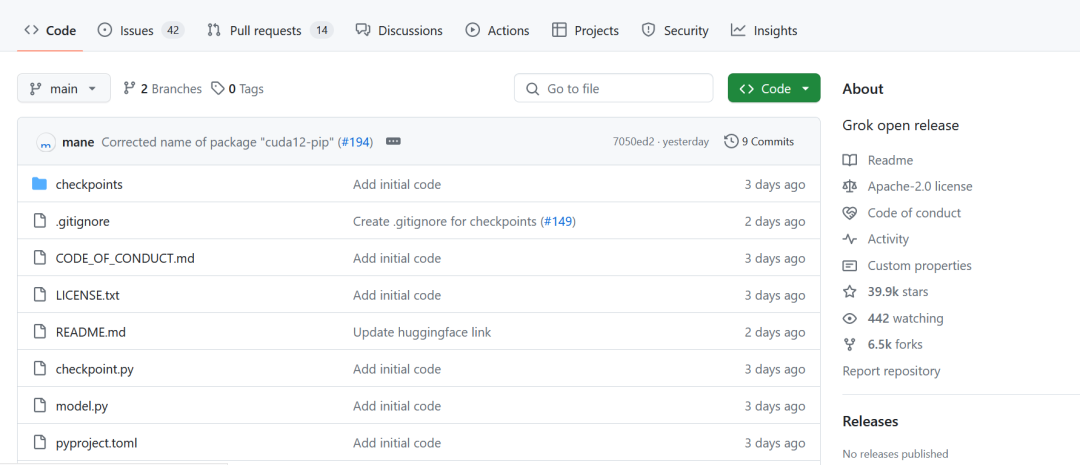

Grok-1是一个采用混合专家(Mixture-of-Experts,MOE)架构的大型模型。MOE架构的关键在于提高大型模型的训练和推理效率。可以形象地理解,MOE就像将各个领域的“专家”汇集在一起,根据任务将其分配给不同领域的专家,最后综合他们的结论以提升效率。这种架构决定每个专家的任务分配,使用了被称为“门控网络”机制。xAI已经在GitHub上开源了Grok-1的权重和架构,这将有助于推动自然语言处理领域的研究和发展。

目前Grok-1的源权重数据大小大约为300GB。截至北京时间3月22日上午7时许,Grok-1项目收获了39.9千颗星。

Grok-1是马斯克旗下xAI自2023年7月12日成立以来发布的首个自研大型模型。xAI强调这是他们从头开始训练的大模型,并没有针对特定应用进行微调。xAI作为马斯克去年成立的明星AI创企之一,旨在与OpenAI、谷歌、微软等竞争对手在大型模型领域展开竞争。xAI的团队来自各大知名企业和研究机构,如OpenAI、谷歌DeepMind、谷歌研究院、微软研究院等。在公布更多关于Grok-1的细节时,xAI指出基础模型是基于大量文本数据训练的,未针对特定任务进行微调。Grok-1是一个拥有3140亿参数的Mixture-of-Experts模型,其中每个token的活跃权重比例为25%。xAI从2023年10月开始使用自定义训练堆栈在JAX和Rust之上从头训练Grok-1。尽管xAI并没有公布Grok-1的具体测试成绩,但与OpenAI即将发布的GPT-5的大型模型的竞争将成为业内关注焦点。同时,马斯克和ChatGPT官方账号之间的互动也引起了关注,展示了在AI领域的竞争与幽默之间的趣味交流。

马斯克当然不会示弱,立即反问请告诉我OpenAI在哪些方面表现得“开放”?而马斯克高仿号也随即跳出来加入讨论,指出大家都知道是Sam在运营ChatGPT的账号。此次xAI发布Grok-1消息时所使用的封面图片是由Midjourney生成的。Grok-1给出了一个提示文本:一个神经网络的3D插图,展示具有透明节点和发光连接的神经网络,显示不同粗细和颜色的连接线代表不同权重。

获取保存通道👇👇👇

公众号:「吉吉说安全」,对我发消息【20240322】获取Grok-1保存通道

免费红队知识库:

会持续给大家更新更好东西,期待得到你随手免费的

【点赞】【在看】【转发】

今年肯定能“一帆风顺,二龙腾飞,三羊开泰,四季平安,五福临门,六六大顺,七星高照,八方来财,九九同心,十全十美,百事亨通,千事吉祥,万事如意“。

免责声明

由于传播、利用本公众号所提供的信息而造成的任何直接或者间接的后果及损失,均由使用者本人负责,本公众号及作者不为此承担任何责任,一旦造成后果请自行承担!如有侵权烦请告知,我们会立即删除并致歉。谢谢!

这篇关于马斯克开源Grok-1:3140亿参数是GPT3.5的2倍【附保存通道】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!