本文主要是介绍kafka_3.7.0+redpanda,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、环境说明

| IP | 操作系统 | 服务 |

|---|---|---|

| 192.168.11.100 | CentOs 7 | kafka , kowl |

| 192.168.11.101 | CentOs 7 | kafka |

| 192.168.11.102 | CentOs 7 | kafka |

二、安装docker

略。。。

三、安装kafka

path=/data/kafka

mkdir -p ${path}/{data,etc,log}

chown -R 5000 ${path}# KAFKA_NODE_ID、 KAFKA_CFG_ADVERTISED_LISTENERS 、 KAFKA_CFG_CONTROLLER_QUORUM_VOTERS 根据实际情况填写

cat > ${path}/start.sh << 'EOF'

#!/bin/bash

cd `dirname $0`docker rm -f kafkadocker run -d \

--name kafka \

--restart=always \

--net host \

--user 5000 \

--add-host=logaudit_kafka_01:192.168.11.100 \

--add-host=logaudit_kafka_02:192.168.11.101 \

--add-host=logaudit_kafka_03:192.168.11.102 \

-e KAFKA_NODE_ID=1 \

-e KAFKA_CFG_ADVERTISED_LISTENERS=PLAINTEXT://logaudit_kafka_01:9092 \

-e KAFKA_DAEMON_USER=5000 \

-e KAFKA_DAEMON_GROUP=5000 \

-e KAFKA_HEAP_OPTS="-Xmx512m -Xms512m" \

-e KAFKA_CFG_PROCESS_ROLES=broker,controller \

-e KAFKA_CFG_CONTROLLER_LISTENER_NAMES=CONTROLLER \

-e KAFKA_CFG_SASL_MECHANISM_CONTROLLER_PROTOCOL=PLAIN \

-e KAFKA_CONTROLLER_USER=contr0ller \

-e KAFKA_CONTROLLER_PASSWORD=Contr0ller#XXXX \

-e KAFKA_CFG_LISTENER_SECURITY_PROTOCOL_MAP=PLAINTEXT:SASL_PLAINTEXT,CONTROLLER:SASL_PLAINTEXT \

-e KAFKA_CFG_LISTENERS=PLAINTEXT://0.0.0.0:9092,CONTROLLER://0.0.0.0:9093 \

-e KAFKA_ENABLE_KRAFT=yes \

-e KAFKA_KRAFT_CLUSTER_ID="Aqvf7RVETX-DInZbNUXXXXXXX" \

-e KAFKA_CFG_CONTROLLER_QUORUM_VOTERS=1@192.168.11.100:9093,2@192.168.11.101:9093,3@192.168.11.102:9093 \

-e ALLOW_PLAINTEXT_LISTENER=yes \

-e KAFKA_TLS_CLIENT_AUTH=none \

-e KAFKA_CFG_SASL_ENABLED_MECHANISMS=PLAIN \

-e KAFKA_CLIENT_LISTENER_NAME=PLAINTEXT \

-e KAFKA_CLIENT_USERS=gohangout \

-e KAFKA_CLIENT_PASSWORDS=Gohangout#XXXX \

-e KAFKA_CFG_AUTO_CREATE_TOPICS_ENABLE=true \

-e KAFKA_CFG_OFFSETS_TOPIC_REPLICATION_FACTOR=3 \

-e KAFKA_CFG_TRANSACTION_STATE_LOG_REPLICATION_FACTOR=3 \

-e KAFKA_CFG_TRANSACTION_STATE_LOG_MIN_ISR=2 \

-v `pwd`/etc/sasl_config.properties:/opt/bitnami/kafka/config/sasl_config.properties \

-v `pwd`/data:/bitnami/kafka/ \

-v /etc/localtime:/etc/localtime \

bitnami/kafka:3.7.0

EOFbash ${path}/start.sh

docker exec -it kafka bash #创建topic

kafka-topics.sh --create --bootstrap-server 192.168.11.100:9092,192.168.11.101:9092,192.168.11.102:9092 --topic test --command-config /opt/bitnami/kafka/config/sasl_config.properties#生产

kafka-console-producer.sh --bootstrap-server 192.168.11.100:9092,192.168.11.101:9092,192.168.11.102:9092 --topic test --producer.config /opt/bitnami/kafka/config/sasl_config.properties

#消费

kafka-console-consumer.sh --bootstrap-server 192.168.11.100:9092,192.168.11.101:9092,192.168.11.102:9092 --topic test --consumer.config /opt/bitnami/kafka/config/sasl_config.properties#扩容分区

kafka-topics.sh --bootstrap-server 192.168.11.100:9092,192.168.11.101:9092,192.168.11.102:9092 --alter --topic log-smartgate --partitions 3 --replication-factor 1 --command-config /opt/bitnami/kafka/config/sasl_config.properties#查询分区

kafka-topics.sh --describe --bootstrap-server 192.168.11.100:9092,192.168.11.101:9092,192.168.11.102:9092 --topic test --command-config /opt/bitnami/kafka/config/sasl_config.properties

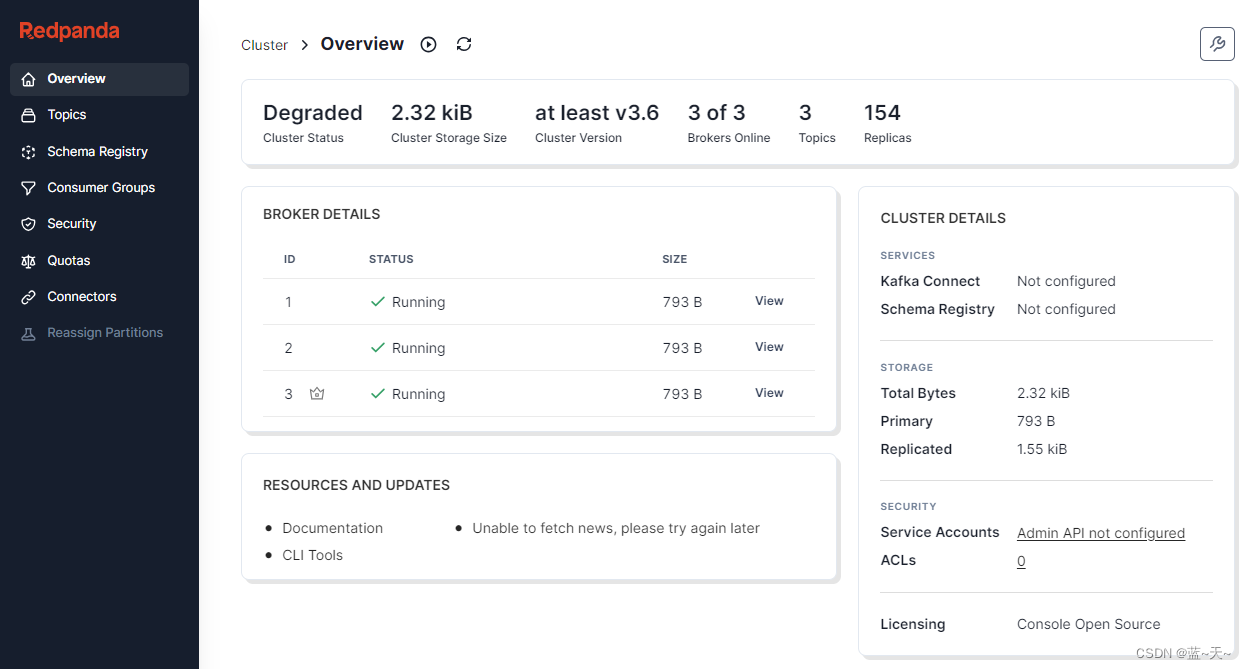

四、安装redpanda

path=/data/kowl

mkdir -p ${path}/etccat > ${path}/etc/console.yaml << 'EOF'

server:

# listenAddress:listenPort: 19002

logger:level: info

EOFcat > ${path}/start.sh << 'EOF'

docker rm -f kowlcd $(dirname $0)

docker run -itd \

--restart=always \

--network host \

--name kowl \

--user 5000 \

--add-host=logaudit_kafka_01:192.168.11.103 \

-v /etc/localtime:/etc/localtime \

-v `pwd`/etc/console.yaml:/app/console.yaml \

-e KAFKA_BROKERS="logaudit_kafka_01:9092" \

-e KAFKA_TLS_ENABLED=false \

-e KAFKA_SASL_ENABLED=true \

-e KAFKA_SASL_USERNAME=gohangout \

-e KAFKA_SASL_PASSWORD="Gohangout#XXXXX" \

redpandadata/console:v2.4.5 \

-config.filepath /app/console.yamlEOFbash ${path}/start.sh

这篇关于kafka_3.7.0+redpanda的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!