本文主要是介绍NVMe管理命令为何不用SGL?-1,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

上周末在公众号后台收到粉丝留言,主要是关于SGL的交流:“SGL为啥不能用于nvme admin cmd”?

回答这个问题前,首先,我们先回顾下NVME PRP和SGL的基本原理以及应用场景。

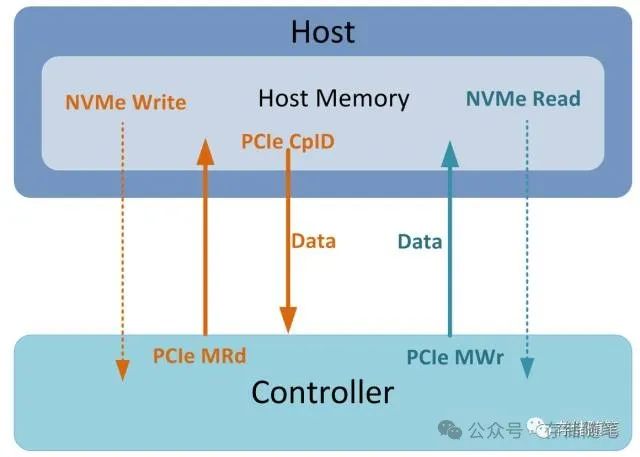

在Host与Controller之间有数据交互时,Controller会多次访问Host内存。比如执行NVMe Read/Write:

-

当Host下发NVMe Write命令时,Host会先放数据放在Host内存中,然后通知Controller过来取数据。Controller接到信息后,会通过PCIe Memory Read TLP读取相应的数据,接着Host返回的PCIe Completion报文中会携带数据给Controller,最后再写入NAND中。

-

当Host下发NVMe Read命令时,Controller先从NAND中读出相应数据,然后通过PCIe Memory Write TLP将数据写入Host内存中。

上述Read/Write均有访问Host内存进行数据交互,那么,问题来了:

-

NVMe Write时,Controller怎么知道数据在Host内存的具体位置?

-

NVMe Read时,Controller怎么知道要把数据写到Host内存中哪个位置?

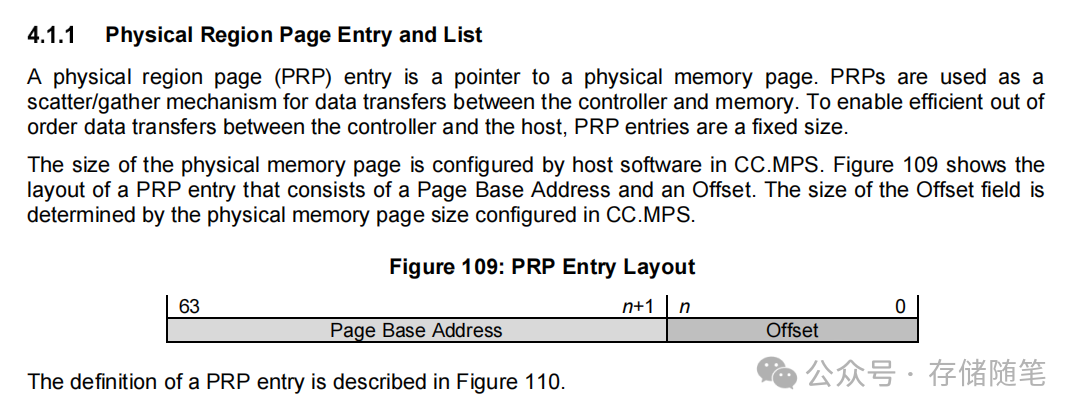

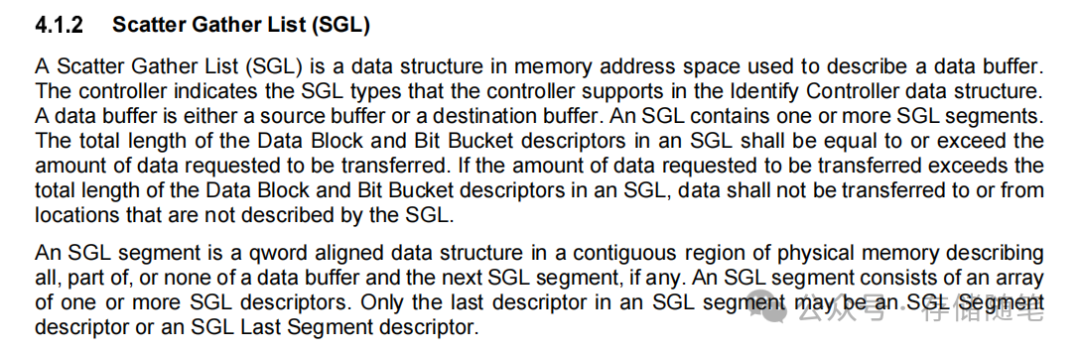

不怕,NVMe给Host配备了两大"法宝":PRP和SGL。这两个模型均可以帮助Host告知Controller数据在Host内存中的具体地址。

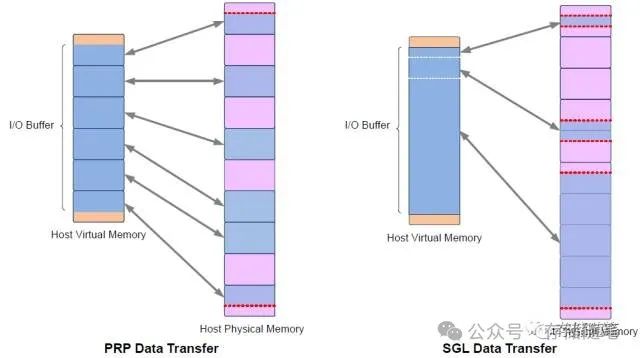

PRP和SGL是描述Host内存物理空间的两种方式,本质的不同是:PRP必须是物理页对齐的,而SGL则可以表述任意的物理空间。如下图。

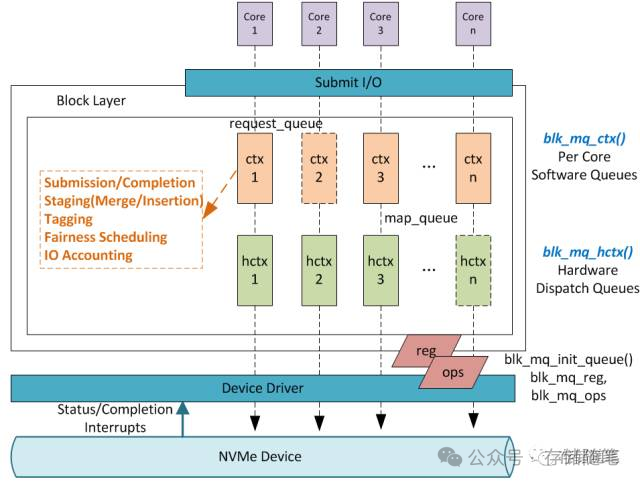

在Linux内核中,Block层下发的IO请求以BIO表示。我们需要通过DMA发送这些数据,Command使用dma_alloc_coherent分配DMA地址,但是BIO是存放在普通的内核线程空间的(线程的虚拟空间不能直接作为DMA地址)。

Linux函数nvme_map_data能够将虚拟空间地址(BIO数据存放地址)转换成DMA可用地址,并且多个IO请求的DMA地址可以通过scatterlist来表示。有了DMA地址就可以把BIO封装成NVMe Command发送出去。

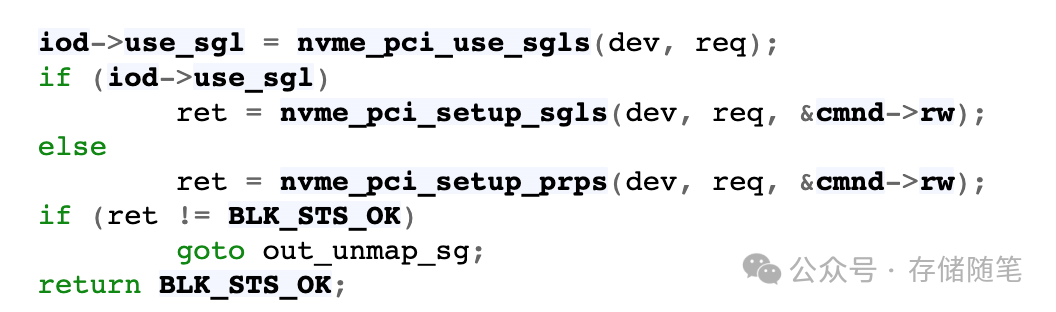

所以,linux驱动中nvme_map_data中针对NVME Command的IO传输格式就有了很重要的设定。比如,函数nvme_map_data中有iod->use_sgl的结果可以觉得IO传输过程中是使用SGL还是PRP。

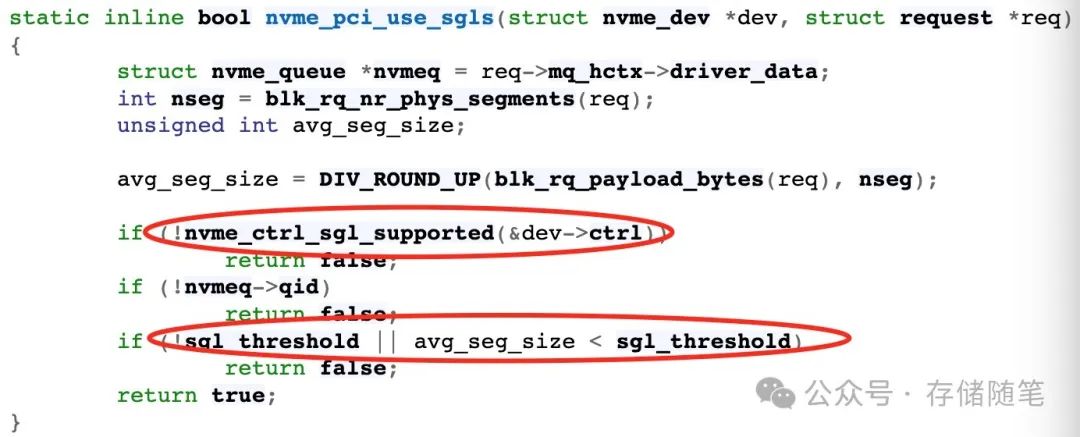

而iod->use_sgl的返回结果依赖函数nvme_pci_use_sgls的判断,主要有两种情况:

-

当SGL不支持的时,iod->use_sgl返回false,对应的IO数据传输就采用PRP了。

-

当平均请求大小avg_seg_size值小于SGL阈值sgl_threshold时,也返回false,需要采用PRP。也就是说,使用SGL情况,必须要要求avg_seg_size大于等于sgl_threshold。SGL比较适合大块数据的传输。

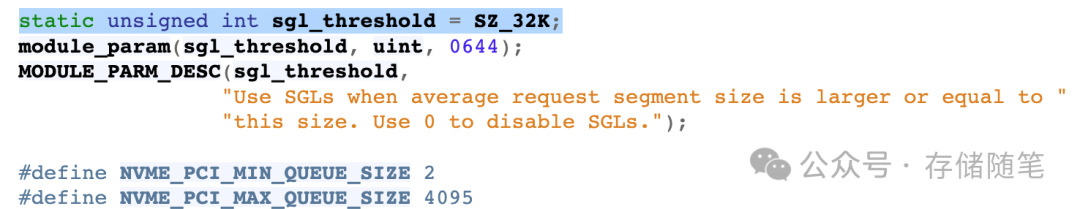

sgl_threshold的定义是32KB,avg_seg_size和sgl_threshold的计算对比关系如下示例:

-

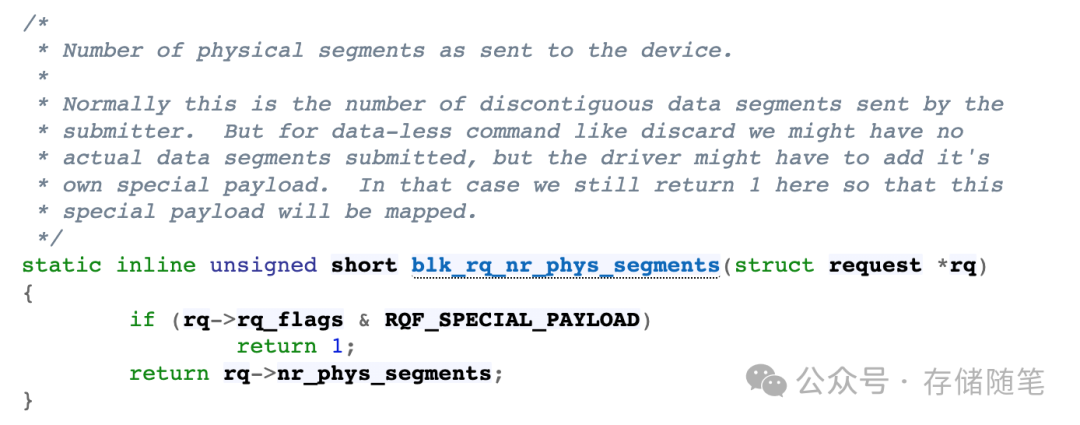

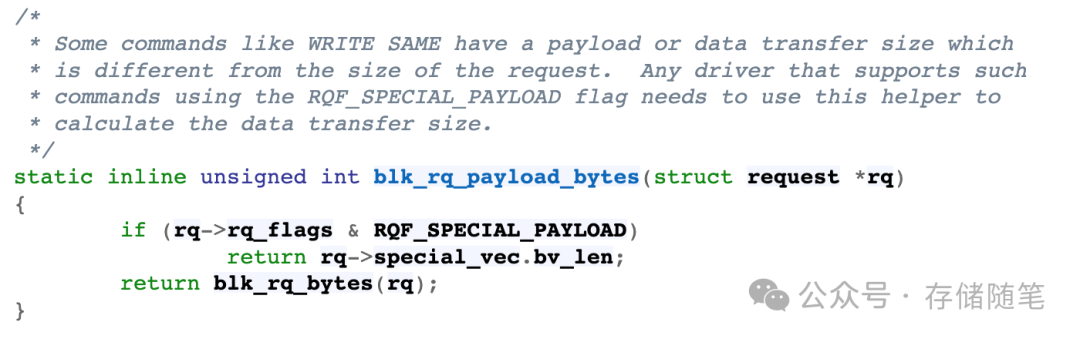

blk_rq_nr_phys_segments = 2,blk_rq_payload_bytes = 8k,那么,avg_seg_size = blk_rq_payload_bytes/blk_rq_nr_phys_segments=4K,这种情况avg_seg_size<sgl_threshold,那就需要采用PRP了。

-

blk_rq_nr_phys_segments = 2,blk_rq_payload_bytes = 64k,那么,avg_seg_size = blk_rq_payload_bytes/blk_rq_nr_phys_segments=32K,这种情况avg_seg_size=sgl_threshold,那就可以采用SGL了。

-

blk_rq_nr_phys_segments = 16,blk_rq_payload_bytes = 64k,那么,avg_seg_size = blk_rq_payload_bytes/blk_rq_nr_phys_segments=4K,这种情况avg_seg_size<sgl_threshold,那就需要采用PRP了。

sgl_threshold这个参数在linux内核中也可以通过修改/etc/default/grub文件,添加修改nvme.sgl_threshold参数即可

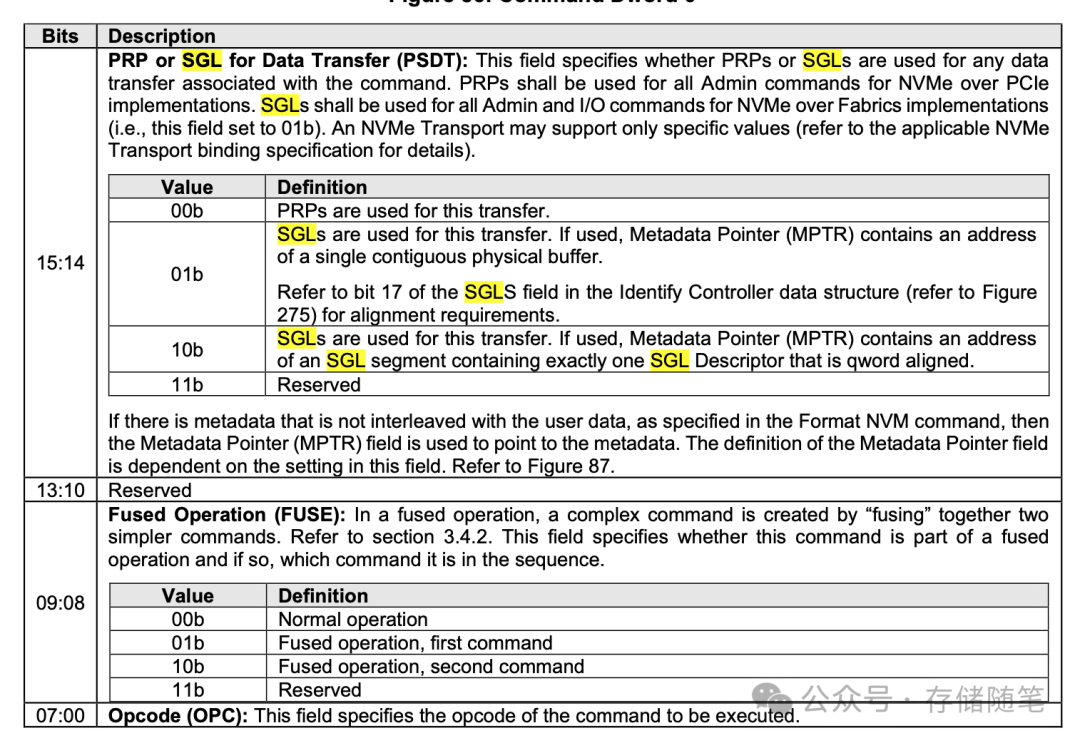

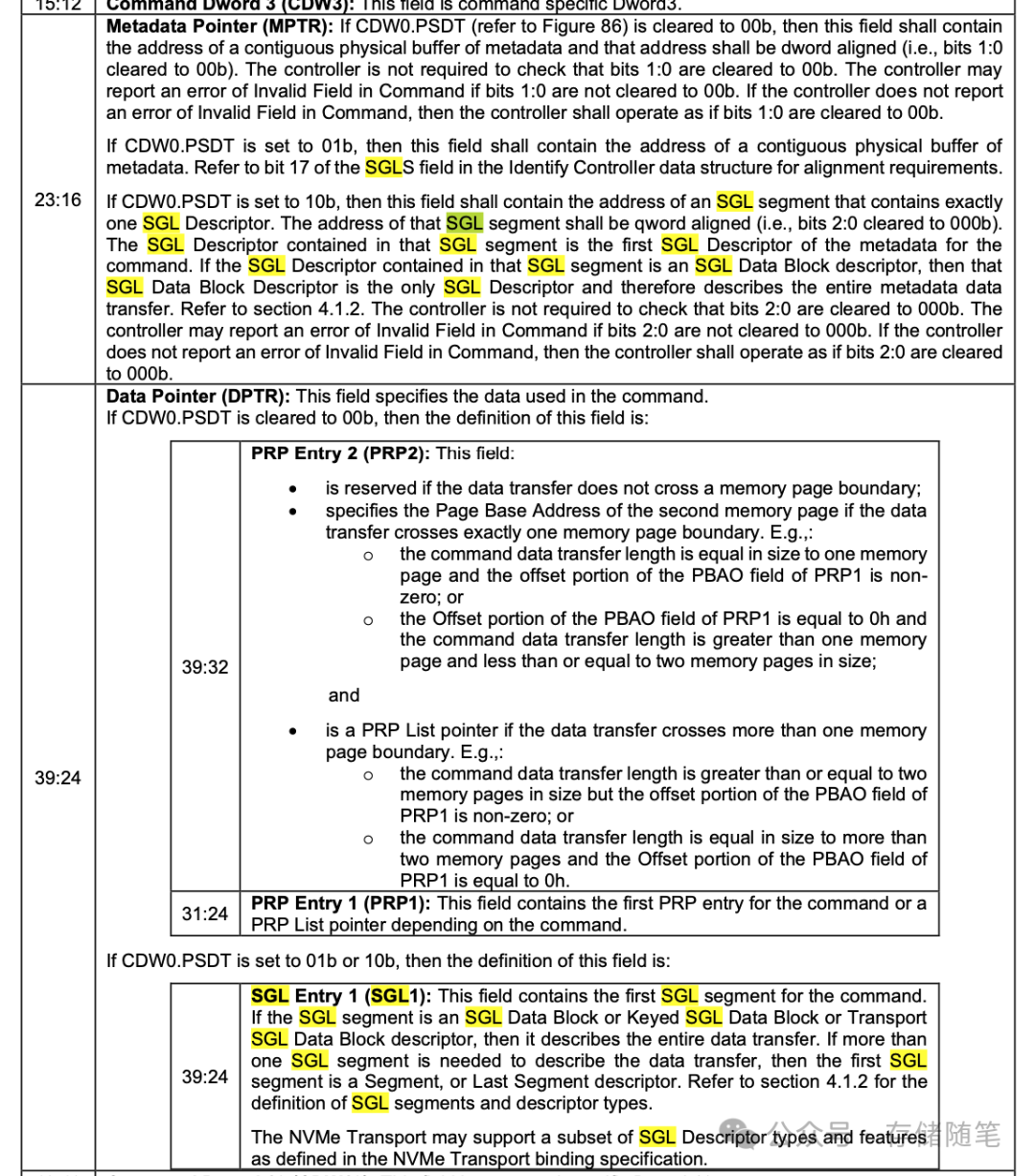

SQ队列中的PSDT参数中,可以定义每个IO数据传输采用PRP还是SGL。特别是NVME over Fabrics场景中,设定SGL时,需要关注metadata的MPTR设定,采用连续的物理空间,还是采用QWORD对齐的方式。

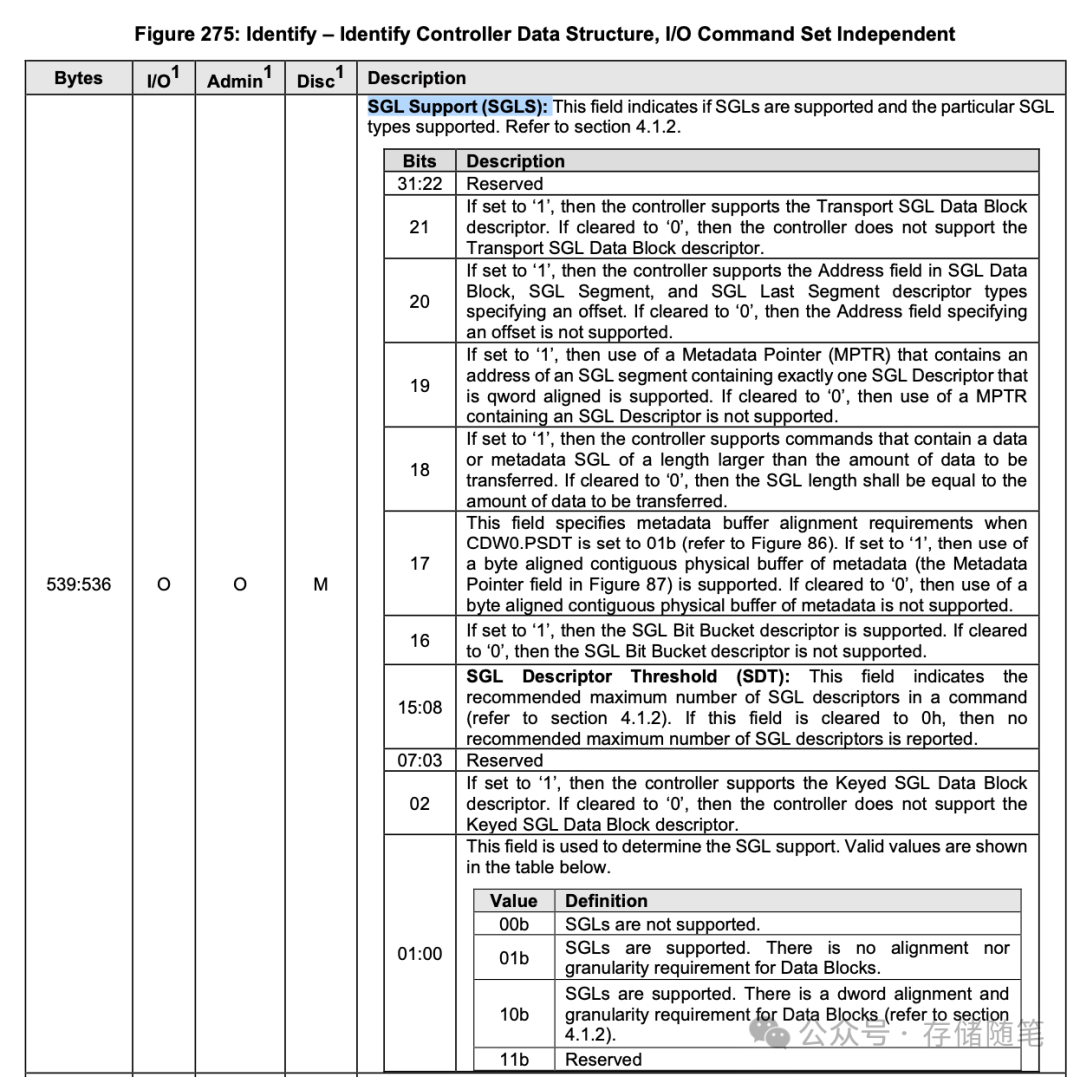

NVME Controller的Identify页面信息中,Byte536的前2个bit可以查询对SGL的支持情况。比如nvme-cli获取的2个nvme id-ctrl信息:

-

NVMe SSD A: sgls : 0,bit0=0,说明不支持SGL

-

NVMe SSD B: sgls : 0x70001,bit0=1,说明支持SGL,且对Data Block数据的对齐策略没有要求。

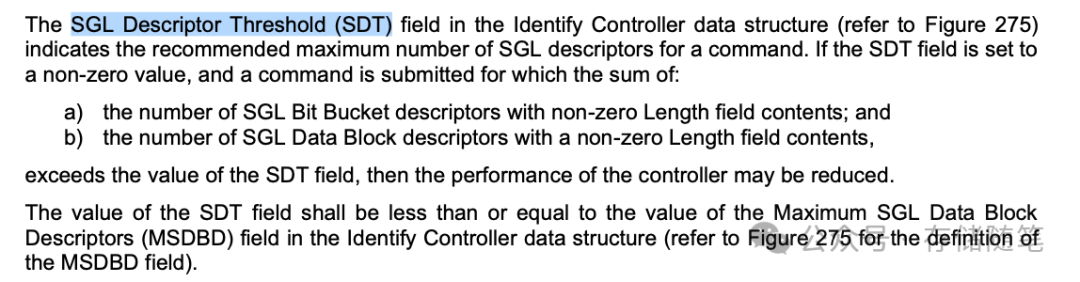

其中SGL Descriptor Threshold(SDT)代表SGL Descriptor最大的数量。如果SDT设置0,则代表没有设定最大建议值。

这篇关于NVMe管理命令为何不用SGL?-1的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!