本文主要是介绍(光速上手)Docker搭建kafka单机版,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

kafka运行依赖于zookeeper,所以要先搭建zookeeper!

1.启动zookeeper服务

docker run -d --name zookeeper -p 2181:2181 -t wurstmeister/zookeeper

2.启动kafka服务

记得修改命令中的zookeeper的ip地址和kafka所在的主机ip地址

docker run -d --name kafka --publish 9092:9092 --link zookeeper --env KAFKA_ZOOKEEPER_CONNECT=172.18.12.182:2181 --env KAFKA_ADVERTISED_HOST_NAME=172.18.12.182 --env KAFKA_ADVERTISED_PORT=9092 --volume /etc/localtime:/etc/localtime wurstmeister/kafka:latest

解释:

docker run -d --name kafka

--publish 9092:9092 // 端口绑定

--link zookeeper // 连接zookeeper

--env KAFKA_ZOOKEEPER_CONNECT=172.18.12.182:2181 // 配置zookeeper的地址+ip

--env KAFKA_ADVERTISED_HOST_NAME=172.18.12.182 // 主机地址

--env KAFKA_ADVERTISED_PORT=9092 // kafka的ip

--volume /etc/localtime:/etc/localtime // 本地磁盘挂载

wurstmeister/kafka:latest // 镜像名字

3.测试

进入容器并且启动发送方和消费者

1.进入kafka容器

docker exec -it kafka /bin/bash

2.创建名为test的主题(topic)

bin/kafka-topics.sh --create --zookeeper 172.18.12.182:2181 --replication-factor 1 --partitions 1 --topic test

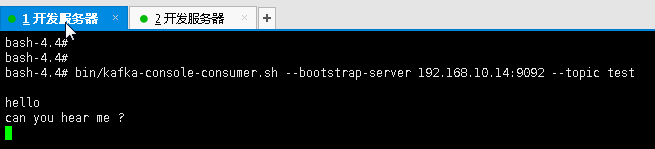

3.打开消费者—开始监听消费消息

bin/kafka-console-consumer.sh --bootstrap-server 172.18.12.182:9092 --topic test --from-beginning

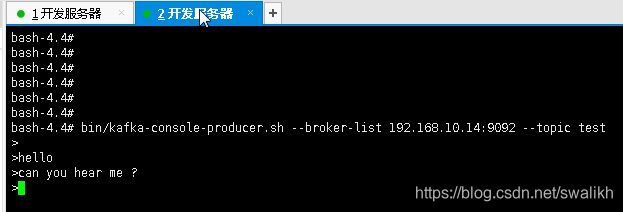

4.新打开一个ssh窗口,进入容器,打开消息发送者,发送消息

kafka-console-producer.sh --broker-list 172.18.12.182:9092 --topic test

此时消费方已经能接受到发送方发的消息了,搭建成功!!!

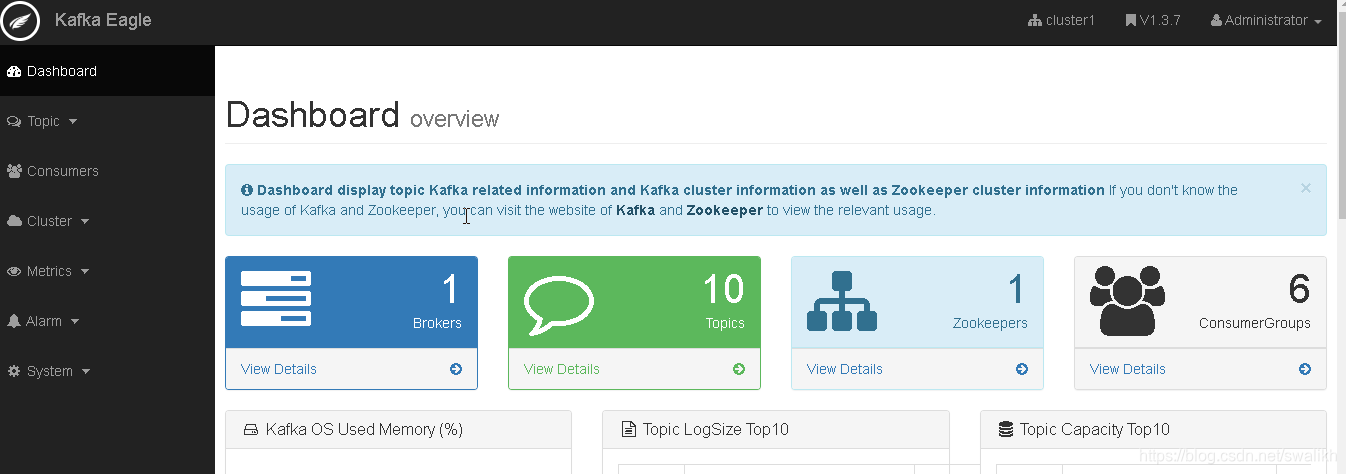

附:搭建UI监控—kafka-eagle,颜值还可以哦~

1.下载安装包

wget https://github.com/smartloli/kafka-eagle-bin/archive/v1.3.7.tar.gz

2.解压并且修改配置文件conf/system-config.properties

配置zookeeper

kafka.eagle.zk.cluster.alias=cluster1

cluster1.zk.list=192.168.10.14:2181

配置端口

kafka.eagle.webui.port=10092

配置数据库

kafka.eagle.driver=com.mysql.jdbc.Driver

kafka.eagle.url=jdbc:mysql://rm-wz9p90b2992j8b4e2xo.mysql.rds.aliyuncs.com:3306/ke?useUnicode=true&characterEncoding=UTF-8&zeroDateTimeBehavior=convertToNull

kafka.eagle.username=k8sadmin

kafka.eagle.password=xxxxxxx

3.配置linux环境变量PATH

vi /etc/profile

#java home

export PATH USER LOGNAME MAIL HOSTNAME HISTSIZE HISTCONTROL

export JAVA_HOME=/usr/java-jdk-home/jdk1.8.0_211

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar#kafka home

export KE_HOME=/huanglei/sofrware/kafka-eagle

export PATH=$PATH:$KE_HOME/bin:$JAVA_HOME/bin

4.授权并且启动,成功后会打印出用户名密码 url等

chmod 777 *

bin/ke.sh start stop

5.登录(默认)

*用户名:admin

*密 码:123456

这篇关于(光速上手)Docker搭建kafka单机版的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!