本文主要是介绍Tensorflow 回调(callbacks)函数的使用方法,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在我们训练神经网络时,对于训练数据的迭代次数(epochs)的设置,是一个值得思考的问题。

通常,epochs 越大,最后训练的损失值会越小,但是迭代次数过大,会导致过拟合的现象。

我们往往希望当loss值,或准确率达到一定值后,就停止训练。但是我们不可能去人为的等待或者控制。

tensorfow 中的回调机制,就为我们很好的处理了这个问题。

tensorfow 中的回调机制,可以实现在每次迭代一轮后,自动调用制指定的函数(例如:on_epoch_end() 顾名思义),可以方便我们来控制训练终止的时机。

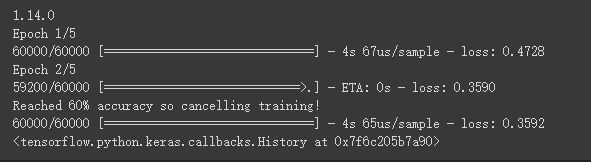

例如,我们希望当损失值loss < 0.4时,停止训练。实现步骤如下:

(1)

首先,我们定义一个myCallback类,它继承了tensorflow中自带的一个Callback类

然后,我们重写该类的 on_epoch_end() 方法。

根据我们自己的需求实现,logs中有大量的训练信息,我们可以获得当前的损失值,准确率等信息。。。

这里,我们实现,当loss < 0.4时,停止训练

class myCallback(tf.keras.callbacks.Callback):def on_epoch_end(self, epoch, logs={}):if(logs.get('loss')<0.4):print("\nReached 60% accuracy so cancelling training!")self.model.stop_training = True

(2)

实例化一个 myCallback 对象 callbacks

在model.fit()函数中添加 callbacks 参数

...

callbacks = myCallback()

...

model.fit(training_images, training_labels, epochs=5, callbacks=[callbacks])

模型会在每次迭代完一轮后,调用相应的函数。

完整代码:

import tensorflow as tf

print(tf.__version__)class myCallback(tf.keras.callbacks.Callback):def on_epoch_end(self, epoch, logs={}):if(logs.get('loss')<0.4):print("\nReached 60% accuracy so cancelling training!")self.model.stop_training = Truecallbacks = myCallback()

mnist = tf.keras.datasets.fashion_mnist

(training_images, training_labels), (test_images, test_labels) = mnist.load_data()

training_images=training_images/255.0

test_images=test_images/255.0

model = tf.keras.models.Sequential([tf.keras.layers.Flatten(),tf.keras.layers.Dense(512, activation=tf.nn.relu),tf.keras.layers.Dense(10, activation=tf.nn.softmax)

])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

model.fit(training_images, training_labels, epochs=5, callbacks=[callbacks])

这篇关于Tensorflow 回调(callbacks)函数的使用方法的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!