本文主要是介绍FacePose — pytorch 代码运行测试,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 前言

- 一、环境配置

- (一)框架:

- 二、运行详细步骤

- 1.资源配置

- 2.参数配置

- 总结

前言

上次虽然成功跑出了FSA-Net的代码,但是数据可视化的部分并没有复现,本着上GitHub上寻找一下作者的可视化线索,结果在评论里发现了另一位名为 WIKI 分享的头部姿态检测的模型,试着下载下来跑了一下,发现效果还是比较理想的;按照作者的说法,算法已经应用于以下两个方面:- 儿童在线教育,用于识别儿童是否认真听讲;

- 现场会议或学校课堂,以判断演讲质量。

不过你把这活都干了,我不就失业了吗???真好

一、环境配置

(一)框架:

资源地址

配置:Win 10 + Pycharm + Anconada

这个配置好后,基本就完成了一半工作;

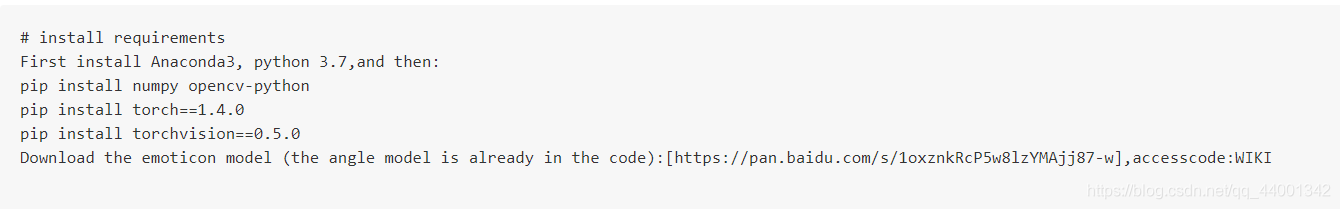

查看提示,可需要下载Anconda3 + python3.7 版本以上,由于之前已经配置过相关环境,这里不多赘述。

然后需要下载 numpy,opencv-python两个包,直接在pycharm终端里下载:

pip install numpy

pip install opencv-python

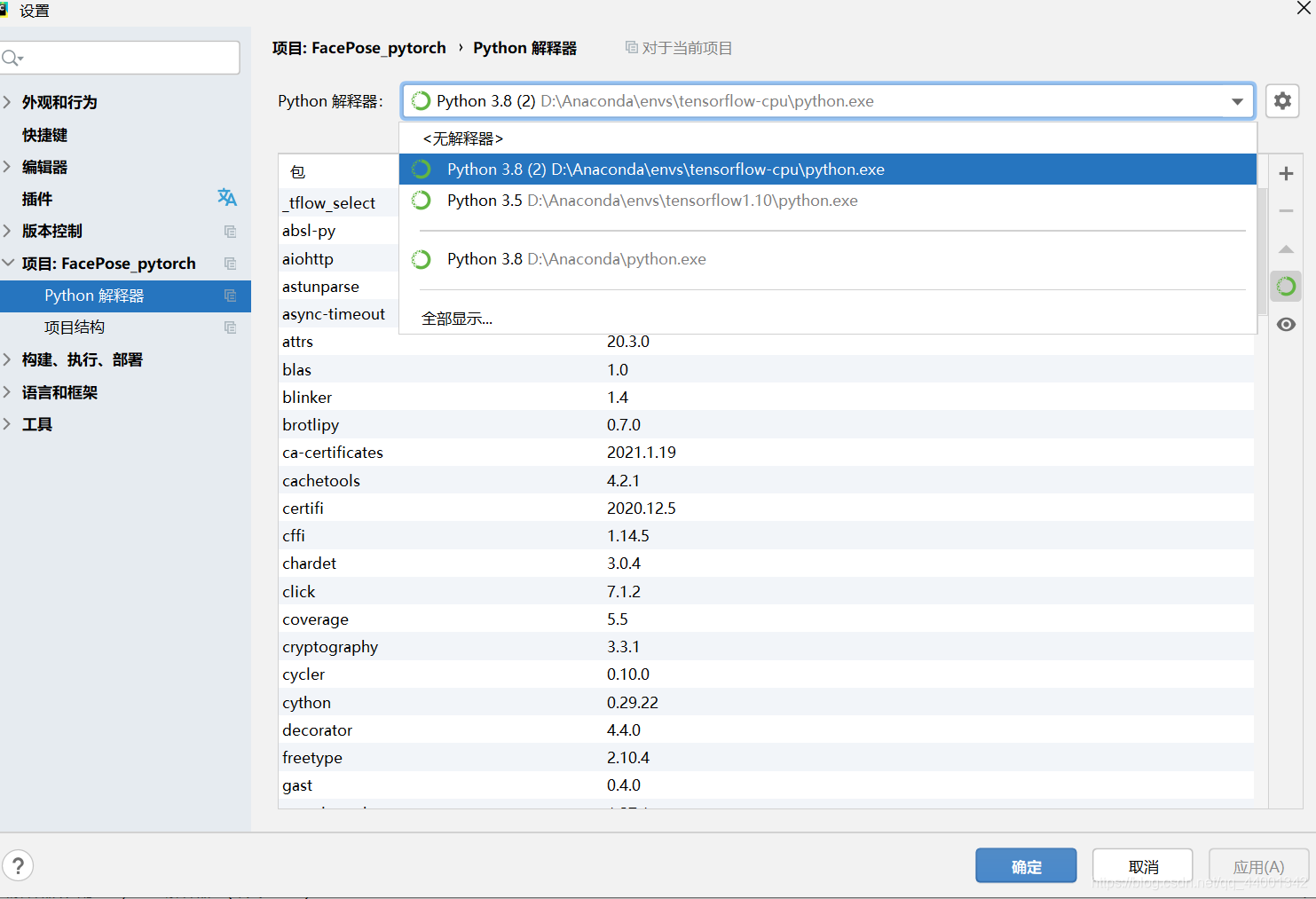

需要注意的是,在这之前要把python解释器更换为Anconda环境,在此基础上下载才会更新环境配置,这边 opencv-python 包在 + 中是搜索不到的,只能 pip 下载:

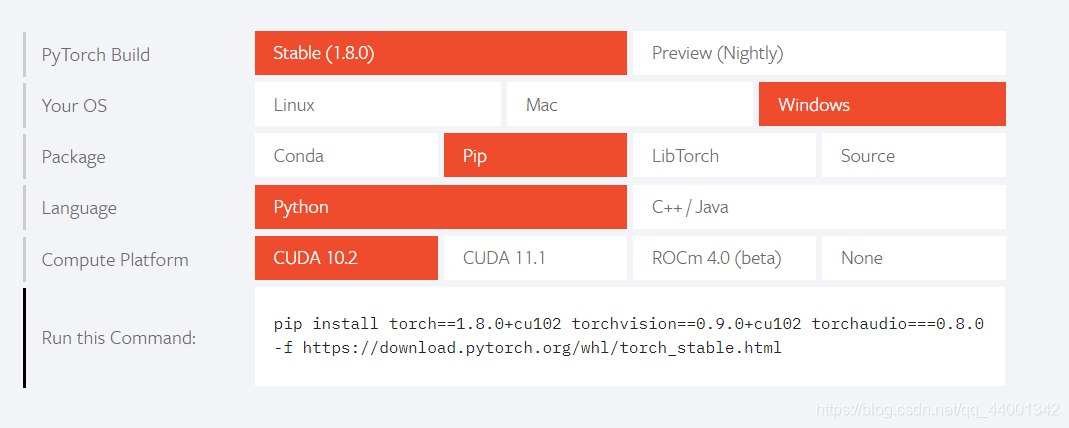

接着,还需要下载torch库,这里我们直接下载最新版本的 torch 库即可,下载的同时会自动将 torchvison 也下载下来,这里向下兼容,跑代码不会出现问题,相反,如果下载1.4.0版本,可能会报错:

“ could not find a version that satisfies the requirement torch…”

可按照以下步骤执行:

- 打开Pytorch官网,下拉到图示部位,选择相关配置,根据自己电脑的CUDA版本号选择最后一行的配置,复制图中的 pip 语句,在pycharm 终端里直接执行:

大概需要下载 3 G左右的资源,下载完成后,在python解释器里会更新环境,这时就配置好了所有需要的环境:

二、运行详细步骤

1.资源配置

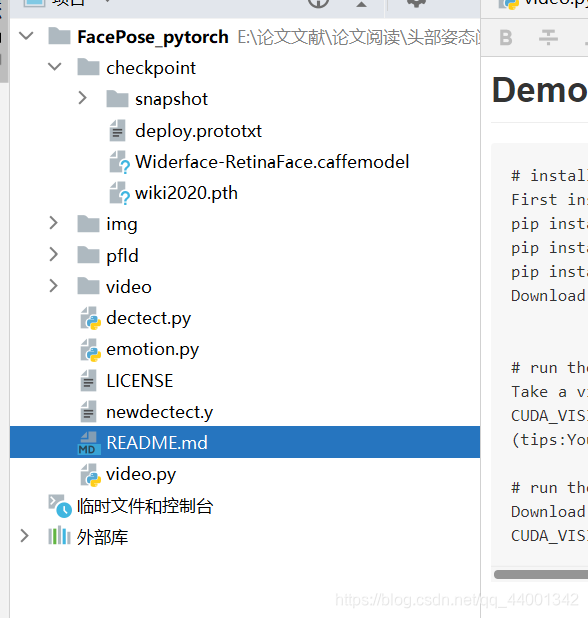

此时打开项目,应该出现如图所示的文件,作者的提示中说道,还需要下载一个emoil模型,作者放出的网盘地址可能已经失效了,这里放一个备份版:

百度网盘连接

提取码:gudj

下载下来后放在 checkpiont 文件目录下即可。

2.参数配置

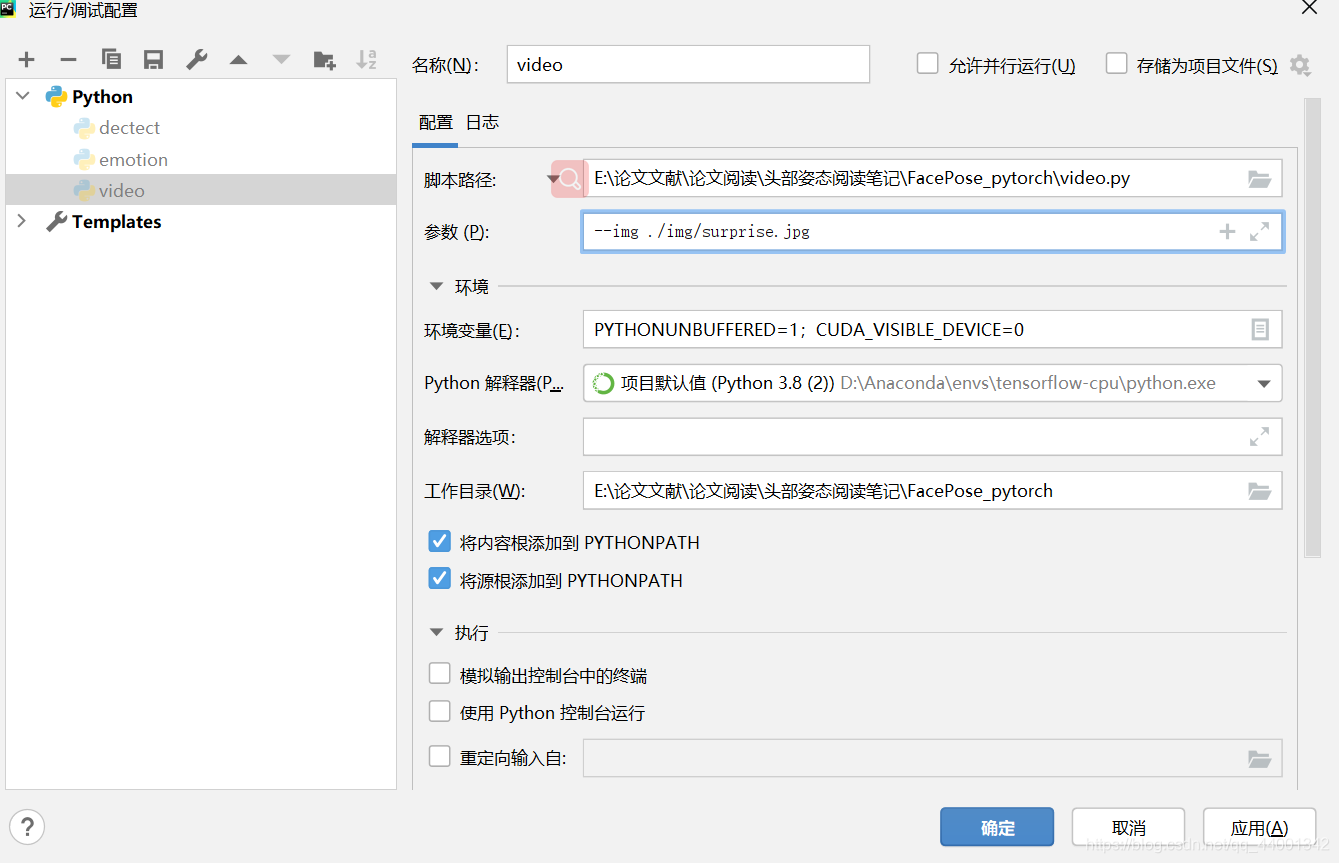

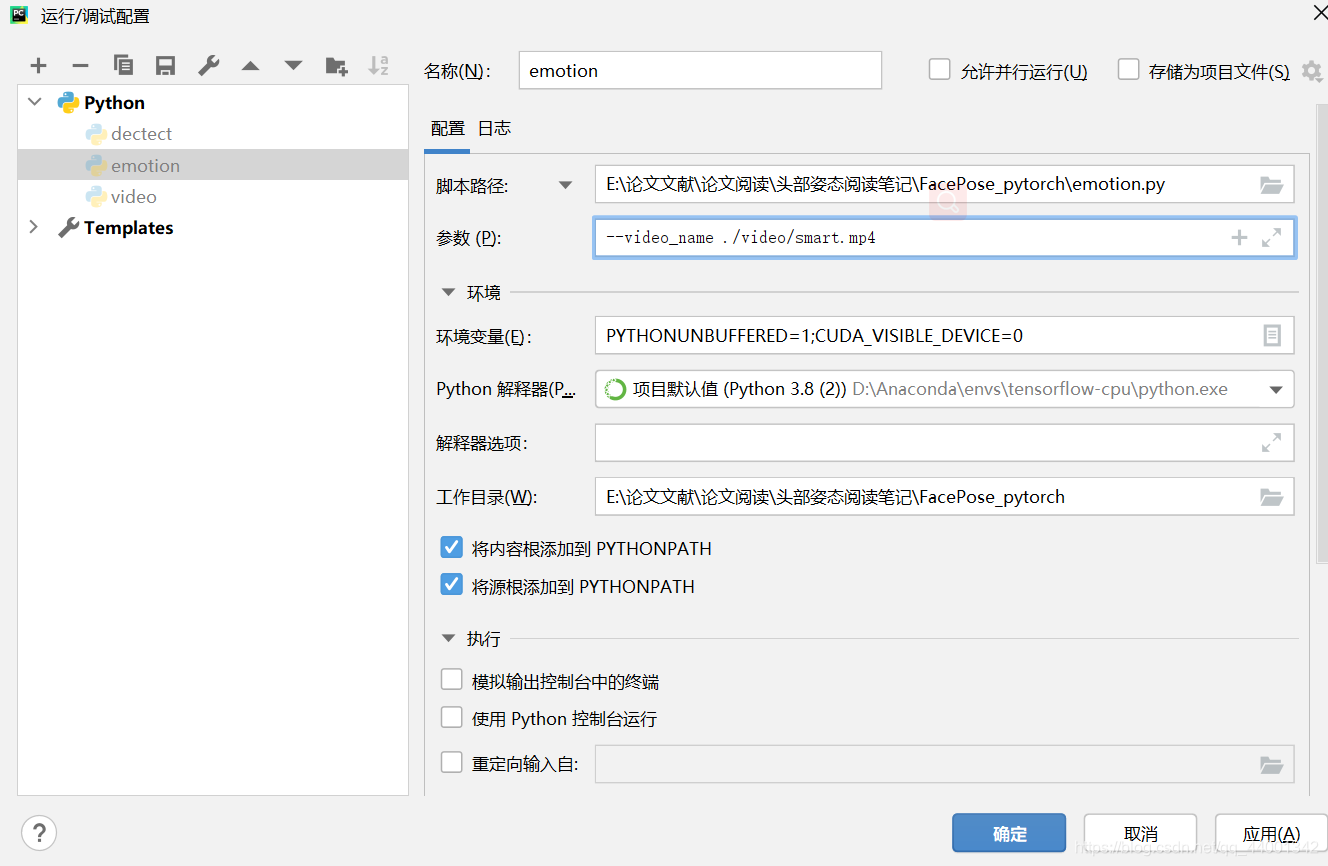

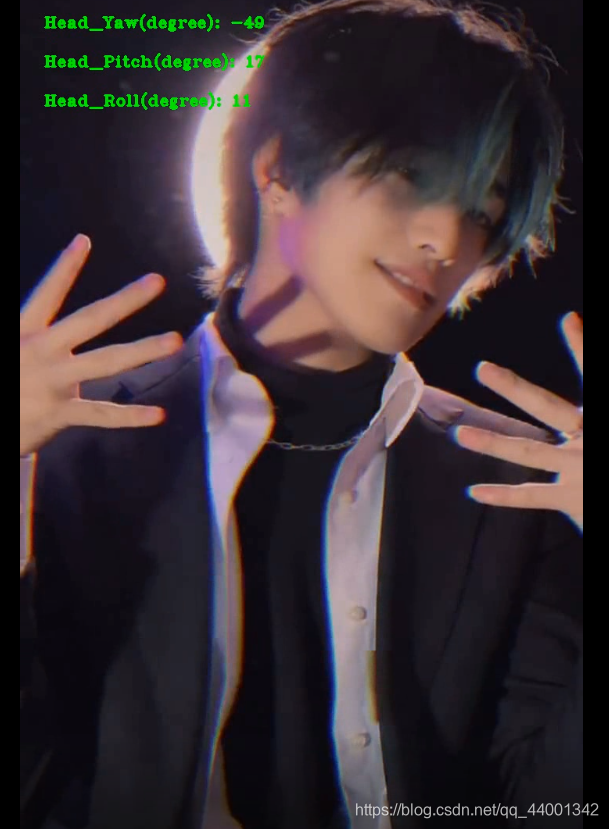

目前的代码可执行的程序有两个,一个emontion.py, 用来预测图片中的人物情绪信息,另一个是vedio.py, 用来动态显示视频中人物的三个角度(yaw,pitch, roll)的信息;

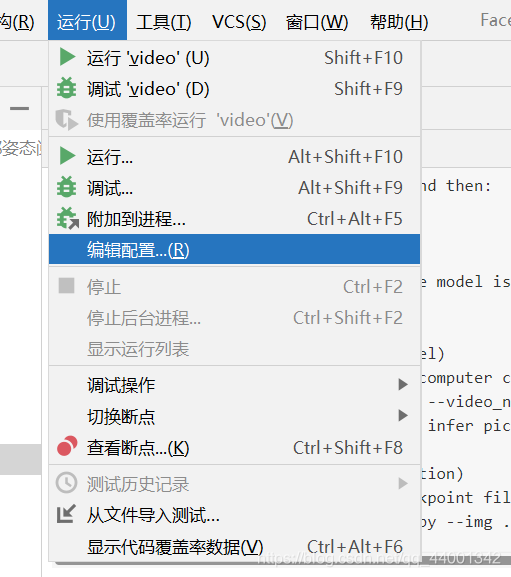

先从emotion说起,打开运行,编辑配置,

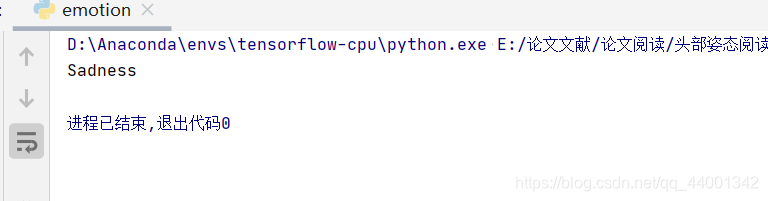

作如上修改,其中 ./img/suprised.jpg 是图片存放的相对路径,我们可以自己将图片存放到 img 文件下来进行尝试。运行后程序输出对图片中表情的预判:

图片:

输出结果:

据作者自己介绍,头部偏转的准确率的误差在三度以内:

video运行:

同上,编辑配置,将参数改为自己的视频路径。最好放在video文件夹里,这样相对路径可以识别,否则需要自己改绝对路径。

作者的方法同样是单人头部偏转检测,本来我还很纠结去哪找单人视频,还要面部clear的,后来我灵光炸蹦,单人,视频,这不是抖音吗?

运行结果如下:

帅气 !!!!!

总结

有待改进的空间是对数据进行预处理,以及如何从多人场景中分离出单人,或者直接应用到多人检测上…

这篇关于FacePose — pytorch 代码运行测试的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!