本文主要是介绍多篇论文介绍-DSConv-原文,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文地址 https://arxiv.org/pdf/1901.01928v1.pdf

目录

01 改进 YOLOv5的交通灯实时检测鲁棒算法

01 作用

02 模型介绍

02 基于改进YOLOv7一tiny 算法的输电线路螺栓缺销检测

01 作用

02 模型介绍

03 结合注意力机制的 YOLOv5红绿灯检测算法

01 作用

02 模型介绍

04 基于改进YOLOv7的SAR图像舰船目标检测算法

01 作用

02 模型介绍

01 改进 YOLOv5的交通灯实时检测鲁棒算法

01 作用

使用 DSConv卷积核减少模型参数;

02 模型介绍

02 基于改进YOLOv7一tiny 算法的输电线路螺栓缺销检测

01 作用

该算法采用高效的分布移位卷积(distibution shiting convolution,DSConv)来替换YOLOv7-tiny网络中的3x3卷积,以提高模型的计算速度并降低计算复杂度;

02 模型介绍

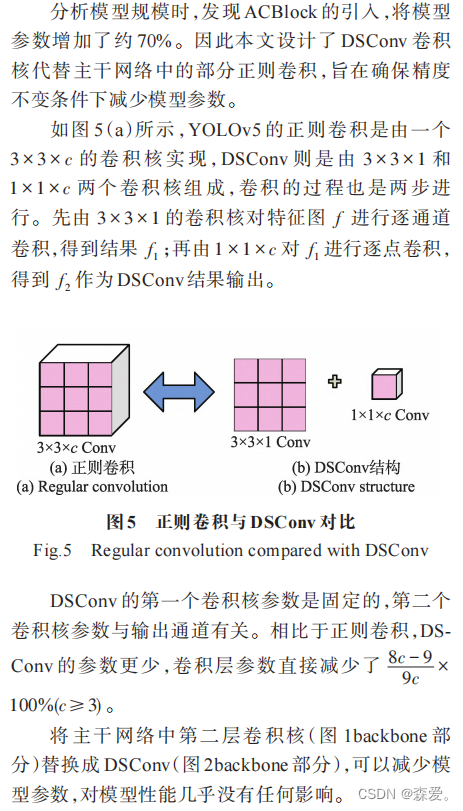

在网络设计中,DSConv是可用于各种卷积神经网络推理和训练的即插即用替代品,具有2个主要优点:首先,DSConv可以提高标准卷积的存储效率和速度;其次,通过将网络中的3x3卷积替换为DSConv,可以在略微降低模型精度的情况下提高检测速度,并降低模型的运算量。以往的实验结果表明,将DSConv应用于神经网络中,可以有效降低计算复杂度,每秒10亿次的浮点运算数(giga floating-point operations per second,GFLOPs)可从13.2降低至5.6。因此,DSConv是有效的优化选择,其基本结构如图2所示。

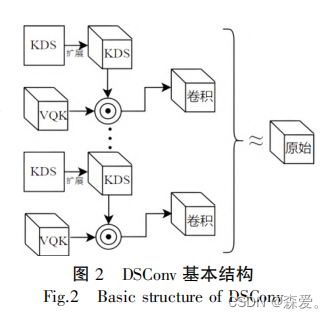

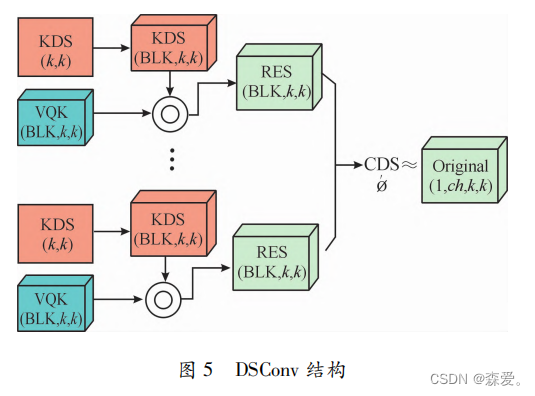

由图2可知,DSConv是使用量化和分布位移来模拟卷积行为的方法;其中,☉表示哈达玛算子(Hadamard operator)。该方法由2个部分组成:可变量化内核( variable quantizedkernel, VQK)和分布位移。VQK仅保存位长可变的整数值,这是DSConv量化分量的一部分,可以使乘法速度更快,存储效率更高;分布位移目的是移动VQK的分布,以模拟原始卷积核的分布,“位移”是指缩放和偏置操作,用2个张量来实现:内核分布移位器(kernel distribution shifter ,KDS)和通道分布移位器(channeldistribution shifier ,CDS),前者移动VQK每个块中的分布,后者移动每个通道中的分布。通过DSConv,卷积核可以减少到原始大小的一部分,从而实现更快、更节省内存的计算。

03 结合注意力机制的YOLOv5红绿灯检测算法

01 作用

02 模型介绍

DSConv是标准卷积的即插即用替代品,可直接用于任何卷积神经网络,如图5所示,DSconv卷积层将传统的卷积内核分解为2个组件:可变量化内核(VQK)和分布式移位。DSConv利用量化和分布移位来模拟卷积层的行为,首先通过在VQK中存储整数值来实现较低的存储器使用和较高的速度,然后通过应用基于内核和基于通道的分布偏移来保持与原始卷积相同的输出,达到提高模型速度和减少参数量的目的。

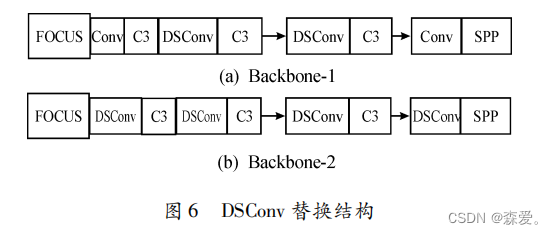

通过对标准卷积的分析,设计了2种新的主干网络卷积结构,如图6所示。Backbone-1 结构将第三层和第五层的卷积核替换成DSConv ,参数量减少约5% ,如图6( a)所示;在 Backbone-1 结构的基础上,将第一层和第七层卷积核替换成DSConv ,进一步降低了15%的参数量,提升了运行速度,如图6(b)所示。

04 基于改进YOLOv7的SAR图像舰船目标检测算法

01 作用

02 模型介绍

量化是一种提高卷积神经网络运行速度和缩减内存的流行方法,本文引用一种分布偏移卷积(DSConv)。DSConv是一种灵敏的量化卷积算子,用成本低的多的整数运算代替单精度运算,同时保证卷积内核权重及输出的概率分布。DSConv将原始卷积核拆为两个部分:其中一部分仅有整数值张量,不能训练,并依据预训练网络中浮点的权重分布计算。另一个部分由分布偏移器张量组成:一个分布偏移分布偏移器移动所有内核的分布,另一个移动所有通道。分布偏移部分的权重可以被训练,使网络适应新的任务。

在可变量化核中仅存放整数值,与原始张量大小一样,参数值一旦设置不能更改,同时通过分布偏移以保存与原始卷积内核相同的输出。在预训练网络时,将权重张量滤波器按深度划分为长度为 B 的块,所有的块共享一个浮点值,然后对所有块量化处理,每个张量节约的内存为公式

这篇关于多篇论文介绍-DSConv-原文的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!