本文主要是介绍Offernation:可以通过国外调查日入10美金的任务站,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

如果你想要了解更多关于国外调查的资料,可以搜公众号:水煮柚子

也可以访问我的个人博客:https://www.ckyouzi.com

Offernation是一家很值得推荐的国外在线调查网站,调查路由和任务非常多,最低1美元起付,24小时之内到账,柚子已经累计收到超过100美元的支付,十分稳定。

一、注册

打开Offernation网站,点击右上角的“Join Free”按钮,点击进入注册界面

进入页面后按实际情况填写个人资料

注意:全部用拼音或英文,地址简单填写即可,不用特别详细。全部填写完成后点击:“Create Account”完成注册。

二、开始赚钱

点击上方导航栏中的“Make Money”或者“Offerwalls”,下拉菜单中会出现调查路由,每个路由中都会有对应的调查可做。比如:

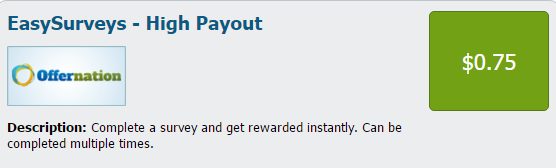

蓝色字体文字为路由名称,右边为调查单价。下面的“description”为该调查路由的简介,内容中有“multiple time”字样的路由每天可做无限次,直到没有调查可做为止。

注:个别调查路由需要你在做调查之前填写调查资料,相信做过调查的朋友对此都已经轻车熟路,柚子在这里就不多赘言了。还有就是,并不是所有调查都可以完成,因为有很多是针对欧美国家会员的路由,身为国人的我们就只能是望查兴叹了。

不过大家也别灰心,这里还是有很多调查可以做的,正常情况下每天做个1-3美元不是很难。

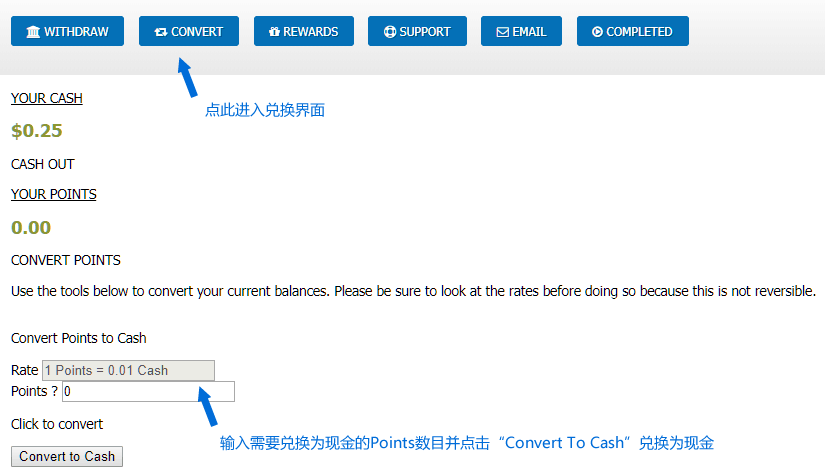

另:“Make Money”中的调查为现金奖励,而“Offerwalls”中的调查奖励为“Point”,需要手动将“Points”兑换为现金。下面柚子就讲一下如何兑换和请款。

三、兑换及请款

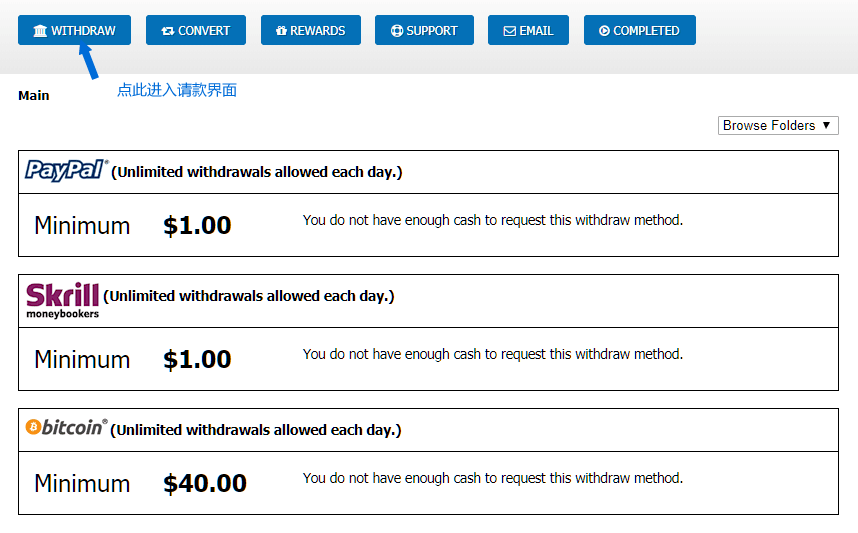

当你的账户中有1美元或者“Points”有100之后,就可以去申请支付了,具体步骤如下:

先点击“Convert”将账户中的“Points”兑换为现金,兑换之后点击旁边的“Withdraw”进入请款界面

进入请款界面后选择自己适用的支付方式,填写收款账号之后请款,大功告成!

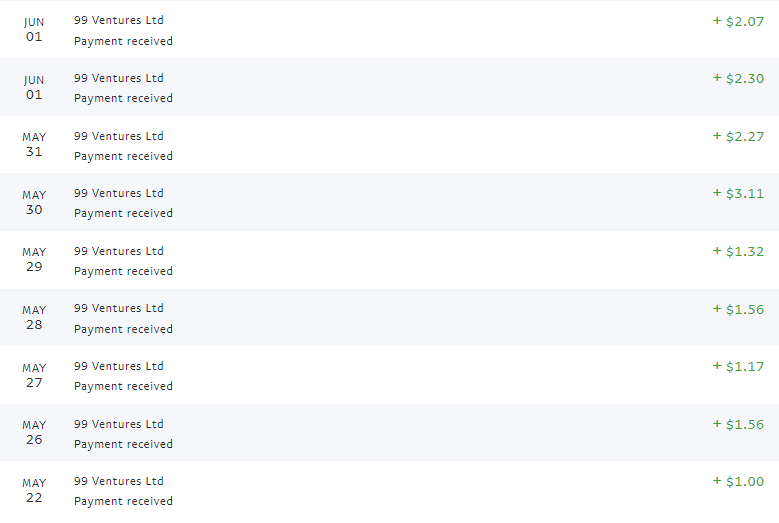

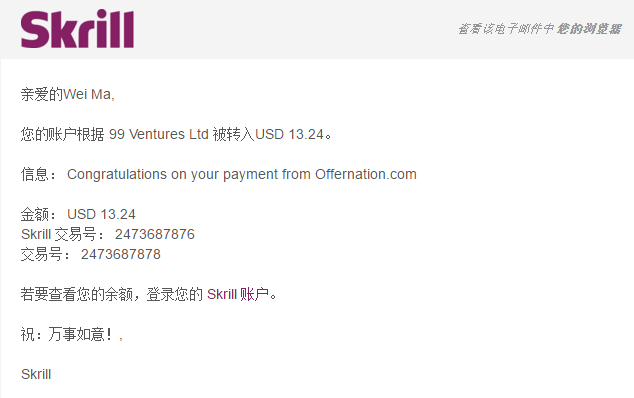

四、部分收款图

六、友情提示

需要大家注意的是:“Offernation”、“Superpay”、“Rewardingways”三家国外调查赚钱站点实为同一系统,所以大家如果注册了三家中的任意一家之后,就千万不要再注册另外两家了。

这是血的教训,柚子就是因为觉得这个站很好赚,所以注册了这个系统中的全部三个网站,结果惨遭封号。在苦苦等待了两个月,又经过几番交涉 之后 才最终将“Offernation”解封,另外两个站则永久封停了,所以大家一定要注意。

另外,申请支付的时候最好使用Paypal,柚子使用Skrill请款的时候,三次请款遇到两次支付不到账的情况,每次都要写信和站长交流,很是头疼

这篇关于Offernation:可以通过国外调查日入10美金的任务站的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!