本文主要是介绍如何打通HDFS任督二脉,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

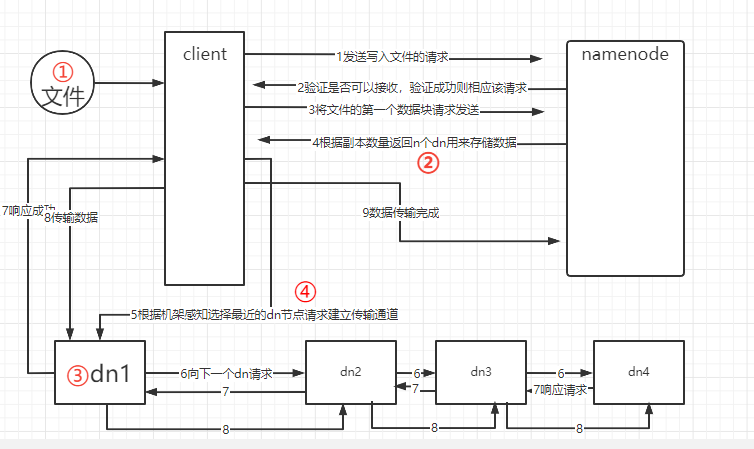

用HDFS写数据流程图打通HDFS任督二脉

文字详解

(1)客户端通过Distributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否已存在,父目录是否存在。

(2)NameNode返回是否可以上传。

(3)客户端请求第一个 Block上传到哪几个DataNode服务器上。

(4)NameNode返回3个DataNode节点,分别为dn1、dn2、dn3。

(5)客户端通过FSDataOutputStream模块请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成。

(6)dn1向下一个dn请求,逐级进行。

(7)dn1、dn2、dn3逐级应答客户端。

(8)客户端开始往dn1上传第一个Block(先从磁盘读取数据放到一个本地内存缓存),以Packet为单位,dn1收到一个Packet就会传给dn2,dn2传给dn3;dn1每传一个packet会放入一个应答队列等待应答。

(9)当一个Block传输完成之后,客户端再次请求NameNode上传第二个Block的服务器。(重复执行3-8步)。

角色

- NameNode(nn):就是master,它是一个管理者。有以下职能:

- 管理HDFS的名称空间;

- 配置副本策略;

- 管理数据块映射信息;

- 处理客户端读写请求;

- DataNode(dn):就是slave。nn下达命令,dn执行实际的操作。职能如下:

- 存储数据块

- 执行数据块的读/写操作。

- Client:客户端:

- 文件切分。文件上传HDFS的时候,Client将文件切分成一个一个的Block,然后进行上传;

- 与nn交互,获取文件的位置信息;

- 与dn交互,读取或写入数据;

- 提供一些命令来管理HDFS,比如nn格式化

- 可以通过一些命令来访问HDFS,比如对HDFS增删改查操作

- Secondary Namenode(2nn):

- 辅助nn,分担其工作量,比如定期合并Fsimage和Edits,并推送给nn;

- 在紧急情况下,可辅助恢复nn。

开始打通……

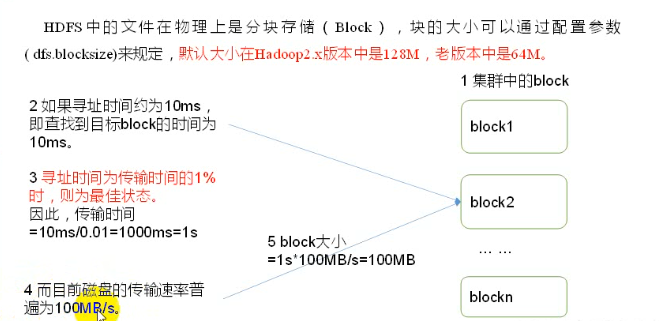

①HDFS文件块大小

块不宜过大也不宜过小,如果过大会导致加载时间变长, 磁盘传输数据的时间明显大于寻址时间,导致程序处理这块数据时非常慢。

过小导致nn存储元数据信息过多,增加寻址时间。

当寻址时间确定后,它的最佳传输时间也被确定,这时候就可以根据磁盘数据传输速率确定数据块大小了!

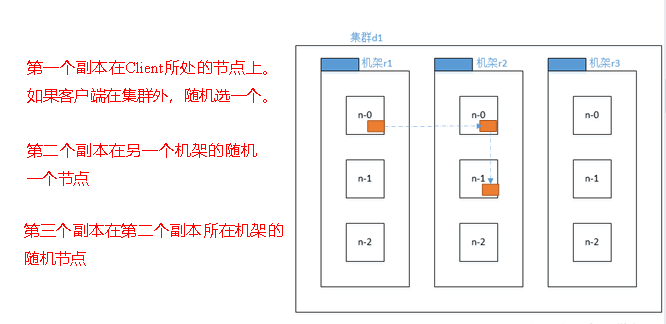

②机架感知(副本存储节点选择)

③DATANODE

一个datanode包含一或多个数据块(block), 每个block包含两个文件——数据本身、元数据(数据长度、校验和、时间戳)。

工作机制

datanode启动后向namenode注册。

namenode返回注册成功。

DN定期(默认1h)向NN发送所有块信息。

DN每三秒待会从NN下达给自己的指令。

若NN10min30s未接收到DN的心跳,则认为该节点不可用。

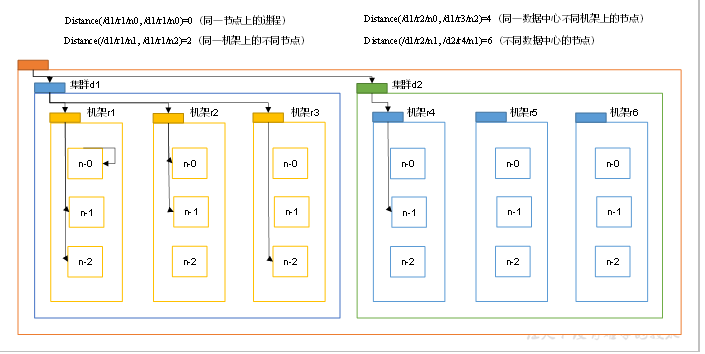

④网络拓扑—节点距离计算

在HDFS写数据的过程中,NameNode会选择距离待上传数据最近距离的DataNode接收数据。那么这个最近距离怎么计算呢?一张图回答。

节点距离:两个节点到达最近的共同祖先的距离总和,也可以简单理解为一个节点到达另一个节点需要的步骤。

同节点:不需要移动,距离0

同机架不同节点:节点1先到机架上再从机架去找另一个节点

同一集群不同机架:节点1先到机架再到集群找到另一个节点所在机架,去对应机架,去对应节点。......

Lastbutnotleast的知识点

nn和2nn工作机制

一个问题:nn中的元数据是存储在哪里的?

假设在nn节点所在磁盘中,因为经常需要进行随机访问,还要响应客户请求,效率会很低,因此元数据需要存放在内存中。但如果只存放在内存中,一旦断电,元数据就会丢失从而导致集群无法工作。因此**在磁盘中备份元数据的Fsimage**.这样会带来新的问题:当在内存中的元数据更新时,**如果同时更新Fsimage,会导致效率过低**,但如果不更新就会发生一致性问题,一旦nn节点断电数据就会丢失。因此,**引入Edits文件(只进行追加操作)效率很高**。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到Edits中,通过Fsimage和Edits的合并合成元数据,这样就算nn节点断电也没关系。旦nn节点断电数据就会丢失。因此,**引入Edits文件(只进行追加操作)效率很高**。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到Edits中,通过Fsimage和Edits的合并合成元数据,这样就算nn节点断电也没关系。但是,如果长时间添加数据到Edits中,会导致该文件数据过大,效率降低,而且一旦断电,恢复元数据需要的时间过长。因此,需要定期进行FsImage和Edits的合并,如果这个操作由NameNode节点完成,又会效率过低。因此,引入一个新的节点SecondaryNamenode,专门用于FsImage和Edits的合并。

工作机制:

1)第一阶段:NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,直接加载编辑日志和镜像文件到内存。

(2)客户端对元数据进行增删改的请求。

(3)NameNode记录操作日志,更新滚动日志。

(4)NameNode在内存中对元数据进行增删改。

2)第二阶段:Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。直接带回NameNode是否检查结果。

(2)Secondary NameNode请求执行CheckPoint。

(3)NameNode滚动正在写的Edits日志。

(4)将滚动前的编辑日志和镜像文件拷贝到Secondary NameNode。

(5)Secondary NameNode加载编辑日志和镜像文件到内存,并合并。

这篇关于如何打通HDFS任督二脉的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!