本文主要是介绍谷歌Gemini API 应用(二):LangChain 加持,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

昨天我完成了谷歌Gemini API 应用(一):基础应用这篇博客,今天我们要在此基础上实现Gemini模型的Langchian加持,因为Gemini API刚发布没几天,所以langchian还没有来得及将其整合到现有的langchain包的架构内,langchain公司目前发布了需要独立安装的支持Gemini API的langchain包:“langchain-google-genai”, 相信过不了多久它就会被整合到现有的langchain包的架构内。

一,配置环境

我们需要安装以下python包:

pip -q install google-generativeai==0.3.1

pip -q install langchain-google-genai

pip -q install langchain_experimental langchain_core

pip -q install "langchain[docarray]"二、配置API_KEY

当我们在Google AI Studio页面上创建了api key以后,我们就可以在本地通过该api_key来访问谷歌的Gemini Pro等模型,下面我们来导入本次实验需要使用的python包,并配置谷歌的api_key:

import google.generativeai as genai

from IPython.display import display

from IPython.display import Markdown

import osos.environ["GOOGLE_API_KEY"] = 'your_google_api_key'#填入自己的api_key三、模型查看

下面我们查看一下本次实验需要使用的三个谷歌Gemini模型的具体信息:

genai.configure(api_key=os.environ["GOOGLE_API_KEY"])models = [m for m in genai.list_models() if m.name in (['models/gemini-pro','models/gemini-pro-vision','models/embedding-001'])]

models

在本次实验中我们会用到谷歌的三个模型分别是 语言模型gemini-pro,多模态模型gemini-pro-vision,嵌入模型embedding-001,上面我们列出来了这3个模型的具体信息包括具体的参数如输入,输出的token大小的限制等。下面我们先原生的Gemini的api来实现最基本的内容生成功能:

prompt = '你是谁,你能做什么?'model = genai.GenerativeModel('gemini-pro')response = model.generate_content(prompt)Markdown(response.text)

四、Gemini with LangChain

接下来我们通过LangChain来实现上述的内容生成功能:

from langchain_google_genai import ChatGoogleGenerativeAI,GoogleGenerativeAIEmbeddings

from langchain.vectorstores import DocArrayInMemorySearch

from langchain.prompts import ChatPromptTemplate

from langchain.schema.output_parser import StrOutputParserllm = ChatGoogleGenerativeAI(model="gemini-pro")

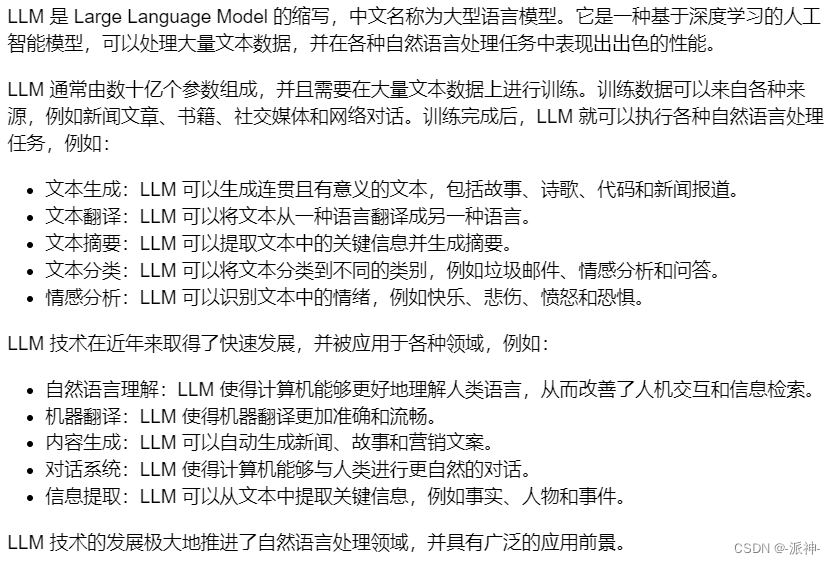

result = llm.invoke("LLM 是什么?")

Markdown(result.content)

这里我们看到通过langchian也很轻松的实现了gemini的内容生成的功能,不过这里需要说明的是我们在创建langchain的llm的时候我们并没有填写apk_key, 这是因为这里的gemini的llm它默认会去读取os的api_key的环境变量,因为在前面的代码中我们已经配置好了os的api_key,所以这里在创建llm时就无需填写api_key的参数了。

五、langchain的stream和batch

流式(stream)输出和批处理(batch)是langchain的两大优秀功能,流式输出可以给用户带来更好的用户体验,而批处理则可以提高用户的工作效率,因为它可以让llm同时处理多个问题,下来我们就来测试一下langchain的stream和batch能力:

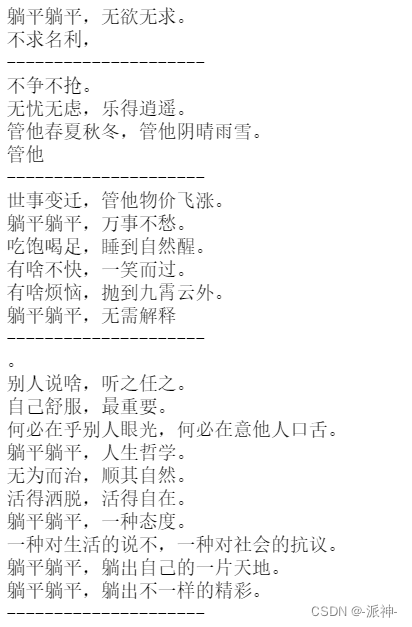

for chunk in llm.stream("写一首关于躺平的打油诗。"):print(chunk.content)print("---------------------")

因为流式输出每次只输出部分结果,所以响应时间比较短,这会给用户带来比较好的用户体验,下面我们看一下批处理:

results = llm.batch(["2+2等于几?","3+5等于几?",]

)

for res in results:print(res.content)![]()

这里我们同时向llm询问了两个简单的数学问题,llm能够同时给出这些问题的正确答案,这说明llm具备同时处理多个问题的能力。

六、Chain的使用

在我之前的多篇博客中都详细介绍了在langchian中使用chain的方法,这里我们也要尝试一下在gemini模型环境下如何来使用chian。

model = ChatGoogleGenerativeAI(model="gemini-pro",temperature=0.7)prompt = ChatPromptTemplate.from_template("给我讲一个关于{topic}的笑话"

)output_parser = StrOutputParser()chain = prompt | model | output_parserresponse = chain.invoke({"topic": "躺平"})

print(response)

这里我们使用了langchain的LCEL语法创建了一个chian, 这和我们之前介绍langchian的博客中的方法是一样的,同样我们也能得到想要的结果,不过这里我们需要说明的是,这里我们在创建model的时候设置了参数temperature=0.7, temperature这个参数的取值范围为0-1,它表示生成结果的随机性,temperature越高,产生结果的随机性越大,因此当我们需要让llm讲故事或者讲笑话的时候,我们可以适当调高temperature的值,这样每次都会产生不一样的结果的概率就会比较大,而当我们需要llm做一些严谨的数学或者逻辑的推理/计算时,我们可以调低temperature的值,甚至可以将temperature设置为0,因为这时候我们需要llm给出严谨的唯一的答案。

七、简单的RAG

在我之前的使用langchain与你自己的数据对话系列的博客中详细介绍了RAG即检索增强生成(Retrieval Augmented Generation),现在我们也需要测试一下gemini模型的RAG能力,下面我们创建一个简单的向量数据库,并存储四条文本,然后我们向llm询问有关文本的内容:

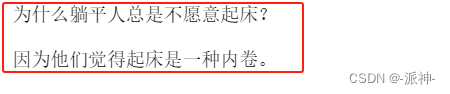

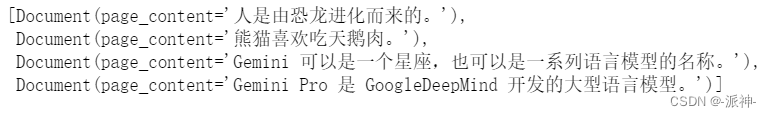

embeddings = GoogleGenerativeAIEmbeddings(model="models/embedding-001")vectorstore = DocArrayInMemorySearch.from_texts(["Gemini Pro 是 GoogleDeepMind 开发的大型语言模型。","Gemini 可以是一个星座,也可以是一系列语言模型的名称。","人是由恐龙进化而来的。","熊猫喜欢吃天鹅肉。"],embedding=embeddings # passing in the embedder model

)retriever = vectorstore.as_retriever()这里我们创建了一个内存向量数据库,并向其中存储了4条文本,然后使用了gemini的嵌入模型“embedding-001”作为文本嵌入工具,最后我们通过向量数据库创建了一个检索器retriver, 接下来我们可以通过检索器retriver来检索向量数据库中的相关文档:

retriever.get_relevant_documents("Gemini 是什么?")

这里我们看到检索器retriver返回了相关的文档,并按文档的内容与问题的相关度对文档进行了排序。

retriever.get_relevant_documents("人从哪里来的?")

接下来我们来创建chian, 不过在创建chian之前我们需要创建prompt模板和RunnableMap,最后将它们组合成一个chain:

from langchain.schema.runnable import RunnableMap#创建prompt模板

template = """Answer the question a a full sentence, based only on the following context:

{context}

Question: {question}

"""#由模板生成prompt

prompt = ChatPromptTemplate.from_template(template)#创建chain

chain = RunnableMap({"context": lambda x: retriever.get_relevant_documents(x["question"]),"question": lambda x: x["question"]

}) | prompt | model | output_parser

当我们创建完chain以后就可以使用invoke方法来调用chain了:

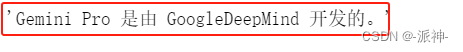

#调用chain

chain.invoke({"question": "谁开发了 Gemini Pro?"})

chain.invoke({"question": "Gemini是什么?"}) ![]()

chain.invoke({"question": "人是从哪里来的?"}) ![]()

chain.invoke({"question": "熊猫喜欢吃什么?"})![]()

八、PAL Chain

PALChain是Langchain中用于生成代码的程序辅助语言模型 (PAL) 解决方案。 PAL 是论文“Program-Aided Language Models”中描述的一种技术 (https://arxiv.org/pdf/2211.10435.pdf)下面我们使用langchian的PALChain来实现两个简单的数学逻辑推理题:

from langchain_experimental.pal_chain import PALChainmodel = ChatGoogleGenerativeAI(model="gemini-pro",temperature=0)pal_chain = PALChain.from_math_prompt(model, verbose=True)这里我们创建了一个model和pal_chain ,并设置了temperature=0, 这是因为我们接下来需要做严谨的逻辑推理,不需要llm产生随机性的结果,因此我们设置了temperature=0。

question ="食堂有23个苹果。如果午餐用了20个,之后又买了6个,那么食堂最后还剩多少个苹果?"

pal_chain.invoke(question)

这里我们看到pal_chain在内部定义了一个solution的pyhon函数,并在该函数中做了逻辑推理,最后得到了正确的计算结果。

question ="""

如果小明早上 7:00 起床,并且他在家花了 1 小时吃早餐,

然后又花了 30 分钟步行去学校,小明几点到的学校?

"""

pal_chain.invoke(question)

这里我们看到llm对时间的概念还存在一点问题,它并没有将最后的结果8.5转换成时间格式,而是直接以十进制的格式给出了最后的答案。

九、多模态支持

在langchain中使用多模态模型时我们需要用到langchian的HumanMessage类,它规定了一套与多模态模型对话的格式,下面我们将会将一个图片的url地址,然后询问gemini的多模态模型关于图片内容的问题:

import requests

from IPython.display import Imageimage_url = "https://upload.wikimedia.org/wikipedia/commons/e/e7/Everest_North_Face_toward_Base_Camp_Tibet_Luca_Galuzzi_2006.jpg"

content = requests.get(image_url).content

Image(content,width=300)

from langchain_core.messages import HumanMessage

from langchain_google_genai import ChatGoogleGenerativeAIllm = ChatGoogleGenerativeAI(model="gemini-pro-vision")# example

message = HumanMessage(content=[{"type": "text","text": "这个图片里有什么,它位于什么地方?",}, # You can optionally provide text parts{"type": "image_url","image_url": image_url},]

)llm.invoke([message])![]()

这里我们给gemini-pro-visio模型一张珠穆朗玛峰的图片url,然后询问图片里有什么,它位于什么地方,我们看到llm能准确识别图片中的内容,并且给出了珠穆朗玛峰的地理位置,效果还是不错的。

总结

今天我们学习了在langchain中使用gemin模型的的一些方法,总的来说使用方法和其他的模型如openai的模型的方法都是类似的。今天我们还尝试了langchain的stream和beath方法在gemini模型上的应用,还介绍了RAG、PAL Chain的应用,最后我们用一个简单例子介绍了langchain中使用gemini多模态模型的方法。希望今天的内容对大家学习gemini大模型有所帮助

参考资料

Google AI chat models | 🦜️🔗 Langchain

https://ai.google.dev/docs?hl=zh-cn

这篇关于谷歌Gemini API 应用(二):LangChain 加持的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!