本文主要是介绍【菜鸟学习论文】Parallax Attention for Unsupervised Stereo Correspondence Learning,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

(机翻)

贡献:

1.提出了一种通用的视差注意机制来学习在无监督方式下具有大视差变化的图像对的立体对应关系

2.PAM被成功地应用于两个特定的任务:立体匹配和立体图像SR。我们基于PAM的网络在立体匹配和立体图像SR方面都实现了最先进的性能。

3.提出了一种用于训练立体图像SR网络的Flickr数据集Flickr1024。这个数据集由1024个高质量的立体声图像对组成,并涵盖了各种场景。

2.相关工作

近几十年来,[3]、[5]、[6]、[7]、[8]、[10]等各种任务。在这里,我们关注两个特定的任务,包括立体匹配和立体图像SR。此外,我们还回顾了与我们的工作高度相关的注意机制。

2.1 立体匹配

2.1.1受监督的立体匹配

传统的立体匹配方法通常遵循一种流行的四步管道,包括匹配成本计算、成本聚合、视差计算和视差细化[14]。由于CNN在许多视觉任务中的成功,如对象识别[16]、[17]和检测[18]、[19],一些早期基于学习的方法[20]、[21]、[22]使用CNNs来替换立体匹配管道中的一个或多个步骤。Zbontar和Lecun[20]使用CNN来计算两个图像补丁之间的匹配成本。然后通过几种传统技术(包括基于交叉的成本聚合和半全局匹配)来预测视差图。Luo等人。[3]提出了一种点积运算来计算左右图像的一元特征表示之间的相关性。他们的网络具有较低的计算复杂度,并比[20]达到更高的效率。为了提高特征表示能力,利用金字塔池[23]和公路网络[22]分别扩大了接受域,深化了网络。这两种方法所产生的是比[20]更准确的差异。

为了实现更好的性能,提出了几种方法[4]、[11]、[14]将所有步骤集成到端到端架构中进行联合优化。Mayer[11]提出了一个名为DisPNet的端到端CNN来消除立体图像的差异。具体地说,一维相关操作用于生成三维成本量来匹配成本学习。在DispNet之后,已经提出了一些工作[14],[24]来使用相关操作和三维成本量来进行视差估计。梁等人。[14]使用特征常量来弥合视差计算和视差细化之间的差距。因此,他们的网络可以将视差计算和视差细化步骤无缝地集成到一个紧凑的网络中,以提高效率。

最近的方法[4]、[5]、[13]通常使用连接来生成4D成本卷,然后使用3DCNNs来匹配成本聚合。GC-Net[4]是第一个使用朴素连接而不是相关性来构建四维成本卷的工作。具体地说,三维卷积用于聚合四维成本量内的上下文信息,以匹配成本聚合。遵循GC-Net,Chang等人。[5]提出了一种带有空间金字塔池模块的金字塔立体匹配网络(PSMNet),以扩大接受域以获得更有代表性的特征。在PSMNet中,堆叠的三维沙漏网络被用于聚合多个尺度上的匹配成本。受半全局匹配(SGM)方法的启发,[25],Zhang等人。[26]引入了半全局和局部引导的聚合层,以聚合不同方向和局部区域的匹配成本。

2.1.2 无监督立体匹配

由于难以收集具有密集标记地面真相深度的大数据集,已经开发了几种方法[24]、[27]、[28]来以无监督的方式学习立体匹配。

Zhou等人[27]采用左右一致性检查来生成一个置信图来指导网络的训练。Yang等人[24]提出了一种使用语义线索的立体声网络来进行立体匹配.具体地说,他们引入了一个分割子网络来提供语义特征,并提出了一种语义损失正则化方法来提高视差估计的鲁棒性。Li等人。[28]提出了一种遮挡感知立体匹配网络(OASM)来利用遮挡线索进行立体匹配。具体地说,他们引入了一个遮挡推理模块来提供遮挡线索,并提出了一种混合损失来利用视差和遮挡之间的相互作用作为网络训练的监督。

现有的监督和无监督立体匹配方法常用于3D/4D成本卷来捕获大差异上的立体对应。然而,固定的最大视差阻碍了他们处理不同的视差差异较大的立体图像。此外,4D成本卷还需要较高的计算成本和内存成本。

3.PAM

在本节中,我们将详细介绍我们的PAM。我们首先介绍了PAM的公式,然后根据我们的PAM描述了左向一致性、周期一致性和有效掩模

3.1 Formulation

3.1.1 Overview

在自我注意机制中,首先将RH×W×C大小的特征图重塑为RHW×C的大小。然后,采用矩阵乘法(RHW×C×RC×HW)来计算图像中任意两个位置的相关性。对于立体图像,左图像中像素的对应像素仅位于右图像中的上极线。考虑到这种上极约束,我们的PAM使用专门设计的重塑操作(reshape operation)和几何感知矩阵乘法( geometry-aware matrix multiplication)来计算左图像中的像素与右图像中沿上极线的所有位置之间的相关性。

如图3所示,给定立体图像对的两个特征图A、B∈RH×W×C,首先将它们输入到1×1卷积以进行特征适应。A被输入到一个1X1卷积中以生成query feature map Q∈RH×W×C。同时,B被输入到另一个1×1卷积中,以生成一个关键特征图(key feature map)K∈RH×W×C,然后被重塑为RH×C×W。然后,在Q和K之间进行矩阵乘法,并应用一个softmax层,从而得到一个视差注意映射MB→A∈RH×W×W。通过矩阵乘法,我们的PAM可以有效地将沿上极性线的任意两个位置之间的特征相关性编码到辅助注意图中。视差注意图有几个显著的性质,如在Sec3.2和3.3中所描述的。接下来,将B输入1×1卷积,生成响应特征图R∈RH×W×C,再乘以MB→A,生成输出特征O∈RH×W×C。同时,还生成有效的掩码VB(第3.3节)。

应指出的是,PAM中考虑了所有的差异。也就是说,我们的PAM不需要手动设置一个固定的最大差异,而可以处理大的差异变化。由于PAM可以学习使用特征相似性来关注精确差异下的特征,因此可以捕获对应关系。

3.1.2 Toy Example

我们使用一个玩具示例来进一步说明我们的PAM,如图4所示。给定大小为30×30的左右立体图像对,大小为30×30×30的左→右和右→左的视差注意图可以由我们的PAM生成。注意,每个视差注意图(例如,Mright→left(i,:,:))提供对应行(即left(i,:)和right(i,:))之间的依赖关系。 如果一对立体图像之间的视差为零,那么所有的视差注意力映射都是身份矩阵,如图所示4(a)。这是因为left(i,:)中的第j像素对应于light(i,:)中的第j像素。因此,我们会关注Mright→left的位置(j,j)。对于具有非零差异的区域,例如,图4(b)中的红色区域视差为5,left(i,:)中的j像素对应rlight(i,:)中的(j−5)像素。因此,重点关注右→左的位置(j,j−5)。立体对应关系可以用视差注意图中聚焦像素的位置来描述。

此外,遮挡还可以用视差注意映射进行编码。具体来说,它可以从图4的右→左观察到,4(b)几个垂直区域被“丢弃”,而不关注任何位置。这是因为,right(i,:)中的这些区域在Ieft(i,:)中被遮挡,因此不应关注通信。类似的“丢弃”水平区域也会由遮挡引起。

应该注意的是,在我们的玩具例子中只考虑了整数的差异,这不是真正的情况。在实践中,我们的PAM可以关注相邻的像素来处理亚像素的差异。由于PAM中使用的软最大层,“废弃”水平区域的几个像素。然而,这些被遮挡的区域可以使用有效的遮罩被排除在外,如Sec3.3所示。

3.2 左右方向的一致性和周期一致性

为了捕获可靠和一致的对应关系,我们引入了左右一致性和循环一致性来规范我们的PAM。

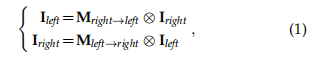

给定从一对立体图像中提取的特征表示,我们的PAM将生成两个视差注意力图(左→右和右→左)。理想情况下,如果我们的PAM捕获了准确的对应关系,就可以获得以下左右一致性:

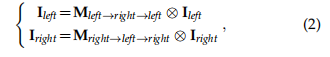

其中,⊗表示具有几何图形感知的矩阵乘法。基于等式(1),我们可以进一步推导出一个循环一致性:

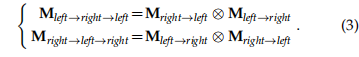

其中循环注意图左→右→左和右→左→右可以计算为:

我们进一步说明了图5中的几何感知矩阵乘法⊗(1. ⊗ can be implemented using tf.matmul() or torch.matmul().)。

以等式(1)为例,相应切片在Mright→left和right的乘积决定了left,即left(i、:::)∈RW×C. 所有这些切片都被连接起来,以获得left∈RH×W×C。

3.3 有效的掩码

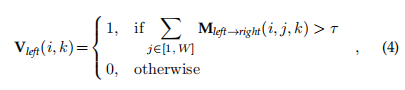

由于左右一致性和周期一致性对于遮挡区域不成立,我们基于视差注意图进行遮挡检测,以生成有效的掩模,并只对这些有效区域执行一致性正则化。如3.1.2所示,遮挡被编码为视差注意图中的“丢弃”区域。在实际实践中,与遮挡区域相对应的垂直“丢弃”区域通常在视差注意图中分配小权值。这是因为,左图像中被遮挡的像素在右图像中找不到其对应关系,它们与所有差异的特征相似性都较低。因此,一个有效的掩模Vleft∈RH×W可以通过:

其中,τ是一个阈值(在本文中根据经验设置为0.1)。有效掩模的一个例子如图6所示。在实践中,我们使用几种形态学操作来处理孤立的像素和有效掩模中的孔。

综上所述,我们的PAM为无监督的立体对应通信学习提供了一种灵活和有效的方法,并可以应用于各种立体视觉任务。在本文中,我们演示了PAM在两个典型的立体任务上的有效性:立体匹配和立体图像SR。

4 PAM FOR UNSUPERVISED STEREO MATCHING

立体声匹配旨在寻找立体声图像对之间的对应像素。由于差异在实际应用中差异显著,成本量技术的固定最大差异阻碍了它们处理大的差异变化。相比之下,我们的PAM可以通过有效地计算沿上极性线的任意两个位置之间的特征相关性来消除设置一个固定的最大视差。因此,PAM可以用于无监督的立体匹配来处理大的视差变化。

4.1 Network Architecture

4.1.1 Overview

在我们的PAM基础上,我们提出了一个视差注意力立体匹配网络(PASMnet)。我们的PASMNet的架构如图7所示。给定一对大小为H×W的立体图像,它们首先被输入沙漏网络进行特征提取。提取出的左右图像被输入到一个级联视差注意模块,以粗到细的方式降低匹配成本。接下来,可以使用输出模块从匹配成本中获得初始视差。最后,利用沙漏网络进一步细化了初始的视差,从而产生了输出视差。

与基于成本量的使用三维卷积明确地聚合匹配成本的方法[4],[5]不同,我们的网络通过级联几个视差注意块来执行隐式匹配成本聚合,如图8所示。在这里,为了简单起见,在视差注意块中只考虑了一个3×3卷积层(没有批处理归一化和ReLU层)。

4.1.3 Output Module

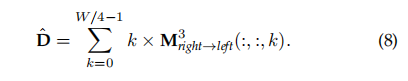

如图7(a)所示,级联级差注意模块每个阶段最后一个块的匹配成本 输入 输出模块。在阶段3的输出模块内,C3先馈入软最大层,生成视差注意图M3∈RH/4×W/4×W/4,如图7©所示。接下来,M3用于生成有效掩模V3。一旦获得M3右→左,视差可以恢复为:

注意,估计的视差是由视差注意图加权的所有视差候选值的和。因此,我们的PASMnet不需要手动设置一个固定的最大差异,并且可以处理较大的差异变化。由于遮挡区域的像素找不到其对应关系,遮挡区域的视差不能得到很好的处理。因此,我们排除了这些无效的差异,并填充了使用部分卷积[47]的遮挡区域。

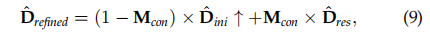

4.1.4 视差细化

在级联视差注意模块之后,引入了一个利用来自左图像的特征作为引导的视差细化模块,以提供类似边缘的结构信息。如图7(a)所示,初始视差Dini与F4_left连接,并输入沙漏网络,生成残余视差图Dres和置信图Mcon。最后,将细化的差异计算为:

其中,↑是一个双线性上采样运算符。

4.2 Losses

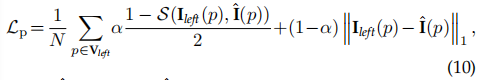

4.2.1 光度测量损耗

在[28],[48],[49]之后,我们引入了一个由平均绝对误差(MAE)损失项和结构相似性指数(SSIM)损失项组成的光度损失。请注意,由于光度一致性只适用于非遮挡区域,因此光度损失表示为:

其中,ˆI=W(Irict,ˆDrefined)和W是一个使用精细视差的扭曲运算符。S是SSIM函数,p表示有效掩码覆盖的有效像素,N是有效像素数,α经验设置为0.85。

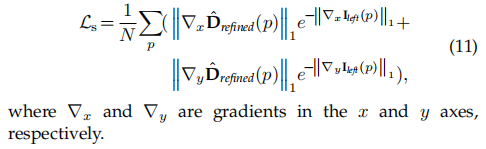

4.2.2 平滑度损失

在[28],[48]之后,我们使用一个具有边缘感知的平滑性损失来鼓励视差的局部平滑性,其定义为:

4.2.3 PAM损失

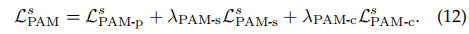

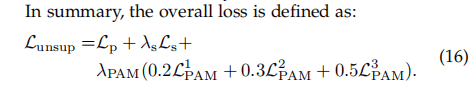

我们引入了三个额外的损失在多尺度来规范我们的PAM,以捕获准确和一致的立体对应。尺度s(s=1、2、3)的PAM损失术语定义为:

这篇关于【菜鸟学习论文】Parallax Attention for Unsupervised Stereo Correspondence Learning的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!