本文主要是介绍网站迟迟不被收录,竟然是这个坑,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

背景

最近写了个网站,想提交被百度收录。但是两个月了百度迟迟没有收录,后来排查并优化了网站内容、标题、关键字等各种内容。但是失踪没有被收录,今天发现竟然是这个小问题导致网站迟迟不被收录。大家一起看下。

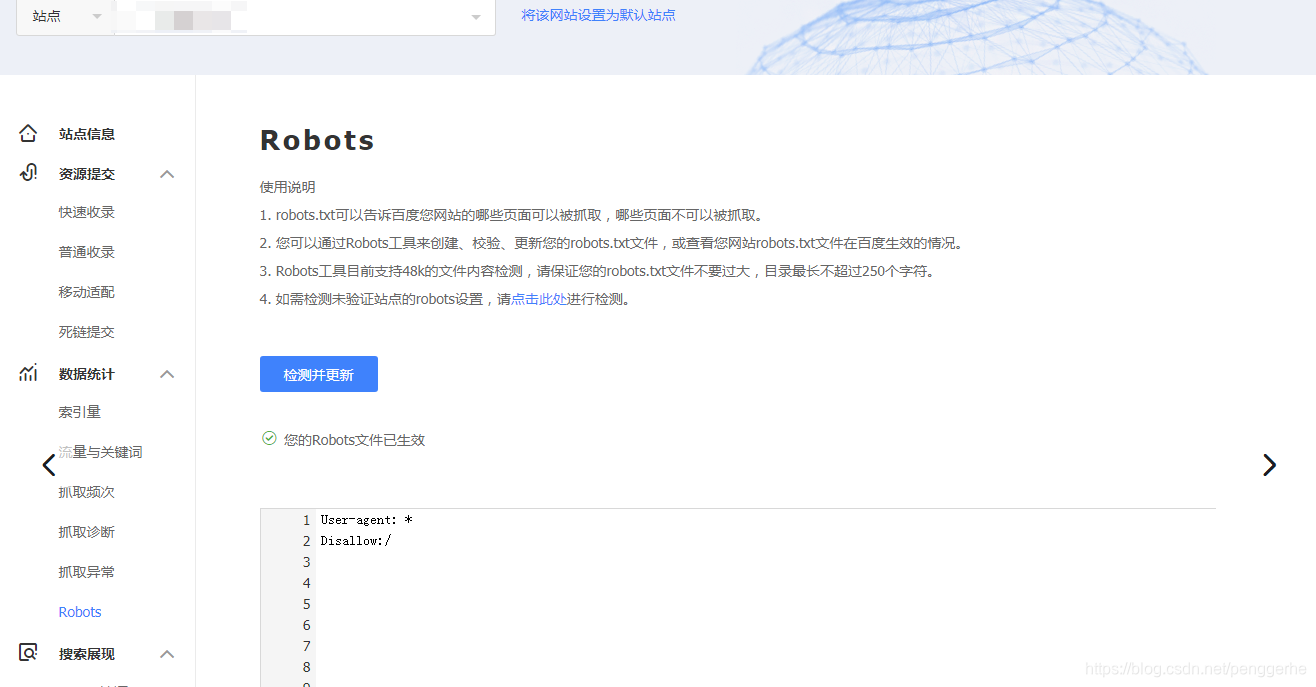

百度提示有禁用

由于该网站的robots.txt文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述;

根据这个提示,我这服务器上找是否有robots.txt文件,找了很久,没有发现。然后通过百度工具检测,发现以下问题:

天哪,竟然设置了Robots禁用爬虫,终于找到原因了。然后就是开始全局找到这个文件,把禁用内容删除。

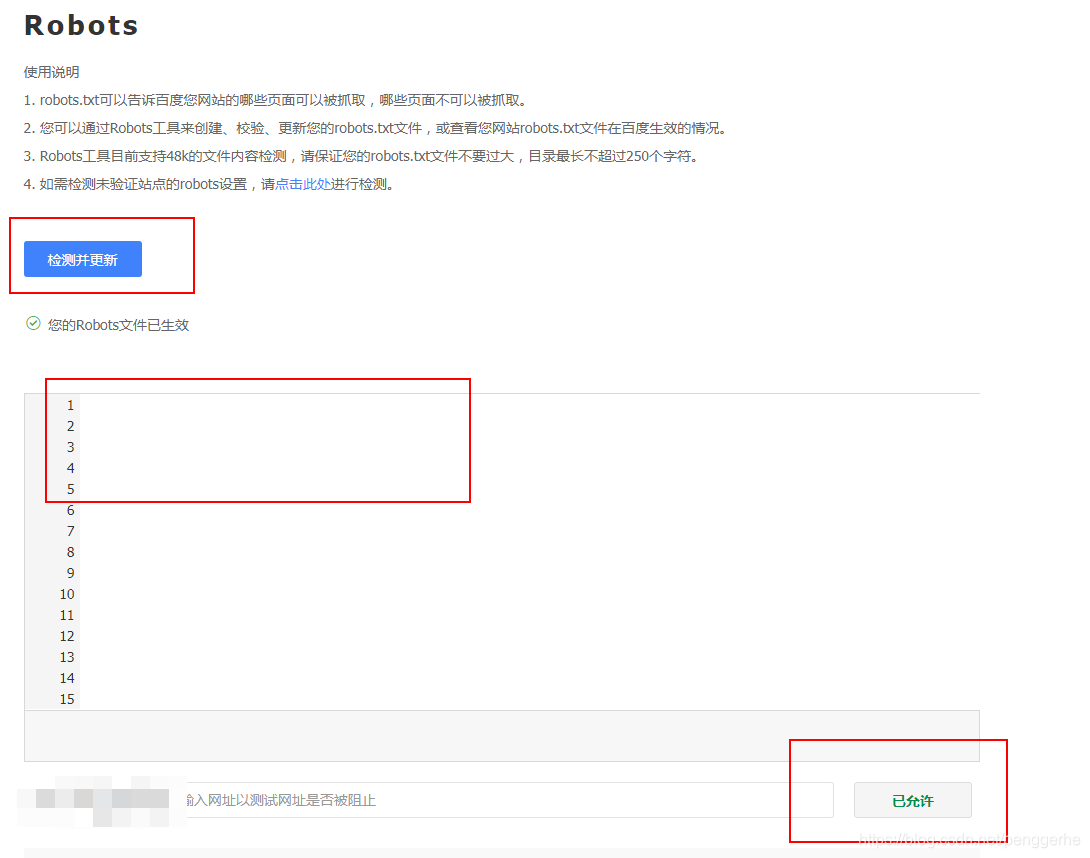

正常了

总结

如果大家网站迟迟不被收录,可以看下是否被禁用了。这个给大家一个检测工具地址:https://ziyuan.baidu.com/robots/index

【处理方式】

1.修改Robots封禁为允许,然后到百度站长后台检测并更新Robots。

2.在百度站长后台抓取检测,此时显示抓取失败,没关系,多点击抓取几次,触发蜘蛛抓取站点。

3.在百度站长后台抓取频次,申请抓取频次上调。

4.百度反馈中心,反馈是因为误操作导致了这种情况的发生。

5.百度站长后台链接提交处,设置数据主动推送(实时)。

6.更新sitemap网站地图,重新提交百度,每天手工提交一次。

以上处理完,接下来就是等待了,万幸,2天的时间数据开始慢慢回升,到第3天基本回升到正常状态!

这篇关于网站迟迟不被收录,竟然是这个坑的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!