本文主要是介绍张家口二手房出售,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

http://zjk.58.com/ershoufang/?PGTID=0d200001-00d0-049b-73be-3f8391192abf&ClickID=2

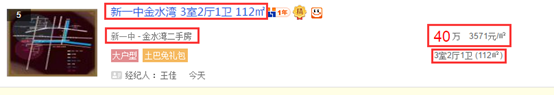

爬取内容:

因为之前有爬取58同城的手机信息和安居客的信息,所以看到这项任务心里还是很欣喜的,毕竟熟悉过 ,以为几分钟就可以搞定,但是,,,

,以为几分钟就可以搞定,但是,,,

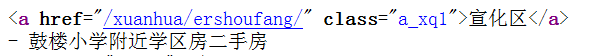

首先,查看页面元素,发现所需内容均在<td class="t"></td>内,便确定用beautifulsoup爬取,格式化代码写完之后,发现在爬取二手房地址时出现了问题,查看源代码,发现地址的源代码有两种写法,如下:

第一个href是没有区别的,但是第二个有的有,有的没有,各种查询之后,决定用python的兄弟节点,同时使用if语句,将这两种地址爬取出来。

接着按照惯例进行写代码,问题不是太大。

最后,完整代码如下:

#encoding=utf8

import re

import urllib

import urllib2

from bs4 import BeautifulSoup

for i in range(1,71):url = 'http://zjk.58.com/ershoufang/h1/pn'+str(i)user_agent = "Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:49.0) Gecko/20100101 Firefox/49.0"headers = {"User-Agent":user_agent}request = urllib2.Request(url,headers=headers)response = urllib2.urlopen(request)html = response.read()bs = BeautifulSoup(html,"html.parser")data = bs.find_all("td",class_='t')for xinxi in data:mc = xinxi.find('a',class_='t').get_text("|",strip=True).encode('utf8')dz1 = xinxi.find('div', class_='qj-listleft').find('a',class_='a_xq1')dz3 = xinxi.find('div', class_='qj-listleft').find('a', class_='a_xq1').get_text("|",strip=True).encode('utf8')if len(dz1.next_sibling) == 52:dz2 = xinxi.find('div', class_='qj-listleft').find('a', class_='a_xq1', target="_blank").get_text("|",strip=True).encode('utf8')dz = dz3+dz2else:dz = dz1.next_siblingdz = dz3+dz.encode('utf8')dz = dz.replace('\n', '')dz = dz.replace(' ', '')dz = dz.replace('-', '')sz = xinxi.find('div', class_='qj-listright btall').get_text(strip=True).encode('utf8')sz = sz.replace('\n', '')sz = sz.replace(' ', '')cs = open('csf.txt','a+')cs.write(mc + "|" + dz + "|" + sz + "\n")cs.close()

print 11

这篇关于张家口二手房出售的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[每日一练]销售分析——特点年份才出售的商品](/front/images/it_default.gif)