本文主要是介绍pika的安装使用及主从配置,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

`简介`

Pika是一个可持久化的大容量redis存储服务,兼容string、hash、list、zset、set的绝大部分接口(兼容详情),解决redis由于存储数据量巨大而导致内存不够用的容量瓶颈,并且可以像redis一样,通过slaveof命令进行主从备份,支持全同步和部分同步,pika还可以用在twemproxy或者codis中来实现静态数据分片。

`特点`

容量大,支持百G数据量的存储

兼容redis,不用修改代码即可平滑从redis迁移到pika

支持主从(slaveof)

完善的运维命令

1、下载安装包

文件已上传,以下地址可下载

https://download.csdn.net/download/weixin_44320761/16136634

2、解压安装包

#安装依赖

yum -y install bzip2

#解压安装包

tar -jxvf pika-linux-x86_64-v3.3.5.tar.bz2

3、移动目录至/usr/local

mv output /usr/local/pika

4、修改配置

#日志文件路径

10 log-path : ./log/

#数据文件路径

12 db-path : ./db/

#用户密码认证

22 userpass : foobared

#数据库个数

34 databases : 8

#后台启动

45 daemonize : yes

5、启动pika服务

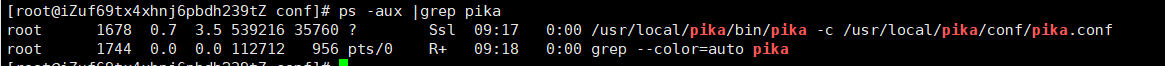

/usr/local/pika/bin/pika -c /usr/local/pika/conf/pika.conf

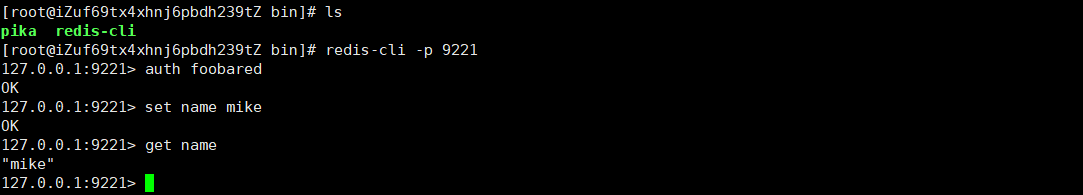

6、用redis客户端连接即可

redis-cli -p 9221

7、主从配置

cp -p /usr/local/pika/conf/pika.conf /usr/local/pika/conf/pika-slave.conf

#修改从配置

#启动端口

2 port : 9222

#日志目录

10 log-path : ./log-slave/

#数据目录

12 db-path : ./db-slave/

#主库密码认证

20 masterauth : foobared

#启动进程文件

51 pidfile : ./pika-slave.pid

#主从配置

77 slaveof : 127.0.0.1:9221

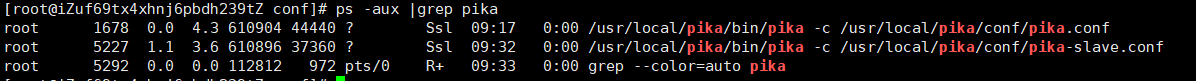

8、启动从库

/usr/local/pika/bin/pika -c /usr/local/pika/conf/pika-slave.conf

9、主从验证

#主库

[root@iZuf69tx4xhnj6pbdh239tZ bin]# redis-cli -p 9221

127.0.0.1:9221> auth foobared

OK

127.0.0.1:9221> set age 18

OK

127.0.0.1:9221> INFO replication

# Replication(MASTER)

role:master

connected_slaves:1

slave0:ip=172.16.2.244,port=9222,conn_fd=233,lag=(db0:0)(db1:0)(db2:0)(db3:0)(db4:0)(db5:0)(db6:0)(db7:0)

db0 binlog_offset=0 147,safety_purge=none

db1 binlog_offset=0 0,safety_purge=none

db2 binlog_offset=0 0,safety_purge=none

db3 binlog_offset=0 0,safety_purge=none

db4 binlog_offset=0 0,safety_purge=none

db5 binlog_offset=0 0,safety_purge=none

db6 binlog_offset=0 0,safety_purge=none

db7 binlog_offset=0 0,safety_purge=none

#从库

[root@iZuf69tx4xhnj6pbdh239tZ bin]# redis-cli -p 9222

127.0.0.1:9222> auth foobared

OK

127.0.0.1:9222> get age

"18"

127.0.0.1:9222> INFO replication

# Replication(SLAVE)

role:slave

master_host:172.16.2.244

master_port:9221

master_link_status:up

slave_priority:100

slave_read_only:1

db0 binlog_offset=0 147,safety_purge=none

db1 binlog_offset=0 0,safety_purge=none

db2 binlog_offset=0 0,safety_purge=none

db3 binlog_offset=0 0,safety_purge=none

db4 binlog_offset=0 0,safety_purge=none

db5 binlog_offset=0 0,safety_purge=none

db6 binlog_offset=0 0,safety_purge=none

db7 binlog_offset=0 0,safety_purge=none

这篇关于pika的安装使用及主从配置的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!