本文主要是介绍苹果官宣 iOS 17 全新辅助功能:iPhone 简易界面,还能学习用户嗓音,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

还记得去年全球无障碍宣传日(五月的第三个星期四)前夕,苹果就曾介绍过 iOS 16 即将加入的“门检测”等辅助功能。

就在昨日,苹果今年又一次在发布 iOS 17 系统之前,提前介绍了即将在 iOS 17 加入的一系列新增辅助功能。

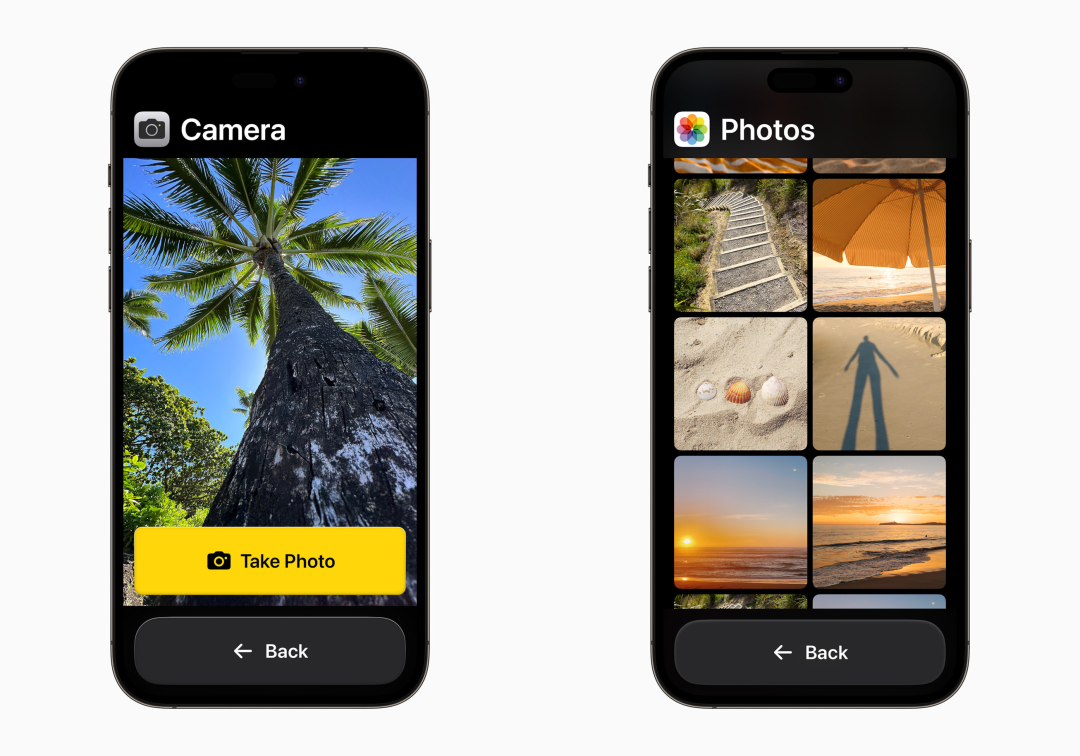

Assistive Access

此前外媒多次报道苹果正在研发一种新的 iPhone 操作界面,现在可以确定该界面命名为 Assistive Access。

苹果表示,Assistive Access 提炼了 iPhone 的相机、照片、音乐、电话、信息 app 的基本功能,以减轻用户的认知负担。

启用该模式后,iPhone、iPad 便会呈现精简版主屏幕,可设置为基于网格的图像化布局或分行布局。同时在该模式下,苹果预装的应用界面也经过了重新设计,按钮和交互方式更加简单易用。

简单来说,用户通过开启 Assistive Access 可将 iPhone 变身为界面简单、操作便捷的“老人机”,非常适合认知障碍用户或老年人、小朋友使用。

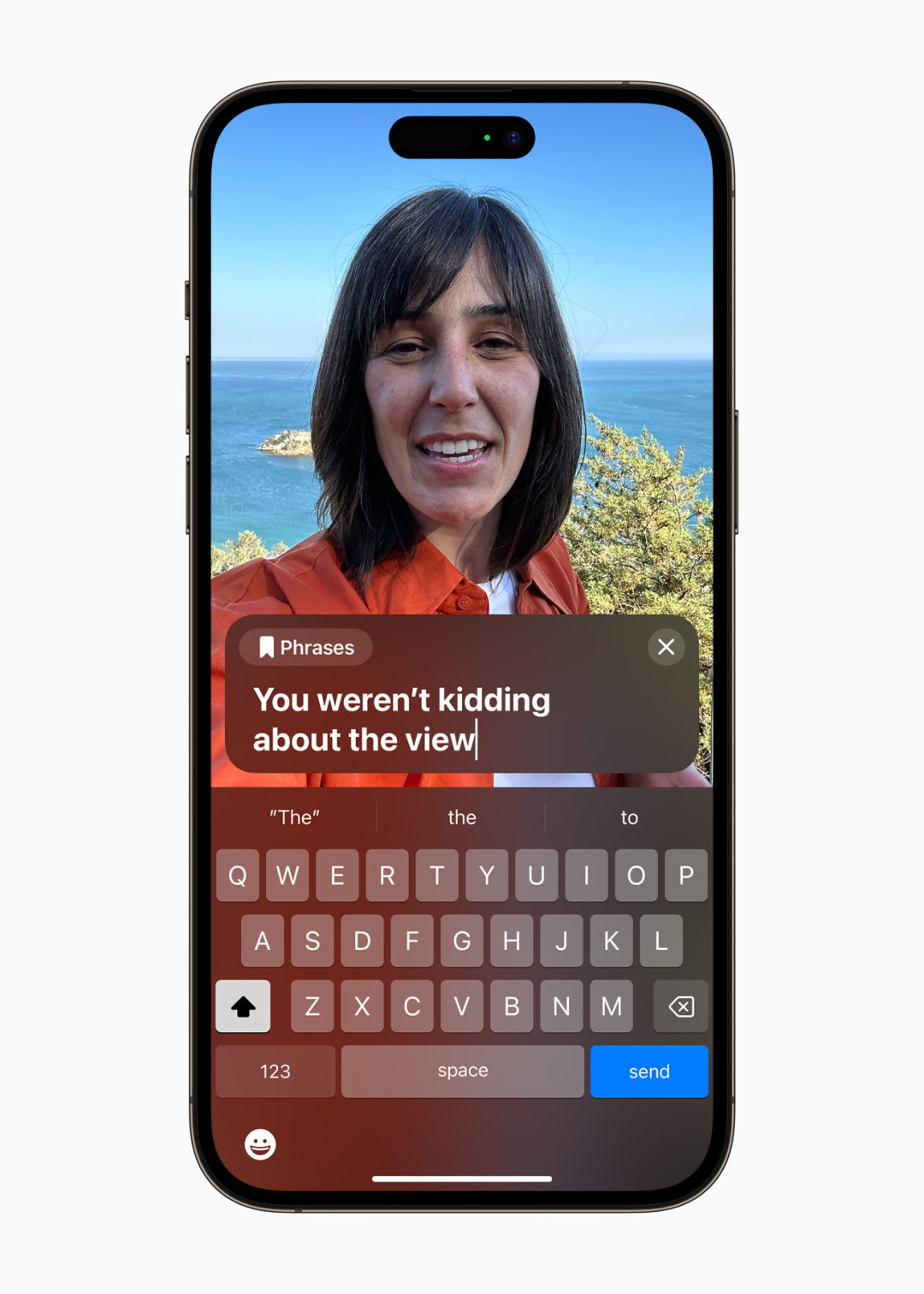

Live Speech

针对全球数以百万计的已失去或逐渐失去语言能力的人士,苹果宣布将为 iPhone、iPad 以及 Mac 设备推出Live Speech功能。

根据苹果的介绍,通过 Live Speech 功能,用户可以在打电话、进行 FaceTime 通话和面对面交流时输入自己想说的话,让设备将这些话大声朗读出来。用户还可以保存常用短语,在与家人、好友和同事交流时快速表达意见。

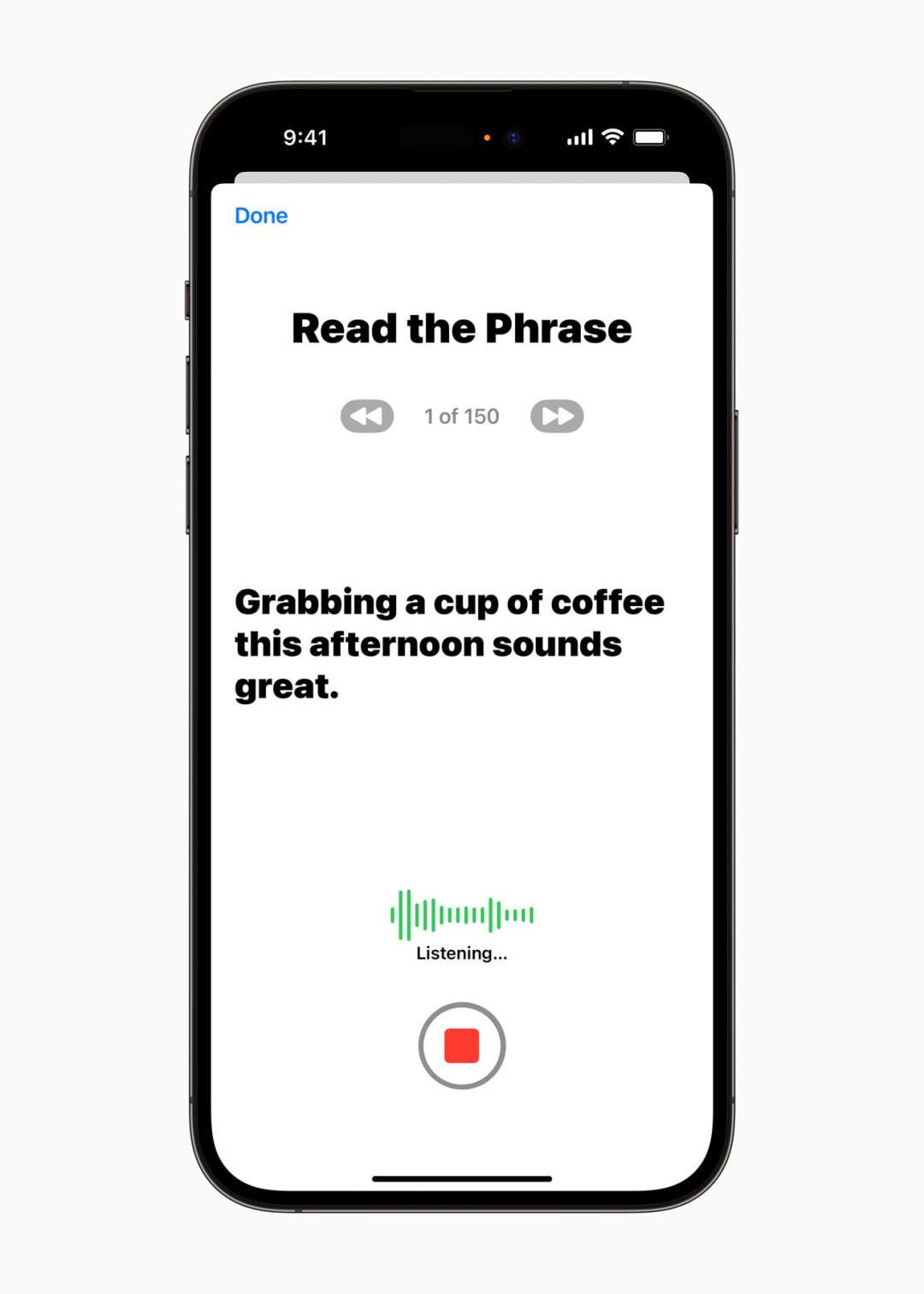

Personal Voice

除了 Live Speech 功能外,对于面临失语风险、近期被诊断患有 ALS(肌萎缩侧索硬化)或其他可能逐渐影响语言能力的疾病的用户,苹果还会推出Personal Voice辅助功能,这是一项简单安全的功能,可创建与用户嗓音相似的语音。

▲录制Personal Voice音频

用户可以使用 iPhone 或 iPad 录制 15 分钟的音频,朗读随机生成的文字提示,创建自己的 Personal Voice。苹果表示,这项语言辅助功能使用设备端机器学习技术,确保用户信息私密安全,并与 Live Speech 无缝集成,让用户可以在与所爱之人交流时通过 Personal Voice 说话。

Point and Speak

iOS 17 系统的「放大器」应用将再次得到增强,新增 Point and Speak 功能。该功能可结合 iPhone 相机和 LiDAR 激光雷达扫描仪输入的内容,识别并朗读出用户手指向的内容,这对于视力障碍用户会非常有帮助。

,时长00:07

作为 iPhone 与 iPad 放大器 app 的内置功能,Point and Speak 可与旁白协作,并与人物检测、门检测和图像描述等放大器的其他功能一同发挥作用,帮助用户在实体环境中游刃有余

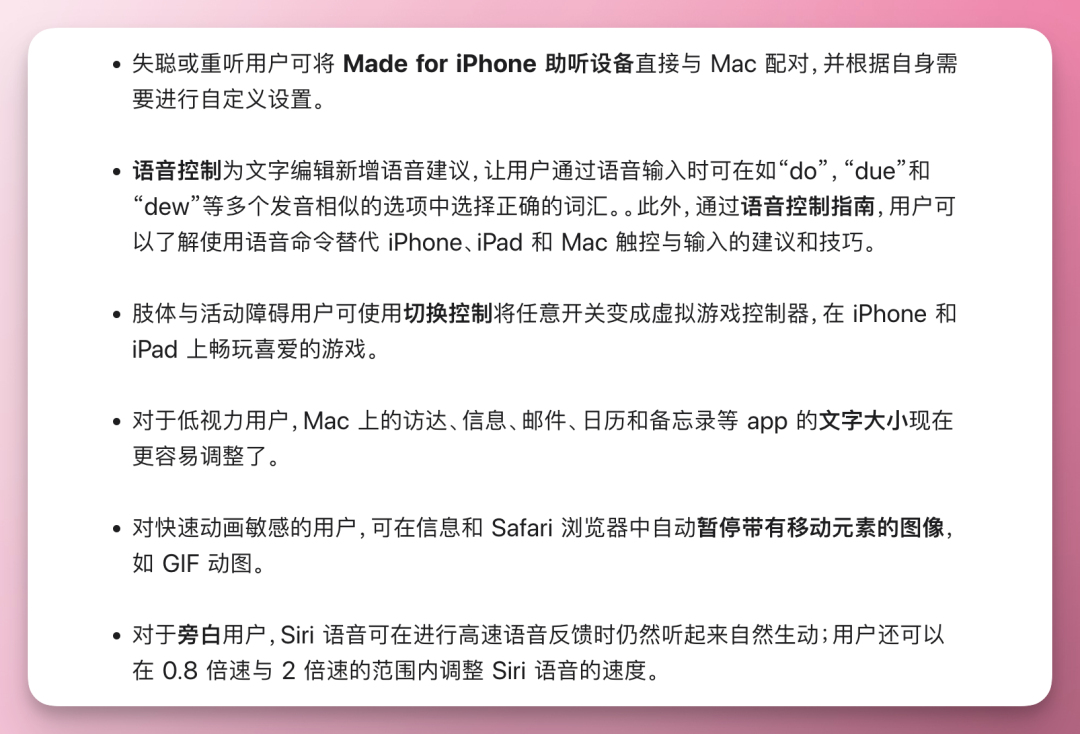

除了上面这些新增的辅助功能,iOS 17、iPadOS 17 系统的辅助功能还将包含下列改进:

苹果在 iPhone、iPad 上推出的一系列辅助功能,在提升设备的可用性和包容性方面发挥了重要作用,让那些有特殊需求的用户也能方便地使用设备,苹果对于辅助功能的持续投入和改进值得被肯定。

上述新增辅助功能将在今年晚些时候上线,也就是包含在接下来将要发布的 iOS 17、iPadOS 17 系统内。iOS 17 将在 6 月 6 日凌晨 WWDC23 主题演讲发布,首个面向大众的正式版本预计将于 9 月中下旬推送。

这篇关于苹果官宣 iOS 17 全新辅助功能:iPhone 简易界面,还能学习用户嗓音的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!