本文主要是介绍缺失值插补解释:六种插补方法?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

一、说明

二、什么是缺失值,为什么会出现缺失值?

2.1 什么是缺失值?

2.2 为什么会出现缺失值?

2.3 缺失数据类型

2.4 为什么要关注缺失值?

三、数据集

四、缺失数据的插值方式

4.1 方法 1:List-wise Deletion

4.2 方法 2:简单插补 — 均值和众数

4.3 方法 3:线性插值

4.4 方法 4:向前/向后填充

4.5 方法 5:常数值插补

4.6 方法 6:KNN 插补

五、结论:选择(和知识)的力量

5.1 警告:缺失值插补的目的和限制

5.2 缺失值插补汇总

六、附属信息

6.1 延伸阅读

6.2 技术环境

6.3 关于插图

一、说明

让我们谈谈每个数据科学家、分析师或好奇的数字计算者迟早必须处理的事情:缺失值。现在,我知道你在想什么 — “哦,太好了,又一个缺失值指南。但请听我说。我将向您展示如何使用不一种、两种而是六种不同的插补方法来解决这个问题,所有这些都在单个数据集上(还有有用的视觉效果!到最后,您将明白为什么领域知识物有所值(即使是我们的 AI 朋友也可能难以复制)。

所有视觉效果:使用 Canva 专业版创作。针对移动设备进行了优化;在桌面上可能会显得过大。

二、什么是缺失值,为什么会出现缺失值?

在我们讨论数据集和插补方法之前,让我们花点时间了解什么是缺失值,以及为什么它们在数据科学中如此普遍地令人头疼。

2.1 什么是缺失值?

缺失值(通常在 pandas 中表示为 NaN(非数字)或在数据库中表示为 NULL)本质上是数据集中的漏洞。它们是电子表格中的空单元格、调查回复中的空白、逃脱的数据点。在数据世界中,并非所有缺勤都是平等的,了解缺失值的性质对于决定如何处理缺失值至关重要。

图片由作者提供。

2.2 为什么会出现缺失值?

缺失值可能会由于各种原因潜入您的数据中。以下是一些常见原因:

- 数据输入错误: 有时,这只是人为错误。有人可能会忘记输入值或不小心删除一个值。

- 传感器故障:在 IoT 或科学实验中,有故障的传感器可能无法在某些时间记录数据。

- 调查未回答: 在调查中,受访者可能会跳过他们不愿意回答或不理解的问题。

- 合并的数据集:合并来自多个来源的数据时,某些条目在所有数据集中可能没有相应的值。

- 数据损坏:在数据传输或存储过程中,某些值可能会损坏并变得不可读。

- 故意遗漏:出于隐私问题或不相关,某些数据可能会被故意遗漏。

- 采样问题:数据收集方法可能会系统性地遗漏某些类型的数据。

- 时间敏感数据:在时间序列数据中,未收集数据的时间段(例如,周末、节假日)可能会缺少值。

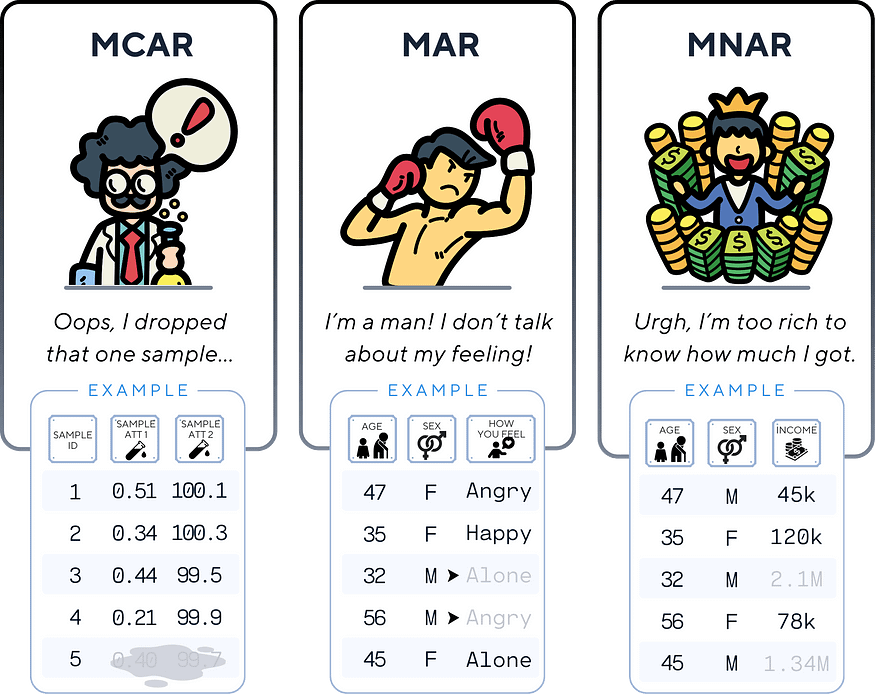

2.3 缺失数据类型

了解您正在处理的缺失数据类型可以帮助您选择最合适的插补方法。统计学家通常将缺失数据分为三种类型:

- 完全随机缺失 (MCAR):缺失是完全随机的,不依赖于任何其他变量。例如,如果实验室样品被意外掉落。

- 随机缺失 (MAR):缺失数据的概率取决于其他观测变量,但不取决于缺失数据本身。例如,男性在调查中可能不太可能回答有关情绪的问题。

- 非随机缺失 (MNAR):缺失取决于缺失数据本身的值。例如,高收入者可能不太可能在调查中报告他们的收入。

2.4 为什么要关注缺失值?

缺失值会显著影响您的分析:

- 如果处理不当,它们可能会引入偏差。

- 许多机器学习算法无法开箱即用地处理缺失值。

- 如果简单地丢弃具有缺失值的实例,则它们可能会导致重要信息丢失。

- 缺失值处理不当可能会导致错误的结论或预测。

这就是为什么有一个可靠的策略来处理缺失值至关重要的原因。而这正是我们将在本文中探讨的内容!

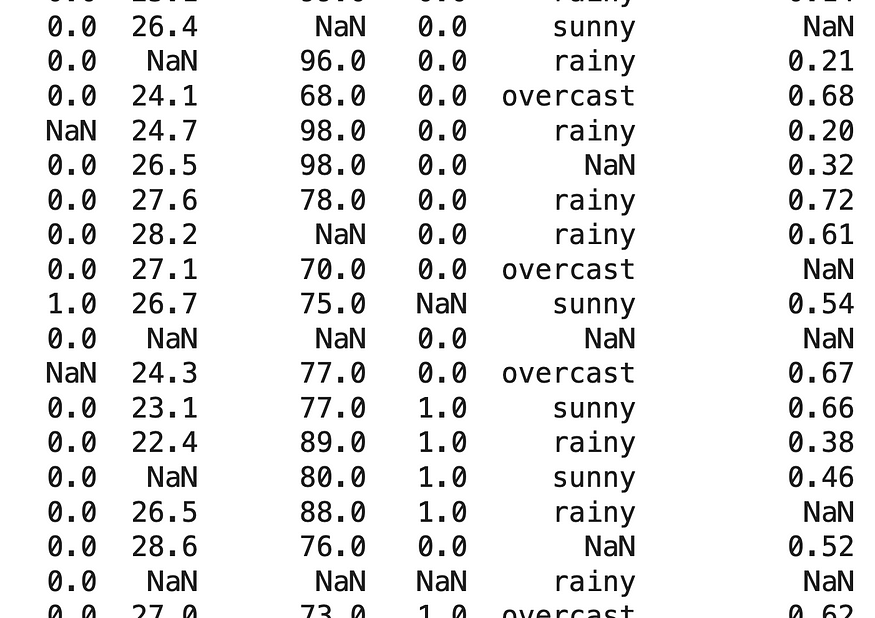

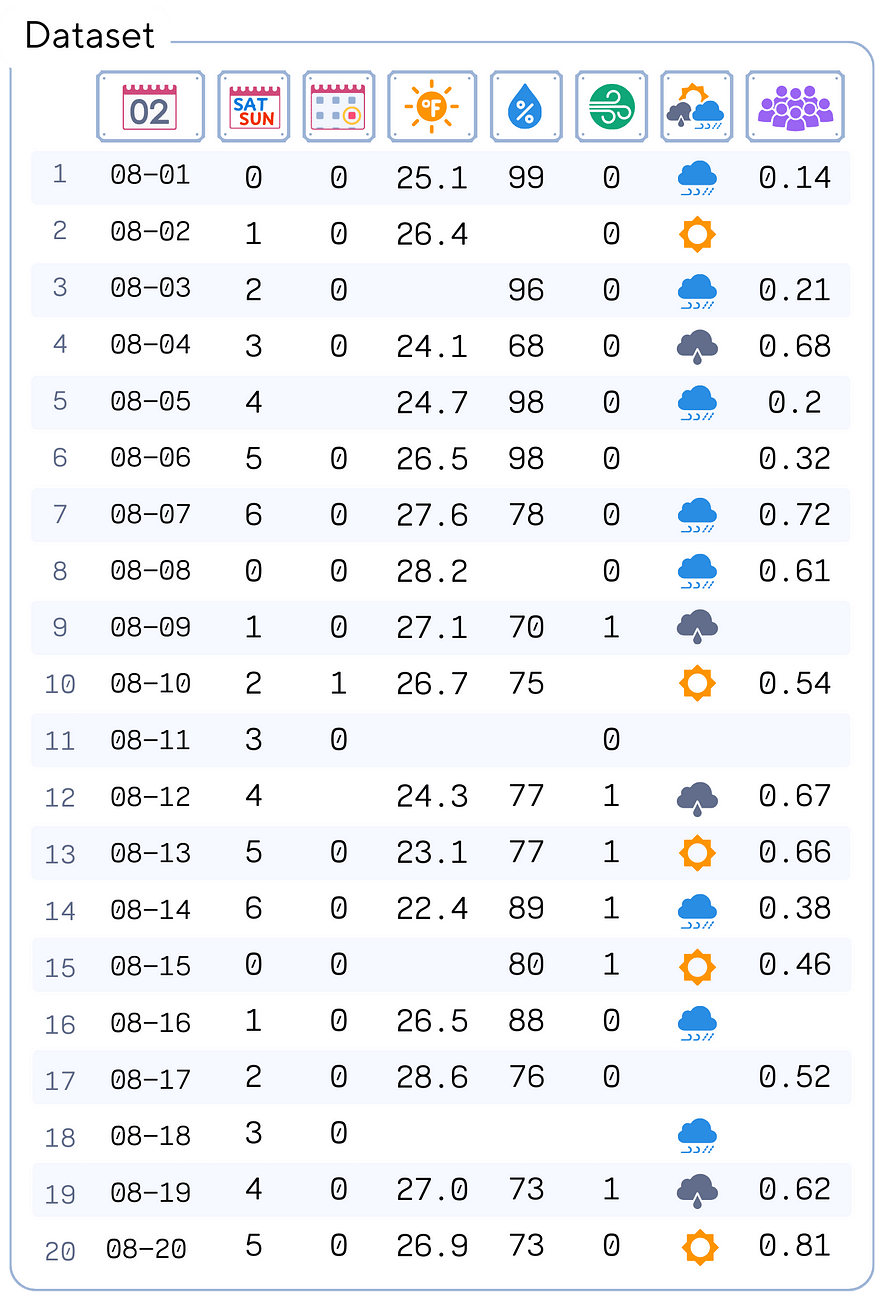

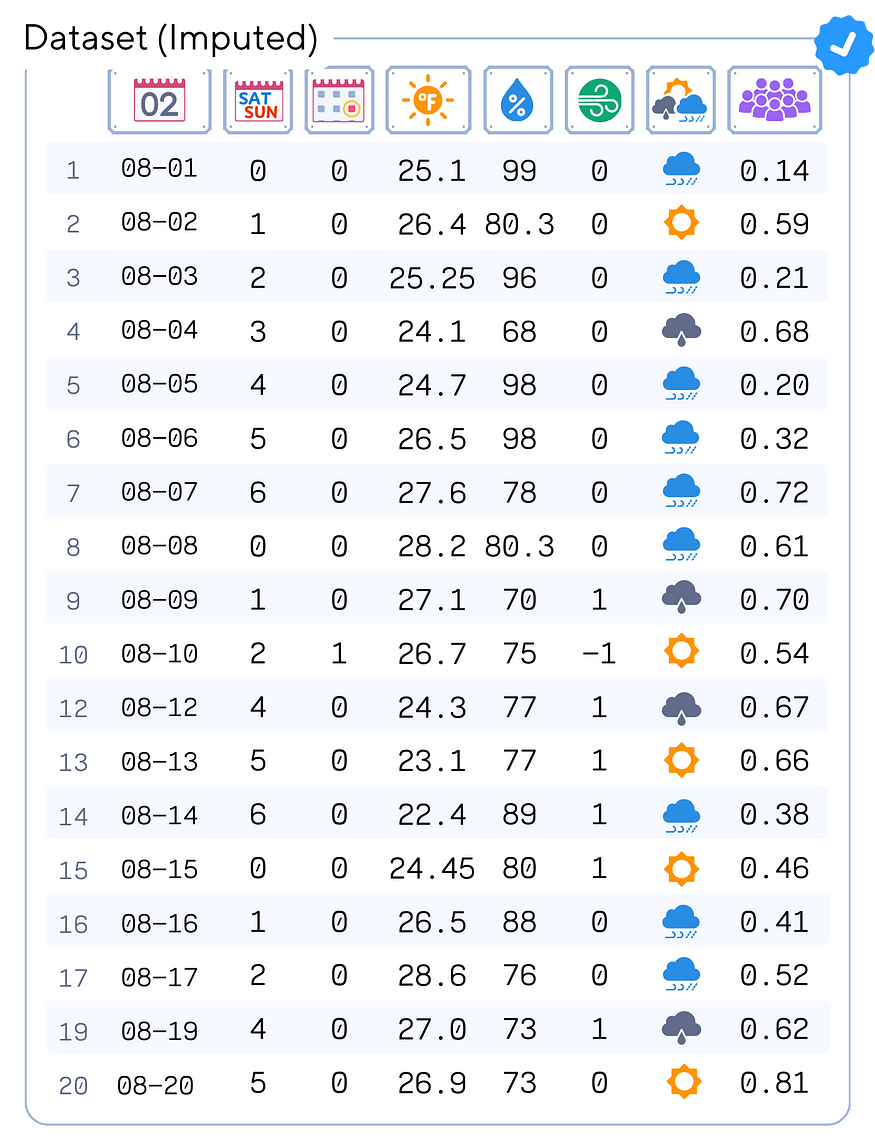

三、数据集

首先,让我们介绍我们的数据集。我们将使用一个高尔夫球场数据集,该数据集跟踪影响球场拥挤程度的各种因素。这个数据集什么都有 — 数值数据、分类数据,是的,还有大量的缺失值。

这个数据集是作者人工制作的(受 [1] 的启发),以促进学习。

import pandas as pd

import numpy as np# Create the dataset as a dictionary

data = {'Date': ['08-01', '08-02', '08-03', '08-04', '08-05', '08-06', '08-07', '08-08', '08-09', '08-10','08-11', '08-12', '08-13', '08-14', '08-15', '08-16', '08-17', '08-18', '08-19', '08-20'],'Weekday': [0, 1, 2, 3, 4, 5, 6, 0, 1, 2, 3, 4, 5, 6, 0, 1, 2, 3, 4, 5],'Holiday': [0.0, 0.0, 0.0, 0.0, np.nan, 0.0, 0.0, 0.0, 0.0, 1.0, 0.0, np.nan, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0],'Temp': [25.1, 26.4, np.nan, 24.1, 24.7, 26.5, 27.6, 28.2, 27.1, 26.7, np.nan, 24.3, 23.1, 22.4, np.nan, 26.5, 28.6, np.nan, 27.0, 26.9],'Humidity': [99.0, np.nan, 96.0, 68.0, 98.0, 98.0, 78.0, np.nan, 70.0, 75.0, np.nan, 77.0, 77.0, 89.0, 80.0, 88.0, 76.0, np.nan, 73.0, 73.0],'Wind': [0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, np.nan, 0.0, 0.0, 1.0, 1.0, 1.0, 1.0, 0.0, np.nan, 1.0, 0.0],'Outlook': ['rainy', 'sunny', 'rainy', 'overcast', 'rainy', np.nan, 'rainy', 'rainy', 'overcast', 'sunny', np.nan, 'overcast', 'sunny', 'rainy', 'sunny', 'rainy', np.nan, 'rainy', 'overcast', 'sunny'],'Crowdedness': [0.14, np.nan, 0.21, 0.68, 0.20, 0.32, 0.72, 0.61, np.nan, 0.54, np.nan, 0.67, 0.66, 0.38, 0.46, np.nan, 0.52, np.nan, 0.62, 0.81]

}# Create a DataFrame from the dictionary

df = pd.DataFrame(data)# Display basic information about the dataset

print(df.info())# Display the first few rows of the dataset

print(df.head())# Display the count of missing values in each column

print(df.isnull().sum())输出:

<class 'pandas.core.frame.DataFrame'>

RangeIndex: 20 entries, 0 to 19

Data columns (total 8 columns):# Column Non-Null Count Dtype

--- ------ -------------- ----- 0 Date 20 non-null object 1 Weekday 20 non-null int64 2 Holiday 19 non-null float643 Temp 16 non-null float644 Humidity 17 non-null float645 Wind 19 non-null float646 Outlook 17 non-null object 7 Crowdedness 15 non-null float64

dtypes: float64(5), int64(1), object(2)

memory usage: 1.3+ KBDate Weekday Holiday Temp Humidity Wind Outlook Crowdedness

0 08-01 0 0.0 25.1 99.0 0.0 rainy 0.14

1 08-02 1 0.0 26.4 NaN 0.0 sunny NaN

2 08-03 2 0.0 NaN 96.0 0.0 rainy 0.21

3 08-04 3 0.0 24.1 68.0 0.0 overcast 0.68

4 08-05 4 NaN 24.7 98.0 0.0 rainy 0.20Date 0

Weekday 0

Holiday 1

Temp 4

Humidity 3

Wind 1

Outlook 3

Crowdedness 5

dtype: int64正如我们所看到的,我们的数据集包含 20 行和 8 列:

- 日期:观察的日期

- 工作日:星期几(0-6,其中 0 是星期一)

- 假日:布尔值,指示是否为假日(0 或 1)

- 温度:以摄氏度为单位的温度

- 湿度:湿度百分比

- 风:风况(0 或 1,可能表示平静或有风)

- Outlook:天气展望(晴天、阴天或雨天)

- 拥挤程度:球场入住率

看看那个!除了 Date 和 Weekday 之外,每一列中都有缺失值。非常适合我们的归属派对。

四、缺失数据的插值方式

现在我们已经加载了数据集,让我们用六种不同的插补方法处理这些缺失值。我们将对每种类型的数据使用不同的策略。

4.1 方法 1:List-wise Deletion

按列表删除(也称为完整事例分析)涉及删除包含任何缺失值的整行。此方法很简单,可以保留数据的分布,但如果许多行包含缺失值,则可能会导致大量信息丢失。

👍 常见用途:当缺失值的数量较少且数据完全随机缺失 (MCAR) 时,通常使用列表删除。当您需要一个完整的数据集来用于某些无法处理缺失值的分析时,它也很有用。

在我们的例子中:我们对至少有 4 个缺失值的行使用列表删除。这些行可能无法提供足够可靠的信息,删除它们可以帮助我们专注于更完整的数据点。但是,我们保持谨慎,仅删除具有大量缺失数据的行,以保留尽可能多的信息。

# Count missing values in each row

missing_count = df.isnull().sum(axis=1)# Keep only rows with less than 4 missing values

df_clean = df[missing_count < 4].copy()我们删除了 2 行,这些行的缺失值过多。现在,让我们继续插补剩余的缺失数据。

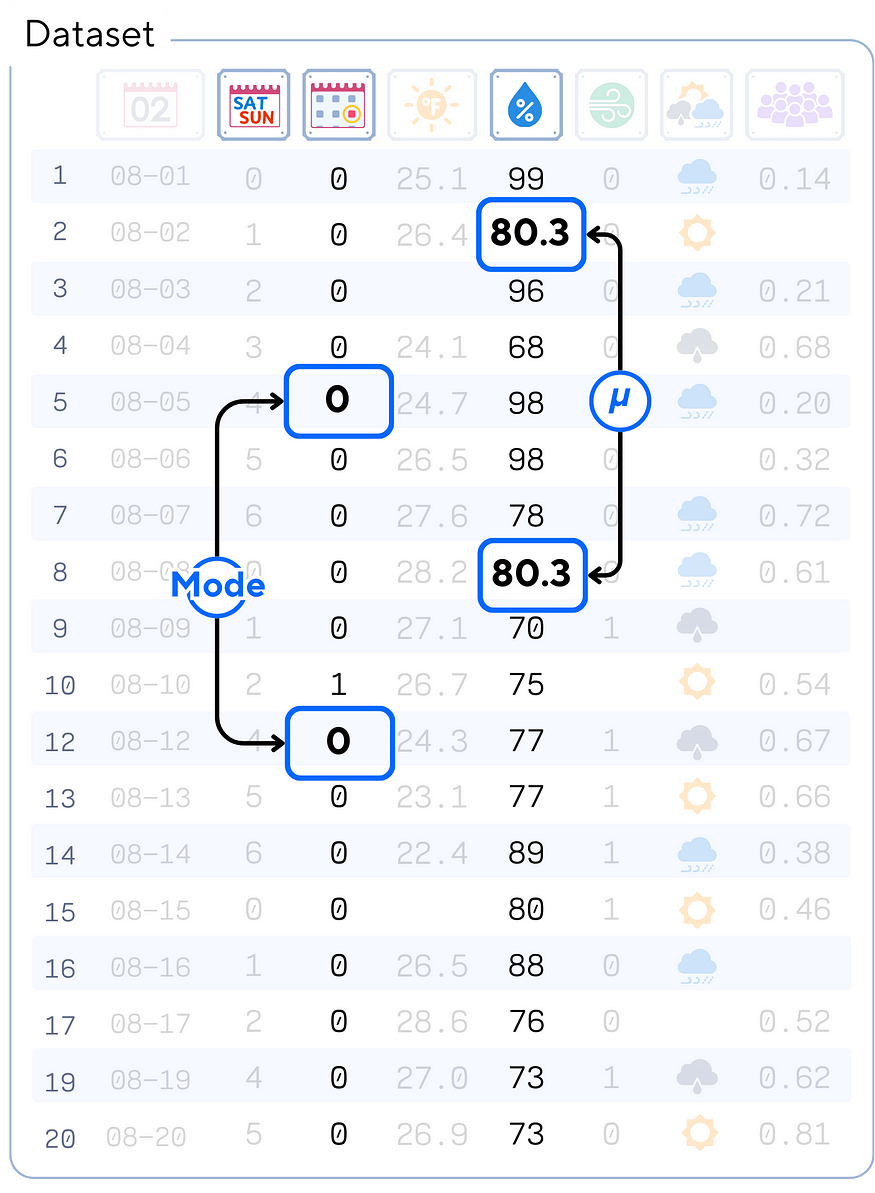

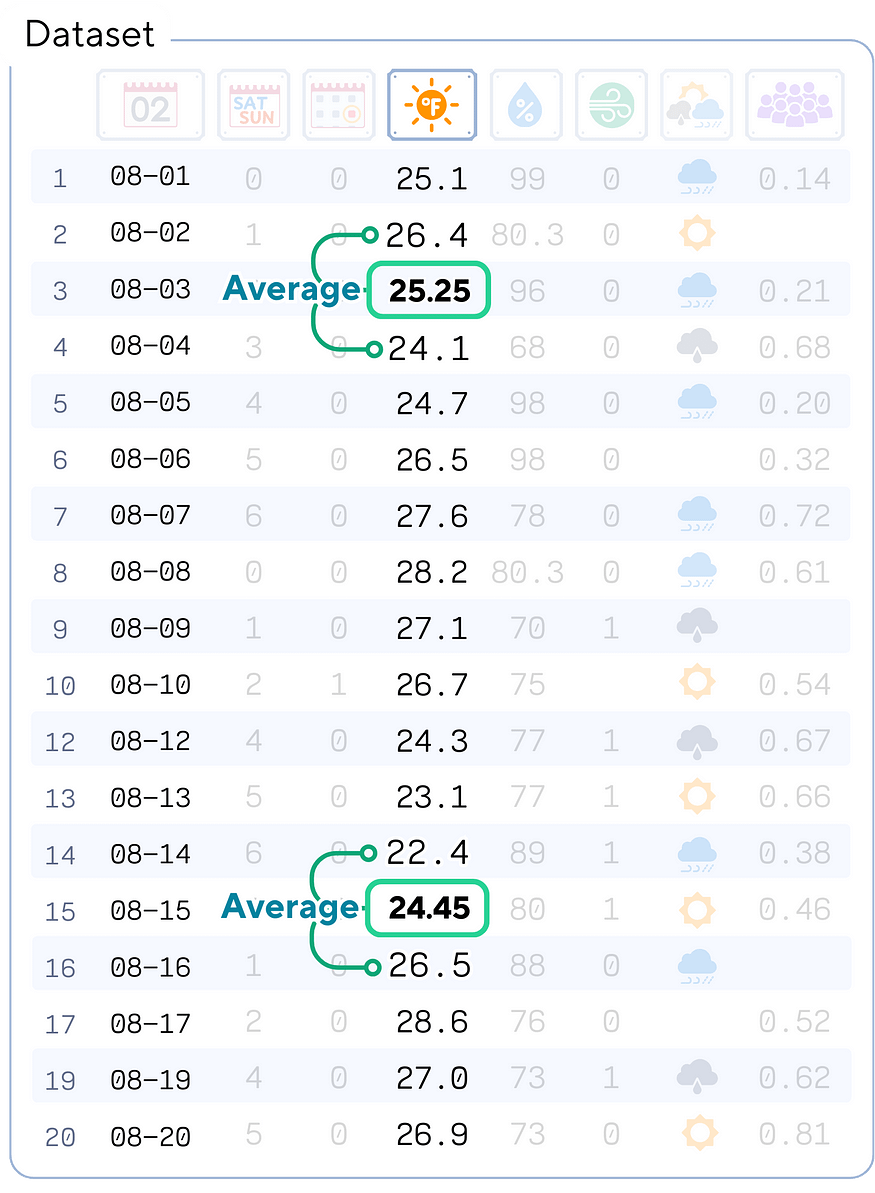

4.2 方法 2:简单插补 — 均值和众数

简单插补涉及将缺失值替换为观测值的汇总统计量。常见方法包括使用列中非缺失值的平均值、中位数或众数。

👍 常见用途:均值插补通常用于数据随机缺失且分布大致对称的连续变量。模式插补通常用于分类变量。

在我们的例子中:我们对 Humidity 使用均值插补,对 Holiday 使用模式插补。对于 Humidity (湿度),假设缺失值是随机的,则平均值提供典型湿度的合理估计值。对于 Holiday,由于它是一个二进制变量(无论是否为 holiday),该模式为我们提供了最常见的状态,这是对缺失值的合理猜测。

# Mean imputation for Humidity

df_clean['Humidity'] = df_clean['Humidity'].fillna(df_clean['Humidity'].mean())# Mode imputation for Holiday

df_clean['Holiday'] = df_clean['Holiday'].fillna(df_clean['Holiday'].mode()[0])4.3 方法 3:线性插值

线性插值通过假设已知数据点之间的线性关系来估计缺失值。它对于时间序列数据或具有自然排序的数据特别有用。

👍 常见用途:线性插值通常用于时间序列数据,其中可以根据缺失值之前和之后的值来估计缺失值。对于预期相邻点之间存在大致线性关系的任何数据,它也很有用。

在我们的例子中:我们对 Temperature 使用线性插值。由于温度往往会随着时间的推移而逐渐变化,并且我们的数据是按日期排序的,因此线性插值可以根据附近日期记录的温度为缺失的温度值提供合理的估计值。

df_clean['Temp'] = df_clean['Temp'].interpolate(method='linear')4.4 方法 4:向前/向后填充

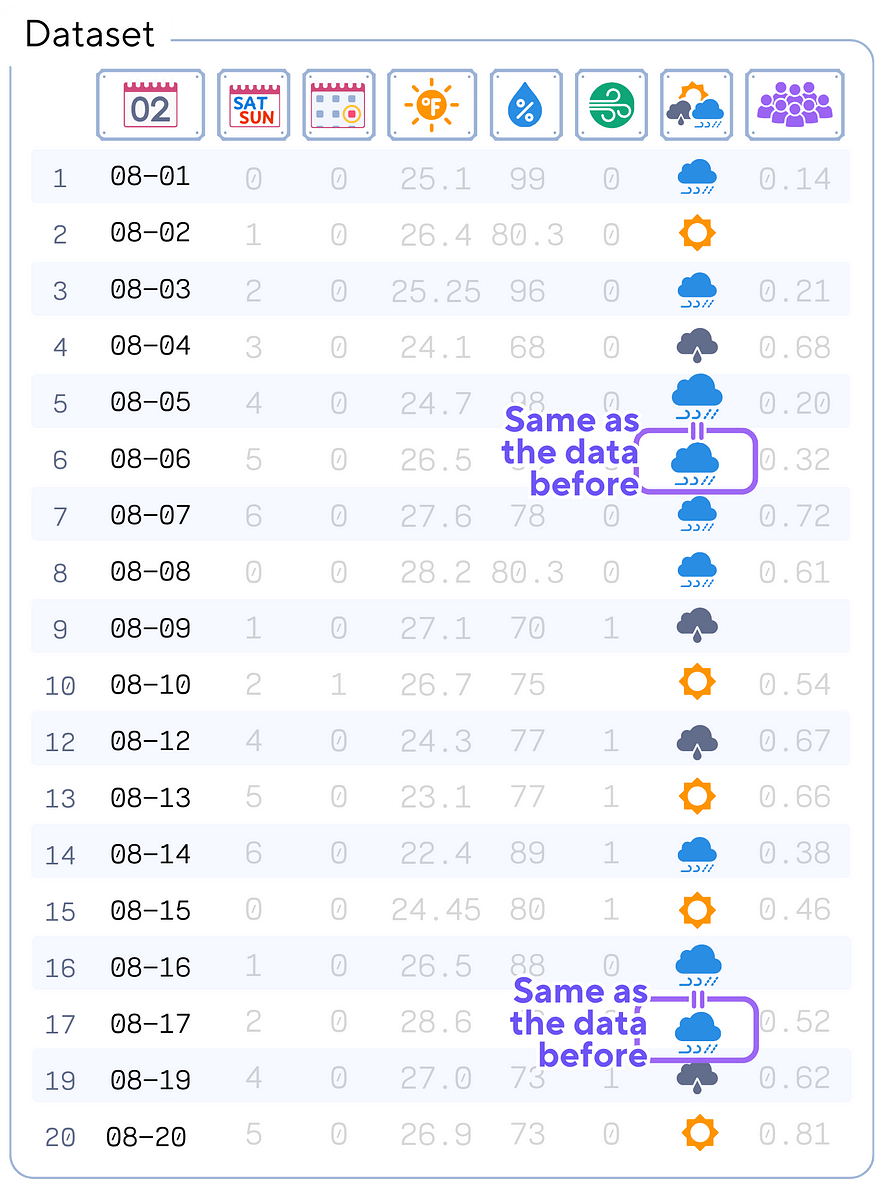

正向填充(或“结转最后一个观测值”)将最后一个已知值向前传播以填充空白,而向后填充则相反。此方法假定缺失值可能与最接近的已知值相似。

常见用途:前向/后向填充通常用于时间序列数据,尤其是当值可能保持不变直到更改时(如在财务数据中),或者当最近的已知值是当前状态的最佳猜测时。

在我们的例子中:我们对 Outlook 使用了向前填充和向后填充的组合。天气状况通常会持续数天,因此可以合理地假设缺失的 Outlook 值可能与前一天或第二天的 Outlook 相似。

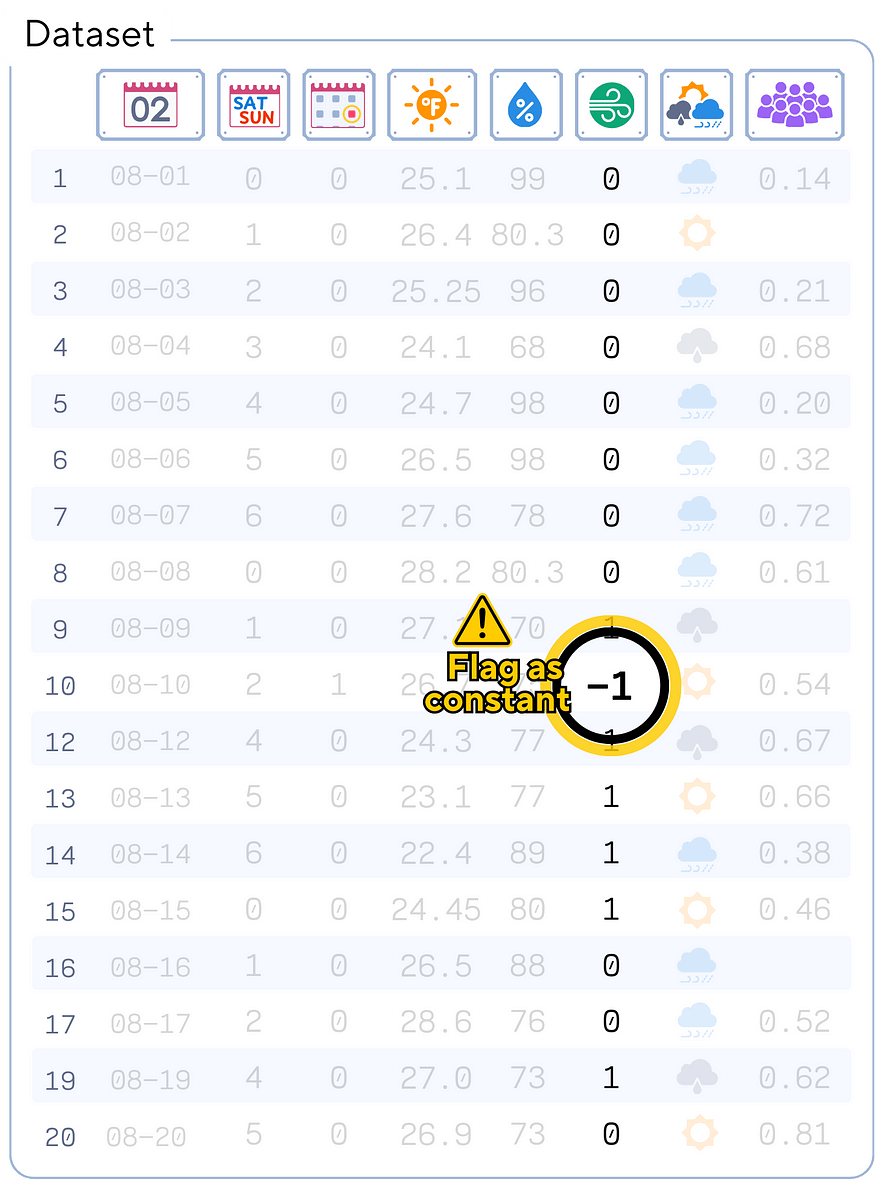

df_clean['Outlook'] = df_clean['Outlook'].fillna(method='ffill').fillna(method='bfill')4.5 方法 5:常数值插补

此方法涉及将变量中的所有缺失值替换为特定的常量值。可以根据域知识或安全的默认值来选择此常量。

👍 常见用途:当缺失数据存在逻辑默认值时,或者当您想要显式标记某个值缺失时(通过使用超出数据正常范围的值),通常会使用常量值插补。

在我们的例子中:我们对 Wind 列使用常量值插补,将缺失值替换为 -1。此方法显式标记插补值(因为 -1 超出 Wind 的正常 0-1 范围),并保留这些值最初缺失的信息。

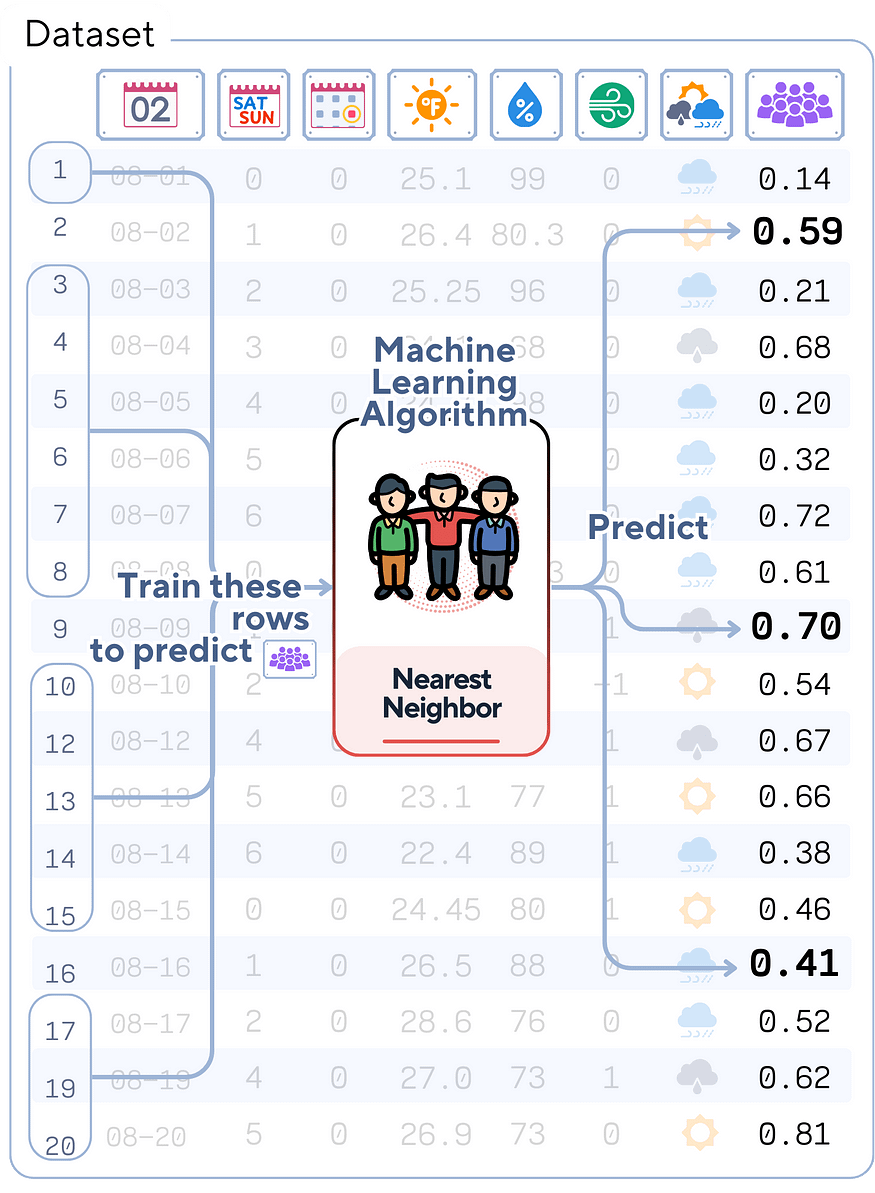

df_clean['Wind'] = df_clean['Wind'].fillna(-1)4.6 方法 6:KNN 插补

K 最近邻 (KNN) 插补通过查找数据集中 K 个最相似的样本(就像作为分类算法的 KNN)并使用它们的值来插补缺失数据来估计缺失值。此方法可以捕获变量之间的复杂关系。

👍 常用:KNN 插补用途广泛,可用于连续变量和分类变量。当预期变量之间存在复杂的关系而简单的方法可能会遗漏时,它特别有用。

在我们的例子中:我们对 Crowdedness 使用 KNN 插补。拥挤程度可能取决于多种因素(如温度、假期状态等)的组合,KNN 可以捕获这些复杂的关系,以提供更准确的缺失拥挤度值估计值。

from sklearn.impute import KNNImputer# One-hot encode the 'Outlook' column

outlook_encoded = pd.get_dummies(df_clean['Outlook'], prefix='Outlook')# Prepare features for KNN imputation

features_for_knn = ['Weekday', 'Holiday', 'Temp', 'Humidity', 'Wind']

knn_features = pd.concat([df_clean[features_for_knn], outlook_encoded], axis=1)# Apply KNN imputation

knn_imputer = KNNImputer(n_neighbors=3)

df_imputed = pd.DataFrame(knn_imputer.fit_transform(pd.concat([knn_features, df_clean[['Crowdedness']]], axis=1)),columns=list(knn_features.columns) + ['Crowdedness'])# Update the original dataframe with the imputed Crowdedness values

df_clean['Crowdedness'] = df_imputed['Crowdedness']五、结论:选择(和知识)的力量

所以,你有它!处理缺失值的六种不同方法,均适用于我们的高尔夫球场数据集。

现在,所有缺失值都已填充!

让我们回顾一下每种方法如何处理我们的数据:

- Listwise Deletion:通过删除具有大量缺失值的行,帮助我们专注于更完整的数据点。

- 简单插补:用平均值填充 Humidity,用最常见的值填充 Holiday。

- Linear Interpolation:根据周围天数的趋势估计的缺失 Temperature 值。

- 向前/向后填充:猜测相邻日期的缺失 Outlook 值,反映天气模式的持续存在。

- 常量值插补:用 -1 标记缺失的 Wind 数据,保留这些值最初未知的事实。

- KNN 插补:基于相似日期的估计拥挤度,捕获变量之间的复杂关系。

每种方法都讲述了我们缺失数据的不同故事,“正确”的选择取决于我们对高尔夫球场运营的了解以及我们试图回答的问题。

关键要点?不要盲目地应用插补方法。了解您的数据,考虑上下文,并选择最适合您的具体情况的方法。

5.1 警告:缺失值插补的目的和限制

虽然我们已经探索了各种插补技术,但我们需要了解它们的目的和局限性:

- 不是神奇的解决方案:插补并不是解决缺失数据的万灵药。它是一种使数据可用的工具,而不是创建完美的数据。

- 可能存在偏差:插补值是有根据的猜测。如果不小心操作,它们可能会引入偏差,尤其是在数据为随机非缺失 (NMAR) 的情况下。

- 不确定性损失:大多数简单的插补方法没有考虑缺失值中的不确定性,这可能导致模型过于自信。

- 数据扭曲:激进的插补可能会扭曲数据中的关系。始终检查插补是否显著改变了数据的分布或相关性。

- 记录您的过程:始终清楚地记录您的插补方法。这种透明度对于可重复性和其他人了解结果中的潜在偏差至关重要。

同样,插补的目标是使您的数据可用,同时最大限度地减少偏差和信息丢失。这不是关于创建完美的数据,而是关于充分利用您拥有的信息。始终以谨慎和批判性思维进行插补。

5.2 缺失值插补汇总

import pandas as pd

import numpy as np

from sklearn.impute import KNNImputer# Create the dataset as a dictionary

data = {'Date': ['08-01', '08-02', '08-03', '08-04', '08-05', '08-06', '08-07', '08-08', '08-09', '08-10','08-11', '08-12', '08-13', '08-14', '08-15', '08-16', '08-17', '08-18', '08-19', '08-20'],'Weekday': [0, 1, 2, 3, 4, 5, 6, 0, 1, 2, 3, 4, 5, 6, 0, 1, 2, 3, 4, 5],'Holiday': [0.0, 0.0, 0.0, 0.0, np.nan, 0.0, 0.0, 0.0, 0.0, 1.0, 0.0, np.nan, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0],'Temp': [25.1, 26.4, np.nan, 24.1, 24.7, 26.5, 27.6, 28.2, 27.1, 26.7, np.nan, 24.3, 23.1, 22.4, np.nan, 26.5, 28.6, np.nan, 27.0, 26.9],'Humidity': [99.0, np.nan, 96.0, 68.0, 98.0, 98.0, 78.0, np.nan, 70.0, 75.0, np.nan, 77.0, 77.0, 89.0, 80.0, 88.0, 76.0, np.nan, 73.0, 73.0],'Wind': [0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, 0.0, np.nan, 0.0, 0.0, 1.0, 1.0, 1.0, 1.0, 0.0, np.nan, 1.0, 0.0],'Outlook': ['rainy', 'sunny', 'rainy', 'overcast', 'rainy', np.nan, 'rainy', 'rainy', 'overcast', 'sunny', np.nan, 'overcast', 'sunny', 'rainy', 'sunny', 'rainy', np.nan, 'rainy', 'overcast', 'sunny'],'Crowdedness': [0.14, np.nan, 0.21, 0.68, 0.20, 0.32, 0.72, 0.61, np.nan, 0.54, np.nan, 0.67, 0.66, 0.38, 0.46, np.nan, 0.52, np.nan, 0.62, 0.81]

}# Create a DataFrame from the dictionary

df = pd.DataFrame(data)# 1. Listwise Deletion

df_clean = df[df.isnull().sum(axis=1) < 4].reset_index(drop=True).copy()# 2. Simple Imputation

df_clean['Humidity'] = df_clean['Humidity'].fillna(df_clean['Humidity'].mean())

df_clean['Holiday'] = df_clean['Holiday'].fillna(df_clean['Holiday'].mode()[0])# 3. Linear Interpolation

df_clean['Temp'] = df_clean['Temp'].interpolate(method='linear')# 4. Forward/Backward Fill

df_clean['Outlook'] = df_clean['Outlook'].ffill()# 5. Constant Value Imputation

df_clean['Wind'] = df_clean['Wind'].fillna(-1)# 6. KNN Imputation

# One-hot encode the 'Outlook' column

outlook_encoded = pd.get_dummies(df_clean['Outlook'], prefix='Outlook')# Prepare features for KNN imputation

features_for_knn = ['Weekday', 'Holiday', 'Temp', 'Humidity', 'Wind']

knn_features = pd.concat([df_clean[features_for_knn], outlook_encoded], axis=1)# Apply KNN imputation

knn_imputer = KNNImputer(n_neighbors=3)

df_imputed = pd.DataFrame(knn_imputer.fit_transform(pd.concat([knn_features, df_clean[['Crowdedness']]], axis=1)),columns=list(knn_features.columns) + ['Crowdedness'])# Update the original dataframe with the imputed Crowdedness values

df_clean['Crowdedness'] = df_imputed['Crowdedness'].round(2)print("Before:")

print(df)print("\n\nAfter:")

print(df_clean)六、附属信息

6.1 延伸阅读

关于 KNNImputer 及其在 scikit-learn 中的实现的详细说明,读者可以参考官方文档 [2],其中提供了关于其用法和参数的全面信息。

6.2 技术环境

本文使用 Python 3.7 和 scikit-learn 1.5。虽然讨论的概念通常适用,但特定代码实现可能会因版本的不同而略有不同。

6.3 关于插图

除非另有说明,否则所有图片均由作者创建,并融合了 Canva Pro 的许可设计元素。

这篇关于缺失值插补解释:六种插补方法?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!