本文主要是介绍从工具产品体验对比spark、hadoop、flink,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

作为一名大数据开发,从工具产品的角度,对比一下大数据工具最常使用的框架spark、hadoop和flink。工具无关好坏,但人的喜欢有偏好。

目录

- 评价标准

- 1 效率

- 2 用户体验分析

- 从用户的维度来看

- 从市场的维度来看

- 从产品的维度来看

- 3 用户体验的基本原则

- 成本和产出是否成正比

- 操作是否“人性化”

- 4. 功能性与用户体验评估

- 总而言之

- 大数据框架评估

- 用户视角

- 效率

- 示例代码

- Spark:计算Pi的近似值

- Flink:实时流处理示例

- 易用性

- 示例代码

- Hadoop:简单的WordCount程序

- 容错性

- 市场视角

- 适应性和现代特性

- 竞争优势

- 用户群体

- 产品视角

- 维护和支持

- 用户支持和文档

- 一致性和愿景

- 总结

评价标准

1 效率

- 明确目标:用户使用工具类产品是有明确的目标的。比如,美图产品需要帮助用户迅速进行美图。

- 简化操作:简化操作能够扩大用户数量,提升效率,提升用户满意度。操作困难重重的工具类产品注定会被替代。

- 容错性:使用工具有用错的可能,出错情况少、容错性高的工具让用户用起来更放心,更安心。

2 用户体验分析

- 用户群体(我是谁?)

- 解决场景下的痛点(我在哪里?)

- 解决痛点的形式(我在干什么?)

- 交互体验(UI感受)

- 行业优劣(竞品分析)

工具产品的共同道理,不管是什么形式的工具,其道理都是类似的:

从用户的维度来看

- 价值提供:工具是否能提供应该提供的价值,解决用户需求,完成用户的本质目标?

- 使用舒适度:用户在使用过程中是否感觉很舒服、容易?

- 目标促进:工具是否能吸引用户或促进用户完成目标?

- 易触达:工具是否易于触达?能否正常运行/使用?

从市场的维度来看

- 与时俱进:工具是否能与时俱进,比如设计风格、功能布局等?

- 功能对比:其他产品的功能是否更多更好?

- 用户量:工具的用户量是否最多?

从产品的维度来看

- 持续维护:工具是否会继续维护?

- 疑问解决:对工具有疑问时,是否有人及时解决?

- 定位不变:工具是否坚持自己的定位不变?

3 用户体验的基本原则

- 一看就用:好的用户体验,一看就能使用。

- 提高效率:提高用户效率,用完就走。

- 节省成本:节省成本,再次使用还会回来。

具体来说

成本和产出是否成正比

- 作为工具,若使用成本大于产出成本,那么宁可不使用工具。使用成本包括:上手成本、时间成本、工具成本,缺一不可,任何一环都需要考虑并进行衡量。

操作是否“人性化”

- 工具讲究易用性和效率,简单的使用界面和流程会使工具容易被接受(不包括军事或其他高级领域,只讨论2C)。

4. 功能性与用户体验评估

- 功能性:用户的需求是否满足,即客户要求的功能是否全部实现。

- 易用性:对新手用户来说,软件是否友好、方便,功能操作不需要用户花太多时间去学习或理解。

- 高效率性:软件的性能,在指定条件下实现功能所需的计算机资源的有效程度。效率反映了在完成功能要求时有没有浪费资源。资源包括内存、外存、通道能力及处理时间。

- 可靠性:在规定时间和条件下,软件维持其性能水平的程度。可靠性对某些软件是重要的质量要求,反映了软件在故障发生时能继续运行的程度。

- 可维护性:软件在研发时需求变更时进行相应修改的容易程度,以及上市后的运行维护的方便性。易于维护的软件系统也是易理解、易测试和易修改的,以便纠正或增加新功能,或允许在不同软件环境上操作。

- 可移植性:从一个环境转移到另一个环境的容易程度。

总而言之

“好不好用”圈定了讨论范围要围绕功能。从用户体验要素上来说,用户在进入产品之前有一个核心任务:

- 范围层:在产品内是否能使用户完成自己的任务?

- 结构层:用户完成任务的流程是否流畅?

- 框架层:用户是否能清晰地找到完成任务的入口?

- 表现层:任务完成各阶段的提示、反馈是否明确、有意义?

大数据框架评估

用户视角

效率

- Apache Hadoop:适用于处理大规模数据集,但设置和管理复杂,可能降低新用户的效率。

- Apache Spark:提供内存中处理,大大提升性能和速度,非常适合迭代算法和实时数据处理。

- Apache Flink:在实时流处理方面表现出色,提供高效的低延迟处理。

示例代码

Spark:计算Pi的近似值

from pyspark import SparkContext

import randomsc = SparkContext("local", "Pi Approximation")def inside(p):x, y = random.random(), random.random()return x*x + y*y < 1num_samples = 1000000

count = sc.parallelize(range(0, num_samples)).filter(inside).count()

pi = 4 * count / num_samples

print("Pi is roughly %f" % pi)

Flink:实时流处理示例

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.util.Collector;public class StreamingJob {public static void main(String[] args) throws Exception {final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();DataStream<String> text = env.socketTextStream("localhost", 9999);DataStream<Tuple2<String, Integer>> wordCounts = text.flatMap(new Tokenizer()).keyBy(value -> value.f0).sum(1);wordCounts.print();env.execute("Streaming WordCount");}public static final class Tokenizer implements FlatMapFunction<String, Tuple2<String, Integer>> {@Overridepublic void flatMap(String value, Collector<Tuple2<String, Integer>> out) {for (String word : value.split("\\s")) {out.collect(new Tuple2<>(word, 1));}}}

}

易用性

- Hadoop:学习曲线陡峭,需要管理其生态系统(HDFS, MapReduce, YARN),对初学者不太友好。

- Spark:提供丰富的API(Java, Scala, Python, R),集群管理更简便。

- Flink:同样提供丰富的API,设计上简化了流处理应用的开发。

用过hadoop再用spark的,应该再也不会用hadoop了

示例代码

Hadoop:简单的WordCount程序

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;import java.io.IOException;

import java.util.StringTokenizer;public class WordCount {public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable>{private final static IntWritable one = new IntWritable(1);private Text word = new Text();public void map(Object key, Text value, Context context) throws IOException, InterruptedException {StringTokenizer itr = new StringTokenizer(value.toString());while (itr.hasMoreTokens()) {word.set(itr.nextToken());context.write(word, one);}}}public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {private IntWritable result = new IntWritable();public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}public static void main(String[] args) throws Exception {Configuration conf = new Configuration();Job job = Job.getInstance(conf, "word count");job.setJarByClass(WordCount.class);job.setMapperClass(TokenizerMapper.class);job.setCombinerClass(IntSumReducer.class);job.setReducerClass(IntSumReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}

}

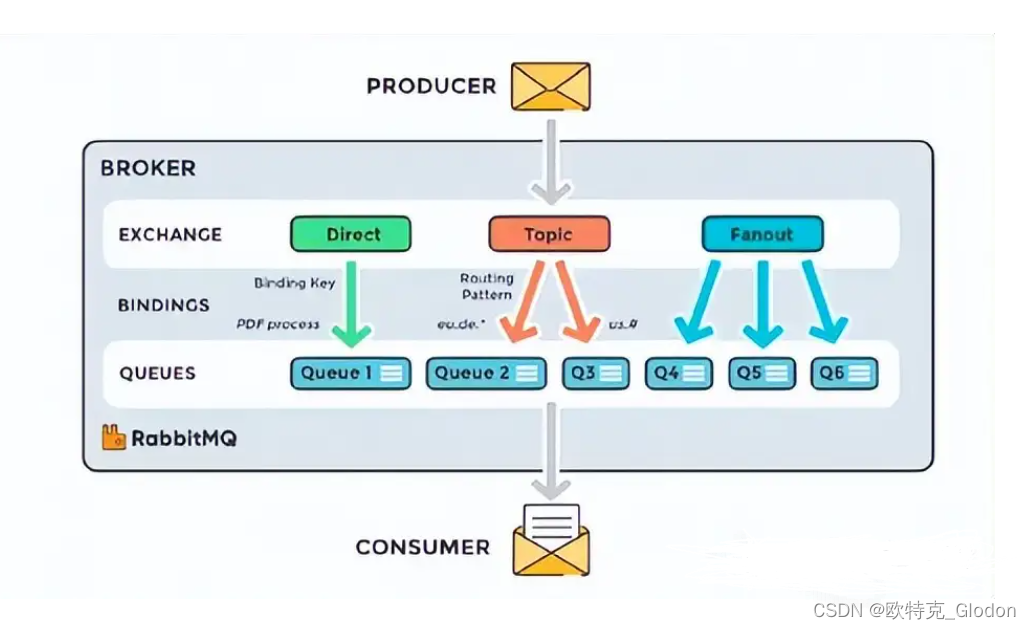

容错性

- Hadoop:具有良好的容错性,通过HDFS的容错存储和任务失败重执行机制实现。

- Spark:通过数据血统(lineage)和弹性分布式数据集(RDD)提供容错性。

- Flink:通过状态快照和细粒度恢复机制提供高级容错,确保流处理的稳健性。

市场视角

适应性和现代特性

- Hadoop:虽然仍在发展,但由于其批处理根源,被认为不如Spark和Flink现代。

- Spark:经常更新新特性,保持领先的大数据处理选择地位。

- Flink:因其实时处理能力和复杂事件处理支持迅速获得关注。

竞争优势

- Hadoop:虽然是基础性技术,但面临Spark和Flink等新框架的激烈竞争。

- Spark:凭借广泛采用、活跃社区和批处理与流处理的多功能性保持竞争优势。

- Flink:在实时分析领域竞争力强,吸引了对高吞吐量、低延迟处理有需求的用户。

用户群体

- Hadoop:广泛使用,但在许多组织中逐渐被Spark补充或替代。

- Spark:用户群体大且不断增长,尤其是在需要快速数据处理和机器学习能力的行业中。

- Flink:用户群体增长迅速,特别是在实时数据分析至关重要的行业中。

产品视角

维护和支持

- Hadoop:由强大的社区支持,并通过Cloudera和Hortonworks(现为Cloudera的一部分)等供应商提供企业支持。

- Spark:由Databricks(Spark的创建者)和庞大的开源社区支持,确保持续改进和支持。

- Flink:由Apache社区和Ververica等商业实体支持,提供企业支持和开发。

用户支持和文档

- Hadoop:有广泛的文档、教程和社区支持论坛。

- Spark:优秀的文档、众多教程和活跃的社区提供广泛支持。

- Flink:文档质量良好,社区支持不断增长,资源越来越多。

一致性和愿景

- Hadoop:在提供稳健、可扩展的存储和处理框架方面表现一致,但创新速度较慢。

- Spark:通过新特性和集成不断创新,保持统一的分析愿景。

- Flink:专注于实时流处理,保持清晰愿景并迅速演变以满足现代数据处理需求。

总结

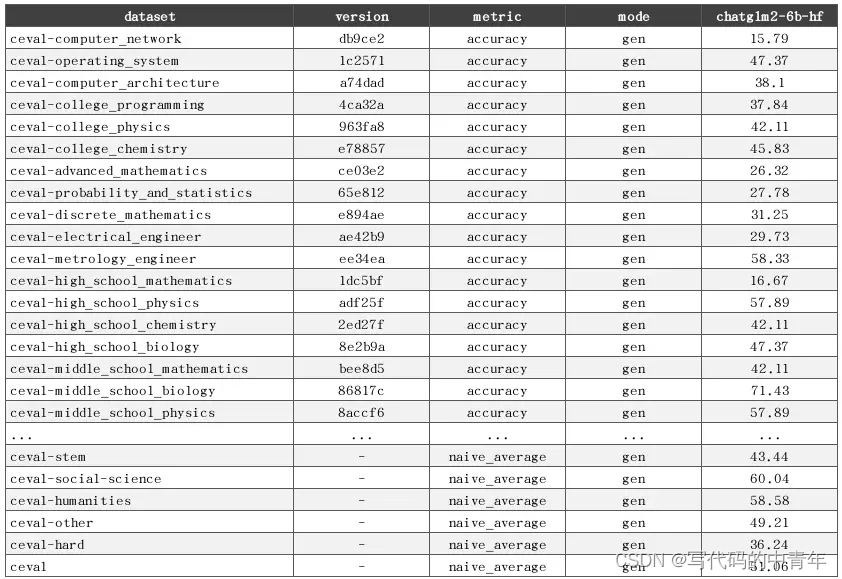

通过效率、易用性、容错性、适应性、竞争优势、用户群体、维护支持、一致性和愿景等多个维度评估大数据框架,可以全面了解其可用性。

- Apache Hadoop:最适合需要大规模批处理和强大管理能力的组织。

- Apache Spark:适用于需要高效数据处理和批处理与流处理多功能性的环境。

- Apache Flink:适合需要实时、低延迟处理和复杂事件处理能力的应用。

选择合适的框架取决于您的具体需求、现有基础设施和长期数据处理目标。每个框架都有其独特的优势,了解这些优势可以指导您为大数据项目做出明智的决策。

这篇关于从工具产品体验对比spark、hadoop、flink的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!