本文主要是介绍05|容器CPU(1):怎么限制容器的CPU使用?【request、limit】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

从这一将开始,我们进入容器CPU这个模块。

容器在Linux系统中最核心的两个概念是

Namespace和Cgroups。 通过Cgroups 技术限制资源,可以分为很多类型,比如CPU、Memory、Storage、Network等等。

今天说下如何限制容器的CPU 使用。

我们拿Kubernetes平台做例子,具体来看下面这个pod/container里的spec定义,在CPU资源相关的定义中有两项内容,分别是Request CPU和Limit CPU。

apiVersion: v1

kind: Pod

metadata:name: frontend

spec:containers:- name: appimage: images.my-company.example/app:v4env:resources:requests: #请求资源,cpu.sharesmemory: "64Mi"cpu: "1"limits: #限制资源,cpu.cfs_quota_usmemory: "128Mi"cpu: "2"

…

上面Pod Spec 里的 Request CPU和Limit CPU的值,最后会通过 CPU Cgroup 的配置,来实现控制容器CPU 资源的作用。

那接下来我会先从进程的CPU使用讲起,然后带你在CPU Cgoup子系统中建立几个控制组,用这个例子为你讲解 CPU Cgroup 中三个重要的参数:

- cpu.cfs_quota_us

- cpu.cfs_period_us

- cpu.shares

一、如何理解CPU使用和CPU Cgroup

CPU

Cgroup最大的作用就是限制CPU使用

1.1 CPU 使用的分类

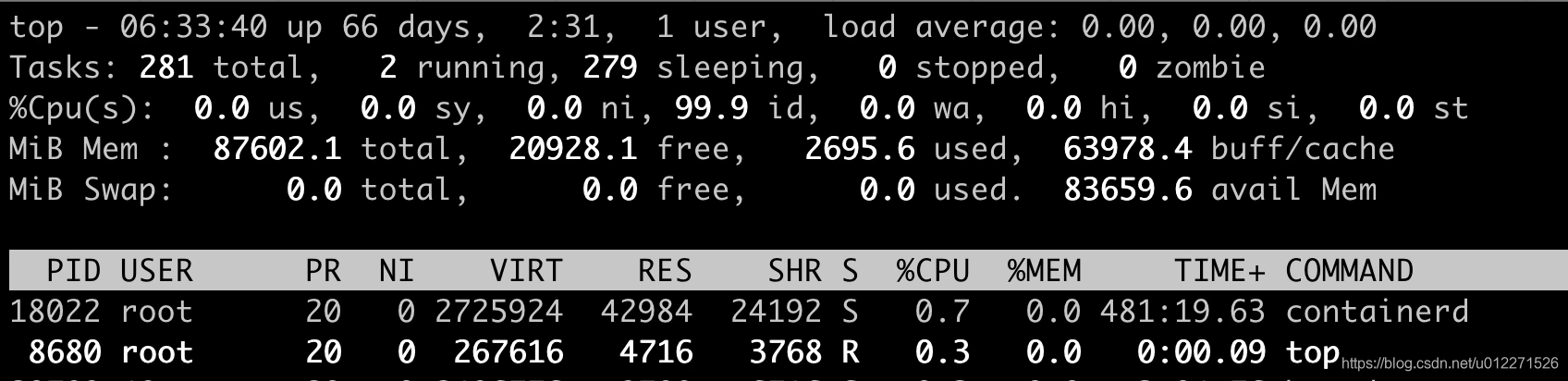

使用top命令,注意下图"%Cpu(s)"开头的这一行:

下面开始解释:  上图中的上半部分是

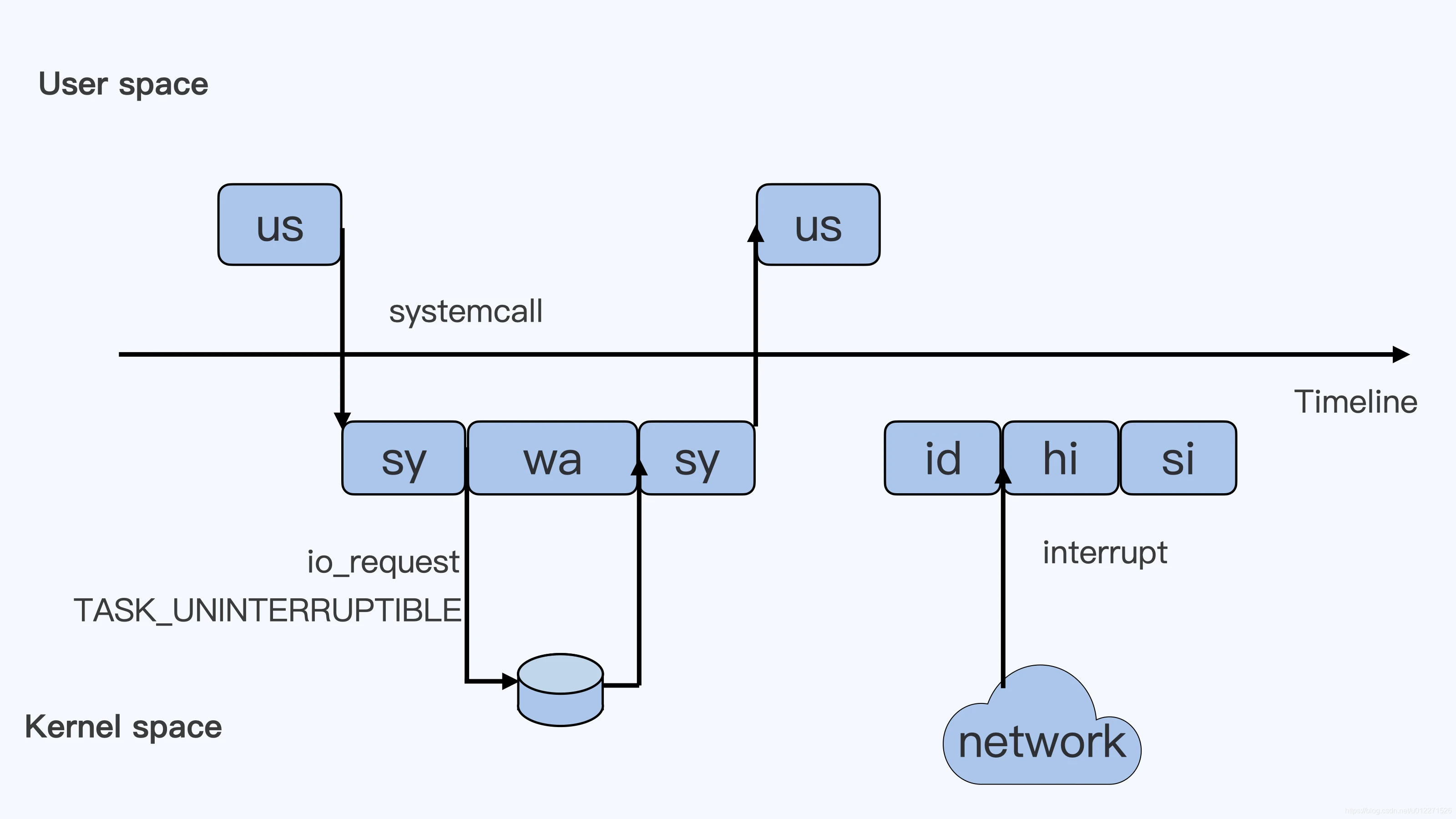

上图中的上半部分是用户态(user space)下半部分是内核态(kernel space),假设只有一个CPU。

【us】

当用户程序开始运行时,对应着第一个 ‘us’ 框,‘us’ 是 user 的缩写,代表 Linux 的用户态 CPU Usage,普通用户程序代码中,只要不是调用系统调用(System Call),这些代码指令消耗的CPU 都属于‘us’。

【sy】

当这个用户程序代码中调用了系统调用,比如说 read()去读取一个文件,这个时候用户进程就会从用户态切换到内核态。

内核态read()系统调用在读到真正 disk 上的文件前,就会进行一些文件系统层的操作,那么这些代码指令的消耗就属于‘sy’,这里就对应上面图中的第二个框 ’sy‘ 是 system的缩写,代表内核态CPU 使用。

【wa】

然后 read()系统调用会向Linux 的Block Layer 发出一个 I/O Request,触发一个真正的磁盘读取操作。

这个时候进程一般会被置为 TASK_UNINTERRUPTIBLE,Linux会把这段时间标示为 wa,对应图中第三个框,wa 是 iowait 的缩写,代表等待Disk I/O 的时间。

【sy】

当磁盘返回数据时,进程在内核态拿到数据,这里仍然是内核态的CPU 使用的"sy",也就是图中的第四个框。

【us】

然后进程再从内核态切换回用户态,在内核态得到文件数据,这里进程又回到用户态的使用 us,对应图中的第五个框。

【id】

假设到这,进程就没事做了,CPU上也没有其他的进程需要运行。 系统就会进入到 id 这个步骤,也就是第六个框,id是 idle 的缩写。 代表系统处于空闲状态。

【hi】

如果这个时候机器的网络收到一个网络数据包,网卡就会发出一个中断(interrupt),响应的,CPU 会中断响应,然后进入中断服务程序。

这时 CPU 就会进入hi ,hi 是 hardware irq 的缩写,代表 CPU 处理硬中断的开销,由于中断服务处理需要关闭中断,所以这个硬中断不能时间太长。

【si】

中断后的工作必须要完成的,如果这些工作比较耗时怎么办呢? Linux 中有一个软中断的概念(softirq) ,它可以完成这些耗时比较长的工作。

软中断:从网卡收到数据包的大部分工作,都是通过软中断来处理的。

CPU 会进入到第八个框,si, 这里的si 是softirq的缩写,代表CPU 处理软中断的开销。

hi,si本身处理的时候不属于任何一个进程,它们的CPU 时间都不会进入到进程的CPU 时间。

- PRI :进程优先权,代表这个进程可被执行的优先级,其

值越小,优先级就越高,越早被执行; - NI :进程

Nice值,代表这个进程的优先值; - %nice :改变过优先级的

进程的占用CPU的百分比;

PRI是比较好理解的,即进程的优先级,或者通俗点说就是程序被CPU执行的先后顺序,此值越小进程的优先级别越高。

【ni】

那NI呢?就是我们所要说的nice值了,其表示进程可被执行的优先级的修正数值。如前面所说,PRI值越小越快被执行,那么加入nice值后,将会使得PRI变为:PRI(new) = PRI(old) + nice。由此看出,PRI是根据NICE排序的,规则是NICE越小PR越前(小,优先权更大),即其优先级会变高,则其越快被执行。如果NICE相同则进程uid是root的优先权更大。

【st】

另外一个是st,st 是steal的缩写。是虚拟机里用的一个CPU 使用类型,表示有多少时间是被同一个宿主机上的其他虚拟机抢走的。

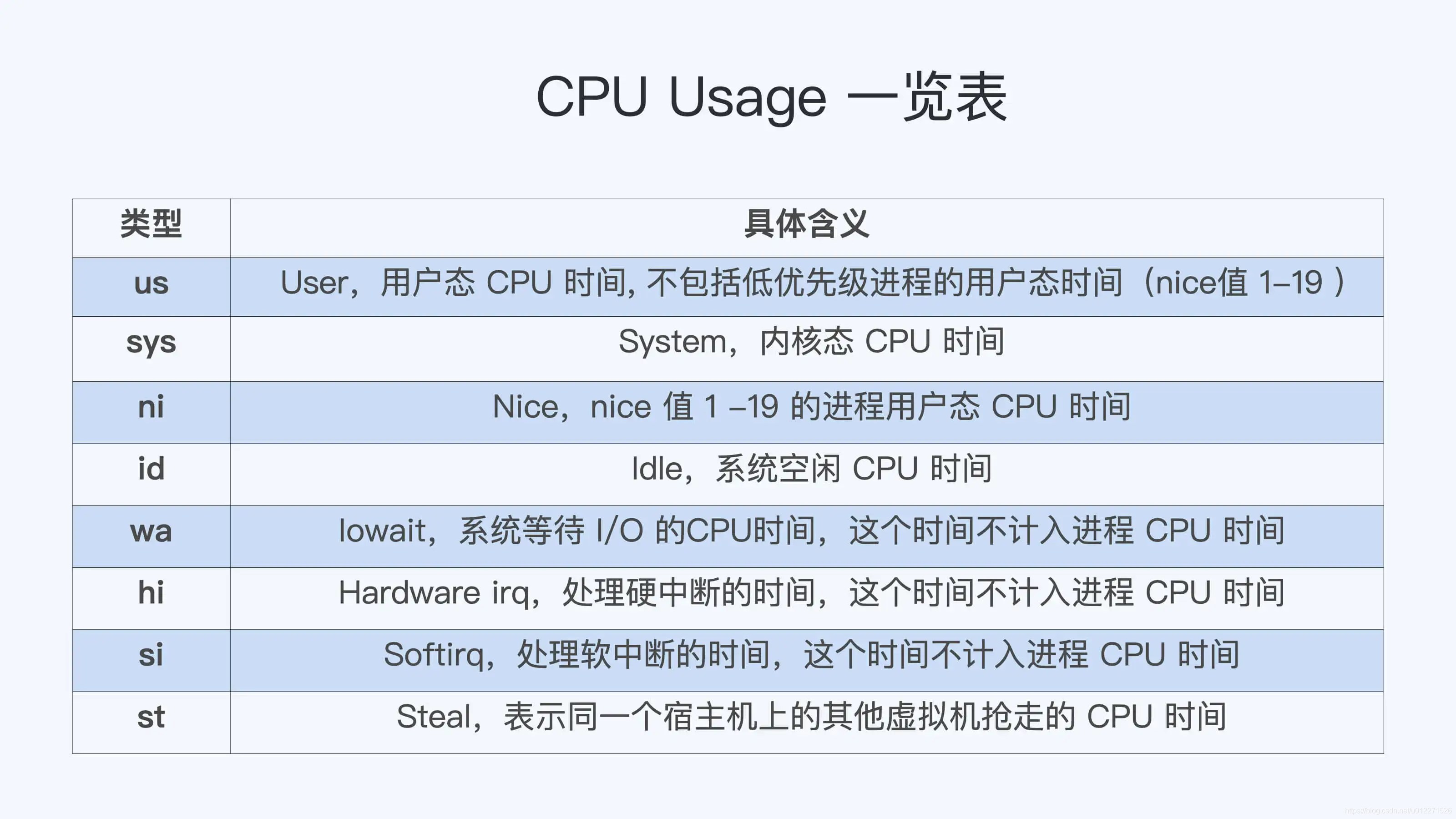

1.2 CPU Cgroup

Cgroups 是对指定进程做计算机资源限制的,CPU Cgroup 是Cgroups 其中的一个 Cgroups 子系统,它是用来限制进程的CPU 使用的。

cpu包括:

- 用户态:us 和 ni

- 内核态:sy

wa,hi,si 这些 I/O 或者中断相关的CPU 使用,CPU Cgroup 不会去做限制。

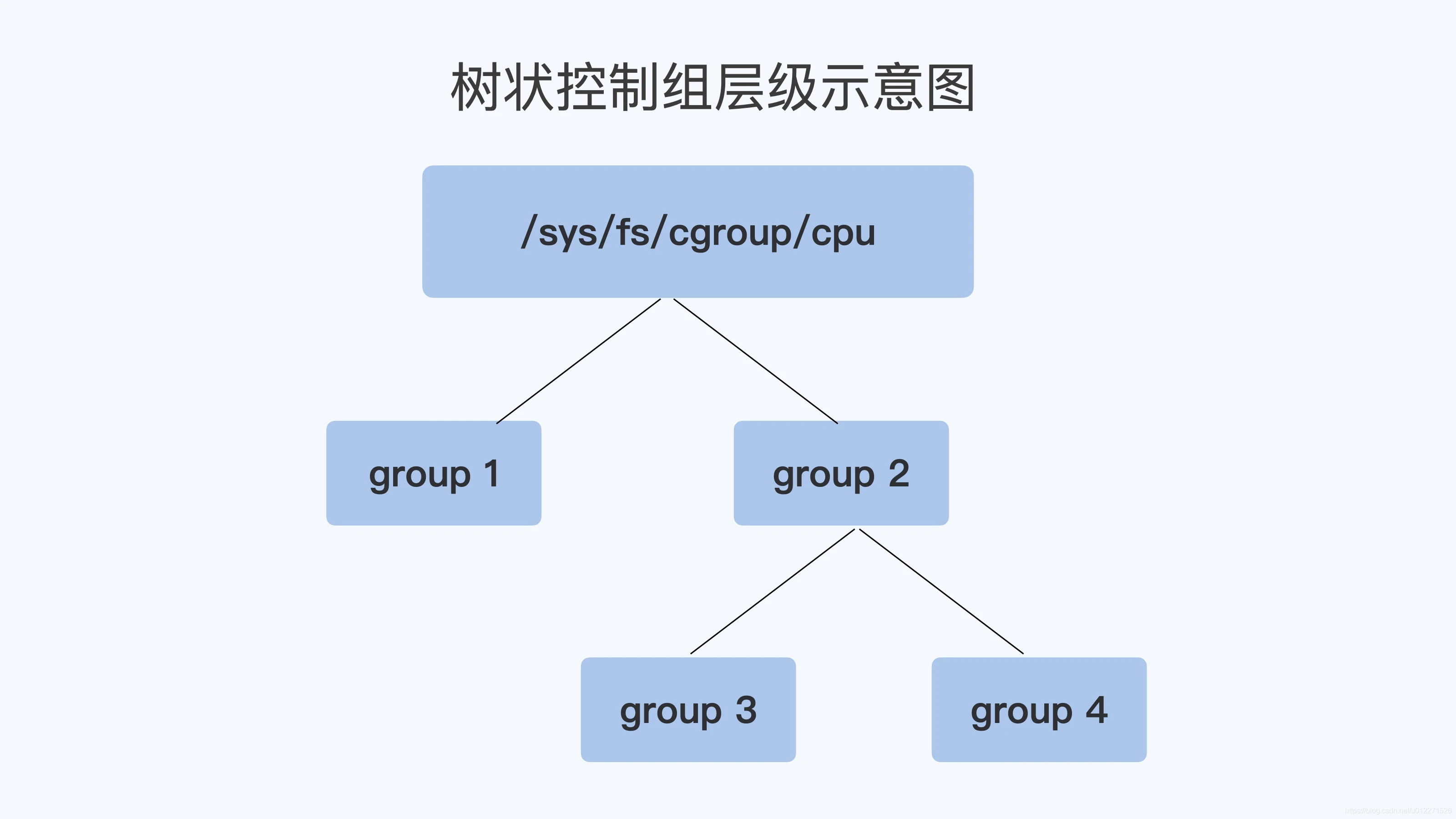

每个Cgroups 子系统都是通过一个虚拟文件系统挂载点的方式,挂到一个缺省的目录下,CPU Cgroup 一般在Linux 发行版里会放在 /sys/fs/cgroup/cpu 这个目录下。

在这个子系统的目录下,每个控制组(Control Group)都是一个子目录,各个控制组之间的关系就是一个树状的层级关系(hierarchy)

例如下图,每个group 就是一个控制组

自己创建一个目录 suhan1 控制组里面的内容如下,

[root@hx19-dev01 suhan1]# pwd/sys/fs/cgroup/cpu/suhan1[root@hx19-dev01 suhan1]# ls -l总用量 0-rw-r--r--. 1 root root 0 6月 25 10:20 cgroup.clone_children--w--w--w-. 1 root root 0 6月 25 10:20 cgroup.event_control-rw-r--r--. 1 root root 0 6月 25 10:20 cgroup.procs-r--r--r--. 1 root root 0 6月 25 10:20 cpuacct.stat-rw-r--r--. 1 root root 0 6月 25 10:20 cpuacct.usage-r--r--r--. 1 root root 0 6月 25 10:20 cpuacct.usage_percpu-rw-r--r--. 1 root root 0 6月 25 10:20 cpu.cfs_period_us-rw-r--r--. 1 root root 0 6月 25 10:20 cpu.cfs_quota_us-rw-r--r--. 1 root root 0 6月 25 10:20 cpu.rt_period_us-rw-r--r--. 1 root root 0 6月 25 10:20 cpu.rt_runtime_us-rw-r--r--. 1 root root 0 6月 25 10:20 cpu.shares-r--r--r--. 1 root root 0 6月 25 10:20 cpu.stat-rw-r--r--. 1 root root 0 6月 25 10:20 notify_on_release-rw-r--r--. 1 root root 0 6月 25 10:20 tasks

在云平台里,大部分程序都不是实时调度进程,而是普通调度(SCHED_NORMAL) 类型进程,那什么是普通类型进程呢。

目前Linux中的普通调度的算法是 CFS(Complete Fair Scheduler 即完全公平调度器),直接看CPU Cgroup 和CFS相关的参数,一共有三个。

-

cpu.cfs_period_us【固定值】:它是CFS算法的一个调度周期,一般值是 100000十万,单位是微秒,就是 100ms -

cpu.cfs_quota_us【实际值】:它表示CFS算法中,在一个调度周期里这个控制组被允许的运行时间,比如这个值为 50000时,就是 50ms。

如果用这个值除以调度周期(cpu.cfs_period_us)50ms/100ms=0.5,表示这个控制组被允许使用的CPU最大配额就是0.5个CPU

是一个绝对值,如果这个值是200000,也就是200ms,那么它除以 period,也就是200ms/100ms=2,超过了1 ,表示这个控制组需要2个CPU的资源 -

cpu.shares【1024比例】:表示 CPU Cgroup 对于控制组之间的CPU分配比例,缺省值是1024例如:

group3 中的cpu.shares 是1024,group4 中的 cpu.shares 是 3072,那么group3:group4 = 1:3比例说明什么呢:

在一台4个CPU 的机器上,当 group3 和 group4 都需要4个CPU的时候,它们实际分配到的CPU 分别是,group3是1个,group4是3个。

实际操作举例如下:

在一台4个CPU的机器上,按照上面的cpu.shares 比例,实际分配的情况是 group3 是1个,group4是3个。

示例代码链接,下载到本地后操作:

# 运行初始化的脚本:生成几个group文件夹,编译.c文件生成可执行文件$ bash training-main/cpu/cgroup_cpu/create_groups.sh

1.2.1 cpu.cfs_quota_us 示例

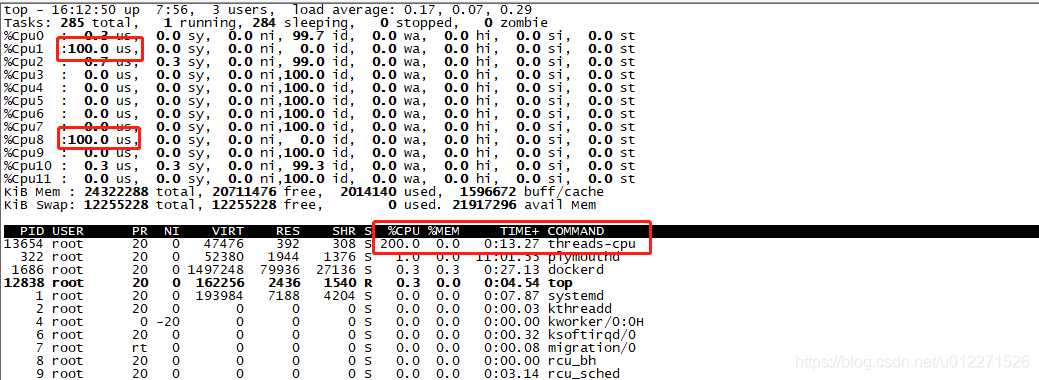

启动一个消耗2个CPU(200%) 的程序 threads-cpu,然后把这个pid加到group3的控制组里,命令如下:

$ ./training-main/cpu/cgroup_cpu/threads-cpu/threads-cpu 2 & echo $! > /sys/fs/cgroup/cpu/group2/group3/cgroup.procs

在没有修改 cpu.cfs_quota_us(实际值) 前,用top 命令可以查看到刚才启动的 threads-cpu 进程的cpu使用率如下图:

我的测试机器是8个CPU的

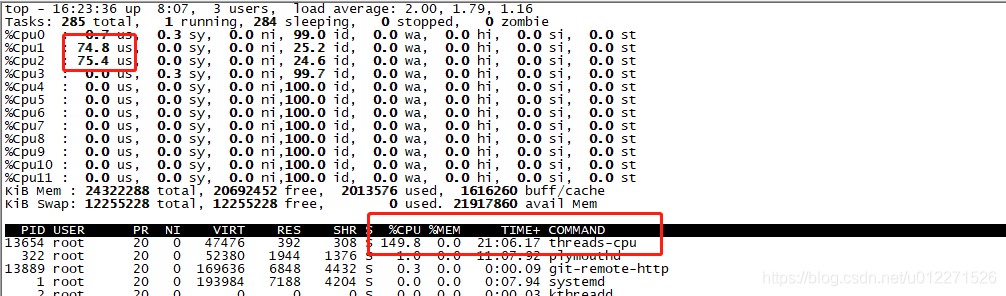

然后把这个控制组中的 cpu.cfs_quota_us 设置为 150000(150ms) ,这个值除以 cpu.cfs_period_us

即 150ms/100ms = 1.5 表示1.5个CPU ,同时把 cpu.shares 设置为 1024

echo 150000 > /sys/fs/cgroup/cpu/group2/group3/cpu.cfs_quota_usecho 1024 > /sys/fs/cgroup/cpu/group2/group3/cpu.shares

这个时候再运行 top,会发现 threads-cpu 进程的CPU 使用减少到了 150%。

这个就是因为cpu.cfs_quota_us起了作用,限制了进程CPU的绝对值

但是 cpu.shares在这里插入代码片 的作用还没发挥出来,因为它是控制各个控制组之间的CPU的比例

而且一定要到整个节点中的CPU 都跑满的时候它才能发挥作用

1.2.2 cpu.shares 示例

下面理解下 cpu.shares

按照上面的设置好 group3 中的 cpu.cfs_quota_us 和 cpu.shares;

然后启动第二个程序,设置好 group4 里面的 cpu.cfs_quota_us 和 cpu.shares;

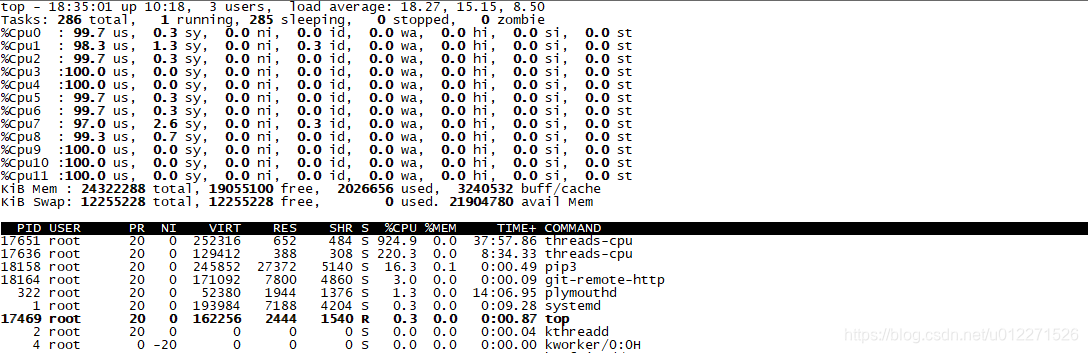

专栏中的测试机器是 4C 的,我这里使用的是 12C 的。

#group3中,启动一个占用4C的进程,并把 pid 写入到 group3 控制组里

$ ./threads-cpu/threads-cpu 6 &echo $! > /sys/fs/cgroup/cpu/group2/group3/cgroup.procs #group3 中设置好如下参数

$ cat /sys/fs/cgroup/cpu/group2/group3/cpu.cfs_quota_us 450000

$ cat /sys/fs/cgroup/cpu/group2/group3/cpu.shares 1024#group4中,启动一个占用8C的进程,并把pid写入到group4控制组里

$ ./threads-cpu/threads-cpu 12 &echo $! > /sys/fs/cgroup/cpu/group2/group4/cgroup.procs #group4 中设置好如下参数

$ echo 1050000 > /sys/fs/cgroup/cpu/group2/group4/cpu.cfs_quota_us

$ echo 3072 > /sys/fs/cgroup/cpu/group2/group4/cpu.shares

说明:

group3 启动6C,group4启动12C,把机器CPU跑满了;

group3 限制4.5C,group4限制10.5C;

group3:group4 的 shares值是 1:3按理说top 显示CPU 实际使用率应该是 1:3的。

我实际下来 和专栏里说的不一样。先放在这吧。

梳理:

- cpu.cfs_quota_us 和 cpu.cfs_period_us 这两个值决定了每个控制组中所有进程的可使用CPU资源的最大值;

- cpu.shares 决定了CPU Cgroup 子系统下控制组可用CPU的相对比例。只有当系统上CPU完全被占满的时候,这个比例才会在各个控制组间起作用;

1.3 现象解释

首先 kubernetes 为每个容器都在 CPU Cgroup 的子系统中建立一个控制组,然后把容器中进程写入到这个控制组中。

(1)Limit CPU 是容器可用的上限值:

容器CPU的上限值是由 cpu.cfs_quota_us 除以 cpu.cfs_period_us 得出的值决定的操作系统中 cpu.cfs_period_us 的值一般是个固定值,k8s不会去修改它,所以只修改 cpu.cfs_quota_us

(2)Request CPU :

整个节点CPU都占满的情况,容器可以保证的需要的CPU数目。

是靠 cpu.shares 这个参数在CPU Cgroup中 cpu.shares == 1024 表示1个CPU的比例,那么request CPU的值就是n,给 cpu.shares 的赋值对应就是 n*1024

1.4 重点总结

每个进程的CPU Usage 只包含了用户态(us 或 ni) 和 内核态(sy)两部分,其他的系统CPU开销并不包含在进程的CPU使用中,而 CPU Cgroup 只是对进程的CPU 使用做了限制

CPU Cgroup中的三个参数:

- cpu.cfs_quota_us:(一个调度周期里这个控制组被允许的运行时间) 除以 cpu.cfs_period_us

(调度周期)得到的值决定了 CPU Cgroup 每个控制组中CPU 使用的上限值。 - cpu.shares:决定了CPU Cgroup 子系统下控制组可用CPU的相对比例,当系统上CPU 完全被占满的时候,这个比例才会在各个控制组间起效。

- Limit CPU 就是容器所在 Cgroup 控制组中的CPU 上限值(cpu.cfs_quota_us),Request CPU 的值就是控制组中的 cpu.shares 的值。

二、评论

问题1:

为什么说“云平台里呢,大部分程序都不是实时调度的进程,而是普通调度(SCHED_NORMAL)类型进程”?这块不是很明白

回答1:

进程如果设置为SCHED_FIFO 或者SCHED_RR实时调度类型,那么只要进程任务不结束,就不会把cpu资源让给SCHED_NORMAL进程。这种实时的进程,在实时性要比较高的嵌入式系统中会用到,但是云平台中提供互联网服务的应用中不太会去用实时调度。

回答2:

cpu.shares是个相对值,但是在Linux节点上一般的约定是以值1024为1个CPU的比例,当所有的配置都遵守这个约定的时候,那么给值N*1024, 就表示N个CPU的数量了。

回答3:

一般对于容器,是一个cgroup控制组里限制容器中的所有进程。

回答4:

网络I/O 没有wa状态部分。

hi/si 对于磁盘都是有的。

回答5:

cpu.cfs_quota_us 取值为 -1 表示不限制。

问题6:

有个疑问:假设给容器配置了 1.5 的 CPU,而宿主机上只有 1 个 CPU,其实现在来说配置多少个 CPU 应该指的使用多少的 CPU 的时间对吗?( 而非简单地分配物理 CPU )

回答6:

是的,这是一个调度时间的分配,而不是把物理cpu 分配给容器的进程。

对于你说的这种情况,就是不限制cpu的使用时间了。

三、课程疑问

makefile 定义了一系列的规则来指定,哪些文件需要先编译,哪些文件需要后编译,哪些文件需要重新编译,甚至于进行更复杂的功能操作,因为 makefile就像一个Shell脚本一样,其中也可以执行操作系统的命令。

make是一个命令工具,是一个解释makefile中指令的命令工具

用gcc编译使用了POSIX thread的程序时通常需要加额外的选项,以链接到库。

此处直接加上-lpthread选项。

gcc xxx.c -o xxx -lpthread

这篇关于05|容器CPU(1):怎么限制容器的CPU使用?【request、limit】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!