activating专题

【论文阅读笔记】Activating More Pixels in Image Super-Resolution Transformer

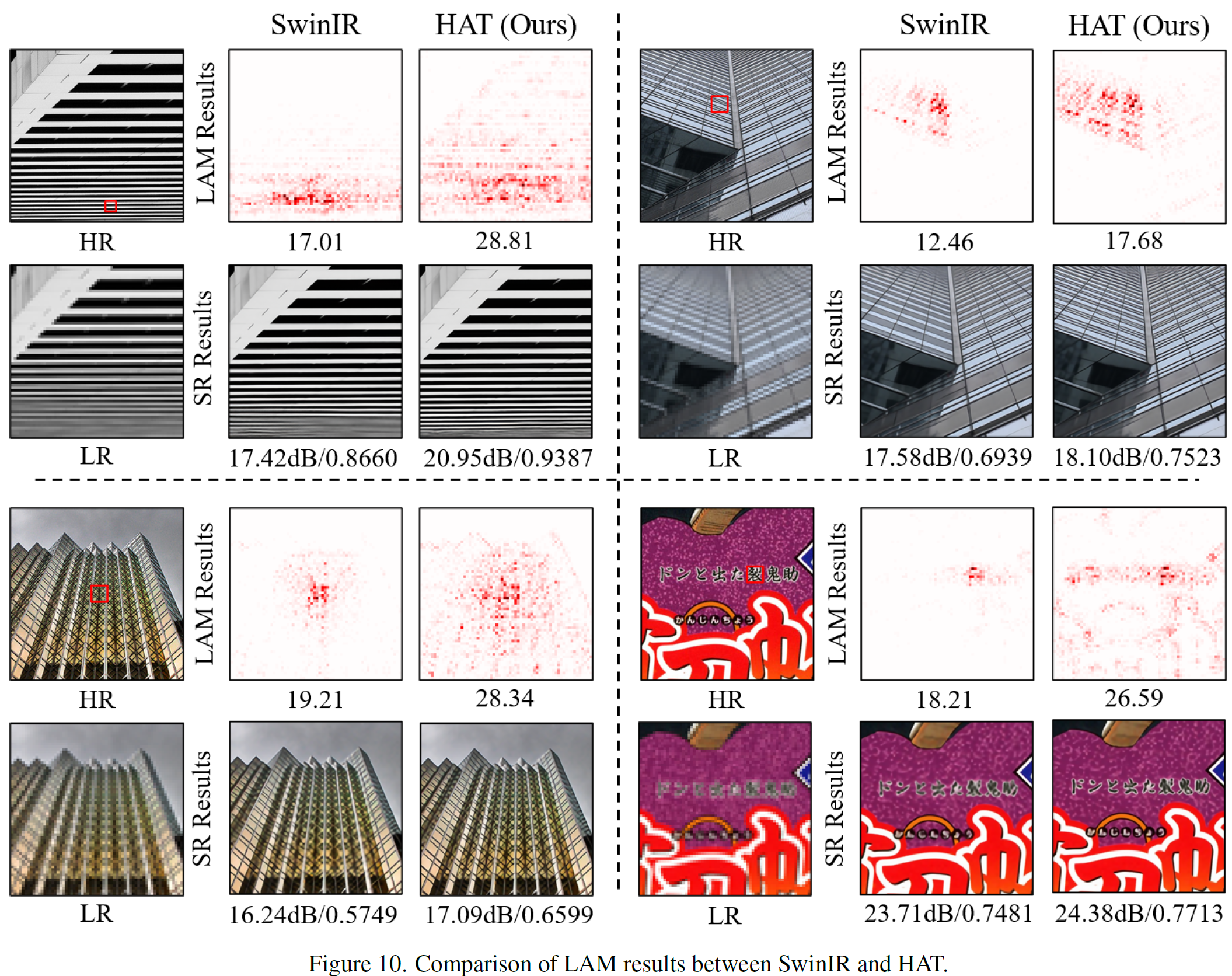

论文地址:https://arxiv.org/abs/2205.04437 代码位置:https://github.com/XPixelGroup/HAT 论文小结 本文方法是基于Transformer的方法,探索了Transformer在低级视觉任务(如SR)中的应用潜力。本文提升有效利用像素范围得到的网络,提出了一种混合注意力Transformer,命名为 HAT(Hybrid Att