24g专题

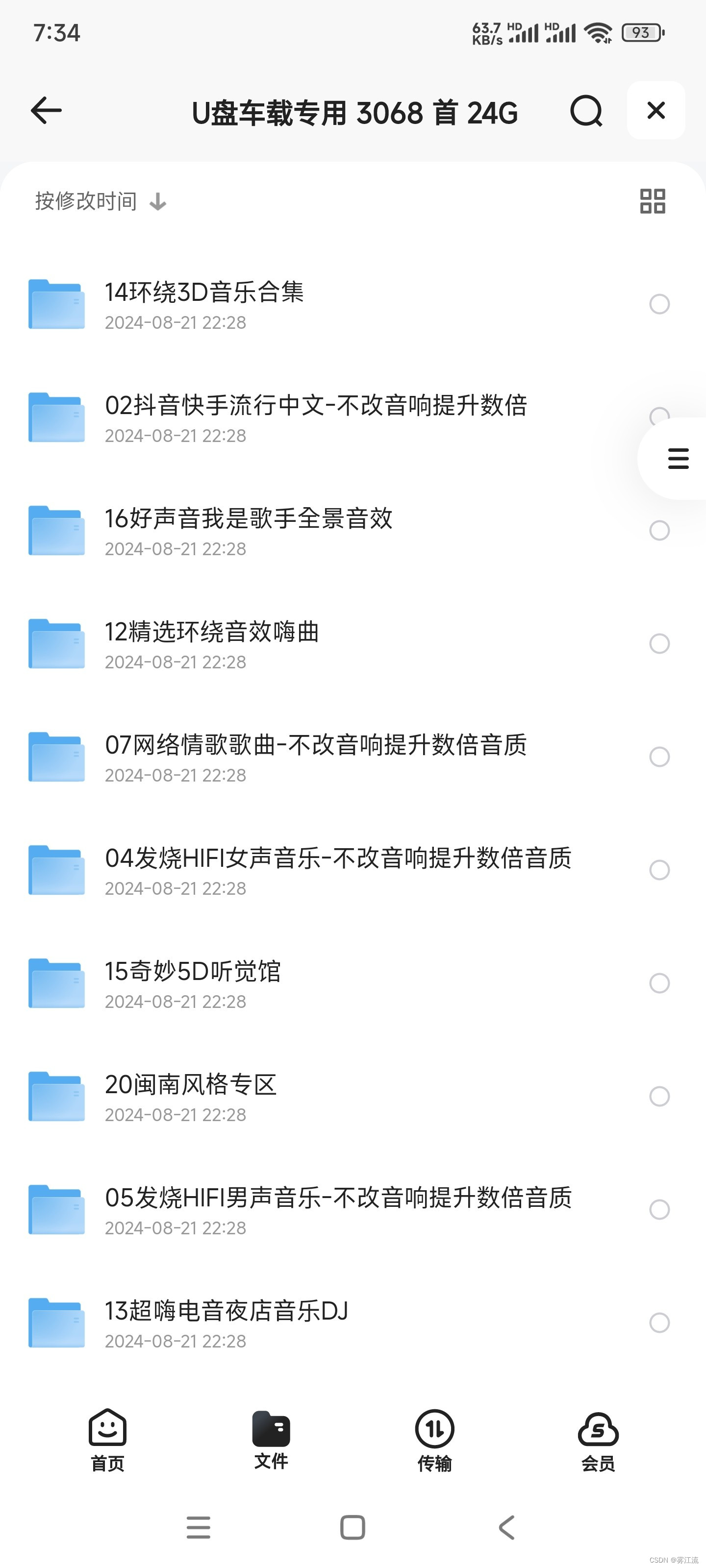

U盘车载专用音乐合集 3068首 24G

包含3068首适合车载播放的音乐。 拿走的麻烦评论一下,感谢!!! 拿走的麻烦评论一下,感谢!!! 拿走的麻烦评论一下,感谢!!! 链接:https://pan.quark.cn/s/482a8df9d0de 📁大小:24G 🏷标签:#U盘车载专用音乐合集 #音乐 #中国 #2024

性价比深度学习3090RTX显卡 24G显存 主机配置

工作学习需要配置的主机,来跑深度学习模型,2023年底11月配置的。低于市场价的为咸鱼等平台购买,具体如下,供参考 : 配件 单价(*数量)/元 CPU i5 13600kf

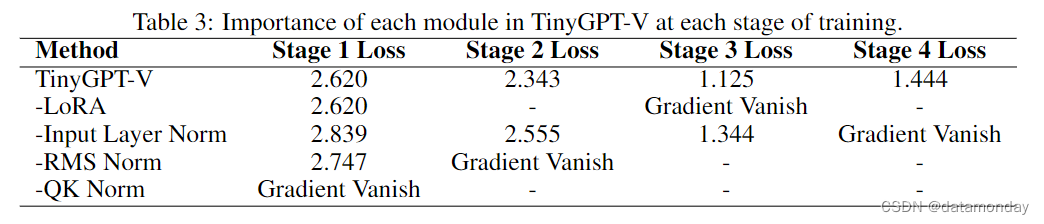

【LMM 012】TinyGPT-V:24G显存训练,8G显存推理的高效多模态大模型

论文标题:TinyGPT-V: Efficient Multimodal Large Language Model via Small Backbones 论文作者:Zhengqing Yuan, Zhaoxu Li, Lichao Sun 作者单位:Anhui Polytechnic University, Nanyang Technological University, Lehigh Un

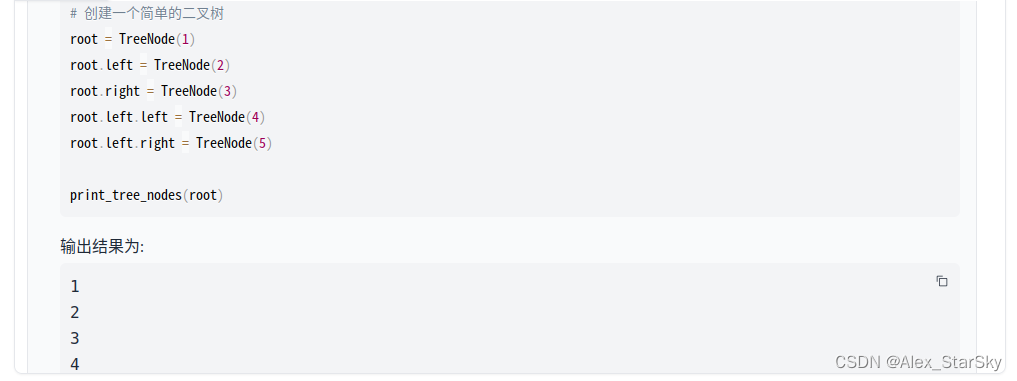

GPT实战系列-实战Qwen在Cuda 12+24G部署方案

GPT实战系列-实战Qwen在Cuda12+24G部署方案 ChatGLM4进行新闻发布,但还没有开源更新,在此之际,实战部署测试Qwen大模型。目前Qwen的口碑貌似还不错,测试显卡内存24G,毕竟有限,排除了Qwen14非量化方案Qwen-14B-Chat,只有 Qwen-7B-Chat,Qwen-7B-Chat-Int4,Qwen-14B-Chat-Int4 模型可用。测试过程中Qwen-

【LMM 012】TinyGPT-V:24G显存训练,8G显存推理的高效多模态大模型

论文标题:TinyGPT-V: Efficient Multimodal Large Language Model via Small Backbones 论文作者:Zhengqing Yuan, Zhaoxu Li, Lichao Sun 作者单位:Anhui Polytechnic University, Nanyang Technological University, Lehigh Un

GPT实战系列-ChatGLM3本地部署CUDA11+1080Ti+显卡24G实战方案

目录 一、ChatGLM3 模型 二、资源需求 三、部署安装 配置环境 安装过程 低成本配置部署方案 四、启动 ChatGLM3 五、功能测试 新鲜出炉,国产 GPT 版本迭代更新啦~清华团队刚刚发布ChatGLM3,恰逢云栖大会前百川也发布Baichuan2-192K,一时间掀起的国产AI大模型又一阵热浪来袭。 随着两个公司融资到位,国内大模型研究和开源活动,进展

GPT实战系列-ChatGLM3部署CUDA11+1080Ti+显卡24G实战方案

目录 一、ChatGLM3 模型 二、资源需求 三、部署安装 配置环境 安装过程 低成本配置部署方案 四、启动 ChatGLM3 五、功能测试 新鲜出炉,国产 GPT 版本迭代更新啦~清华团队刚刚发布ChatGLM3,恰逢云栖大会前百川也发布Baichuan2-192K,一时间掀起的国产AI大模型又一阵热浪来袭。 随着两个公司融资到位,国内大模型研究和开源活动,进展

新款24G智能马桶雷达模块 支持手势识别和人体距离识别

HLR41雷达模块的主要特点在于感应人体距离和手势识别,和智能马桶的使用场景完全契合,助力实现人体走近自动感应打开马桶、手势感应自动冲水等等功能。

GPT实战系列-ChatGLM2部署Ubuntu+Cuda11+显存24G实战方案

GPT实战系列-ChatGLM2部署Ubuntu+Cuda11+显存24G实战方案 自从chatGPT掀起的AI大模型热潮以来,国内大模型研究和开源活动,进展也如火如荼。模型越来越大,如何在小显存部署和使用大模型? 本实战专栏将评估一系列的开源模型,尤其关注国产大模型,重点在于可私有化、轻量化部署,比如推理所需的GPU资源控制在24G显存内。 目录 GPT实战系列-ChatGLM2部署Ub