175b专题

【文末附gpt升级秘笈】关于论文“7B?13B?175B?解读大模型的参数的论文

论文大纲 引言 简要介绍大模型(深度学习模型)的概念及其在各个领域的应用。阐述参数(Parameters)在大模型中的重要性,以及它们如何影响模型的性能。引出主题:探讨7B、13B、175B等参数规模的大模型。 第一部分:大模型的参数规模 定义“B”代表的意义(Billion/十亿)。解释7B、13B、175B等参数规模的具体含义和计算方法。举例说明这些参数规模的大模型(如GPT系列、BE

7B?13B?175B?解读大模型的参数

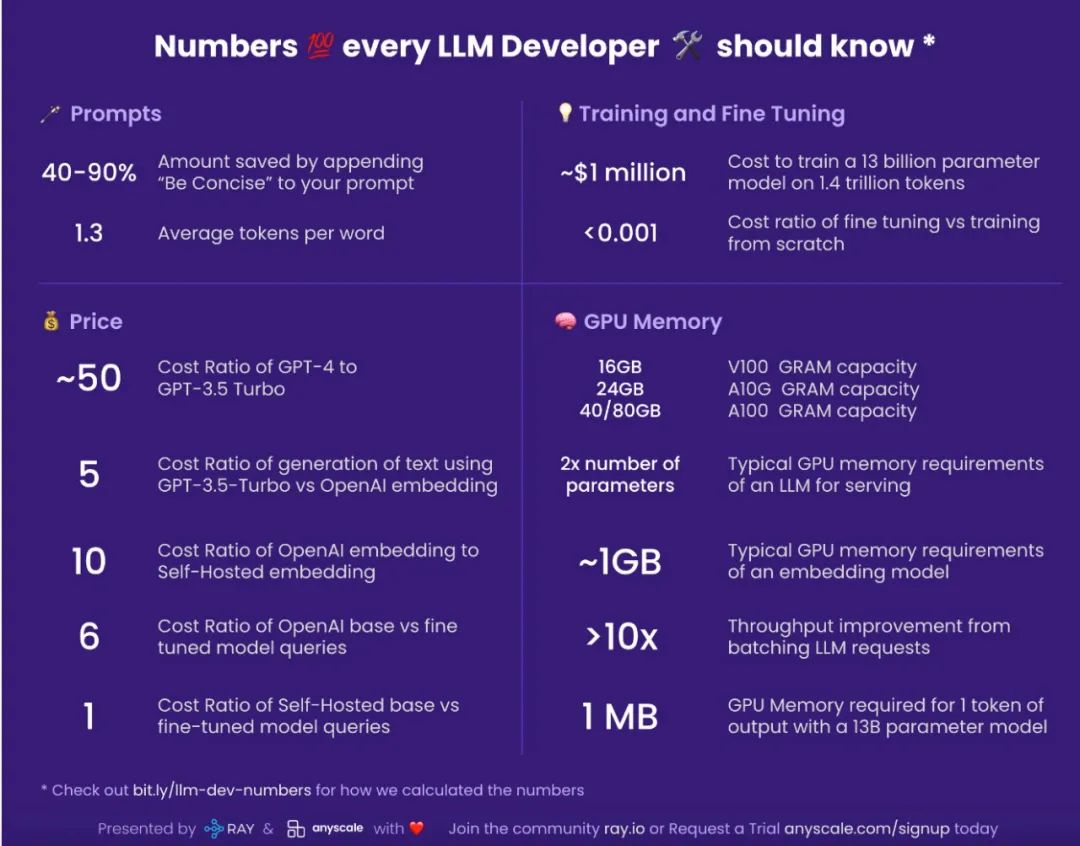

大模型也是有大有小的,它们的大小靠参数数量来度量。GPT-3就有1750亿个参数,而Grok-1更是不得了,有3140亿个参数。当然,也有像Llama这样身材苗条一点的,参数数量在70亿到700亿之间。 这里说的70B可不是指训练数据的数量,而是指模型中那些密密麻麻的参数。这些参数就像是一个个小小的“脑细胞”,越多就能让模型更聪明,更能理解数据中那些错综复杂的关系。有了这些“脑细胞”,模型在处